4.17 Notas históricas. La estadística Bayesiana

Sacado del libro La teoria que nunca murió (McGrayne 2012).

La regla de Bayes aparece escrita en el ensayo An Essay Towards Solving a Problem in the Doctrine of Chances (Un ensayo hacia la solución de problemas en la disciplina del azar). Este ensayo puede leerse al español traducido por M. Villegas (Villegas 2001).

Este trabajo lo escribió Thomas Bayes en la década de 1740, en medio de una polémica religiosa marcada por la siguiente cuestión: ¿es posible establecer conclusiones racionales relativas a la existencia de Dios, sobre la base de las pruebas que nos proporciona el mundo a nuestro alrededor? Concretamente, Bayes se plantéo si es posible conciliar la presencia del mal con la presunta bondad divina. En 1731, Bayes escribió su ensayo, en el que dice (entre otras muchas cosas) que Dios otorga a las personas «la máxima felicidad que les es dado alcanzar». Resulta curioso, primero, que haya sido un sacerdote quien creara una de las reglas del azar más utilizada a lo largo de la historia. Segundo, contrasta los sucesos de la existencia de Dios con la evidencia empírica que podría negar su existencia.

Cuando el reverendo Bayes falleció, sus parientes solicitaron a Richard Price, buen amigo del difunto, que revisara sus trabajos matemáticos. Price, que también era ministro de la Iglesia presbiteriana y matemático, alcanzaría posteriormente una notable fama como abogado de las libertades civiles y defensor de las revoluciones estadounidense y francesa. Personajes tan ilustes como Benjamin Franklin, John Adams y Thomas Jefferson (segundo y tercer presidente de Estados Unidos, respectivamente); la feminista Mary Wollstonecraft, que acostumbraba a acudir a su iglesia; el reformador del sistema penitenciario John Howard, que era su mejor amigo; y Joseph Priestley, el descubridor del oxígeno, fueron admiradores de su personalidad y conocimientos científicos.

En 1781, la Universidad de Yale concedió un doctorado honoris causa a Price, simultaneamente que a George Washington. Sin embargo, el nombre de Price es conocido, fundamentalmente, por sacar a la luz la regla de Bayes. Al empezar a estudiar los papeles de Bayes que le había dejado su familia, Price se encontró frente a una imperfecta solución a uno de los problemas más difíciles de la doctrina de las probabilidades. Se refería al ensayo que Bayes había compuesto a fin de indagar en la probabilidad de las causas, y, a partir de las observaciones relativas al mundo real, tratar de encontrar su causa más probable.

Price comprendió que el ensayo era la respuesta al ataque que David Hume (Edimburgo; 1711- 1776) había dirigido contra la teoría de la causalidad. De manera muy breve, podemos decir que toda predicción – consciente o inconsciente, científica o propia de la vida cotidiana – se funda en un razonamiento acerca de cuestiones de hecho, y este razonamiento depende por entero de la fe en el principio de causalidad. Cuando comemos un trozo de pan, no nos paramos a pensar en que el pan podría estar envenenado si no lo hemos sospechado, o que al caminar bajando unos escalones la tierra vaya a abrirse bajo nuestros pies. La sucesión natural de hechos a la que, cotidianamente, nos vamos acostumbrando (a una cosa le sigue otra, a la noche siempre le sucede el día porque nunca hubo -que se sepa- un día en que no saliera el sol) es la base de la experiencia que, a la vez, condiciona a la razón.

Y la cuestión fundamental que nos afecta era que, bajo dicha teoría, se mantenía la existencia de Dios como algo necesario, puesto que era la causa de, por ejemplo, la ocurrencia de los milagros históricamente señalados como ciertos por el cristianismo. El más destacado, la resurrección de Jesús. Hume (en innegable atrevimiento para la época), en su trabajo “On Miracles”, afirmaba que no debía darse validez a los reportes sobre milagros, puesto que no existía evidencia científica sobre los mismos y, por lo tanto, no debía tenerse por cierta la resurrección de Jesús, por mucho que existieran testimonios que lo aseverasen. En ningún caso debía irse más allá de la experiencia, y así, los conceptos metafísicos (Dios, mundo, alma) no tenían por qué ser inexorablemente ciertos.

Figura 4.31: El filósofo, economista, sociólogo e historiador David Hume.

En un trabajo dirigido a la Real Sociedad de Londres para el avance de la Ciencia, Price señaló que la regla de Bayes intentaba demostrar, matemáticamente, que «el mundo debía ser necesariamente una consecuencia de la sabiduría y el poder de una causa inteligente, de modo que con él se viene a confirmar […] partiendo de las causas finales […] la existencia de un Ser Divino». El trabajo se tituló: “A method of calculating the exact probability of all conclusions founded on induction”.

Hay que tener en cuenta que el ensayo de Bayes fue escrito bastantes años antes de que Laplace escribiera su famosa regla de los casos favorables entre casos posibles. La fórmula de la probabilidad total (y el teorema posterior) también son posteriores a la regla de Bayes. Es decir, Bayes dedujo su regla sin conocer no solo esto, sino la axiomática de Kolmogorov y las propiedades que se deducen de ella (que es como nosotros hemos calculado la probabilidad condicionada). En particular, Hume hacía referencia a los testimonios históricos existentes que apoyaban la resurrección de Cristo (los cuales existen y pueden buscarse en internet).

Utilizando el resultado formulado por Bayes, y con argumentos matemáticos del estilo de los utilizados por Bayes para su demostración, Richard Price concluyó lo siguiente: supongamos que \(p\) sea la probabilidad de que un hecho suceda en cada uno de \(n\) ensayos independientes (\(p\) podría ser la probabilidad de que ocurra un milagro en \(n\) dias consecutivos). Supongamos que este hecho ha ocurrido \(x\) veces. La distribución a posteriori para \(p\) bajo el supuesto de que todos los valores de \(p\), a priori, son igualmente probables, permite aceptar que, aunque el número \(x\) sea cero, la probabilidad \(p\) puede suponerse más grande que uno entre un millón seiscientos mil con probabilidad \(0.533\).

Este resultado no es fácil de obtenerse (por ello no lo exponemos) pero matemáticamente es correcto. Viene a decirnos que la probabilidad de un milagro en un dia concreto (aunque nunca se haya observado ninguno) es más grande que ese número (\(1/1.600.000\)) con probabilidad algo mayor que \(1/2\). Permite establecer una base matemática para la probabilidad de ocurrencia de un hecho muy anormal en la naturaleza:

Si \(p\) es la probabilidad de que un suceso (“milagro”) ocurra (tal como que mañana no salga el sol, en palabras de Price, o la resurrección de una persona), admitamos que \(p\) pueda ser \(1/1600000\). Esto es, admitimos que un milagro puede suceder, aunque con una probabilidad muy pequeña. Ahora nos planteamos: ¿Cuál es la probabilidad de que ocurra al menos un suceso de este tipo en un millón de ensayos independientes? (en el próximo millón de días, ¿cuál es la probabilidad de que ocurra algún milagro? -uno, al menos).

La probabilidad de que ocurra algún suceso puede calcularse como \(1\) menos la probabilidad del complementario (“no ocurra ningún suceso”), es decir \[ 1- \left(1-\dfrac{1}{1.600.000}\right)^{1.000.000} = 1- \left(\dfrac{1.599.999}{1.600.000}\right)^{1.000.000}\]

y este número es, aproximadamente, 0.46, lo cual no es tan pequeño.

Solución:

Según suponemos en el enunciado, la probabilidad de que un sueño NO sea profético es muy grande: \(9.999/10.000.\)

Por consiguiente, la probabilidad de que una persona tenga al menos un sueño profético al cabo de un año es \[1-P(no\ tenga \ ninguno)= 1-\left(\dfrac{9999}{10000}\right)^{365}=\] \[=1-(0.9999)^{365}=1-0.9641=0.0359.\]

Supongamos una población con 10 millones de adultos. Cada uno de ellos tiene probabilidad \(0.0359\) de tener al menos un sueño profético al año. Es decir, el 3.59 por ciento de los adultos (que son 3.590.000 adultos) tendrán al menos un sueño profético al año (lo cual, ciertamente, es un número muy alto).

Si se cambia la probabilidad inicial \(1/10.000\) por un número más pequeño, el porcentaje de personas con, al menos, un sueño profético al año, evidentemente disminuirá, pero seguirá siendo muy alto. Es por eso que en la prensa se recogen situaciones (verídicas) de gente que ha soñado con algo que se ha cumplido (accidentes de avión, etc.). Es evidente que somos muchas personas a soñar y se pueden tener muchos sueños diferentes. La probabilidad de que se cumpla algún sueño profético es alta, pero eso no significa que la persona que ha soñado algo que se ha cumplido tenga propiedades extrasensoriales.

Caso real:

![Un caso real de sueño profético [fuente: digital].](Figure/suenoprofetico.png)

Figura 4.32: Un caso real de sueño profético fuente: digital.

4.17.1 Aprendiendo de la experiencia: uso recursivo de la fórmula de Bayes

El teorema de Bayes y la fórmula de la probabilidad inversa no es sólo una fórmula. El uso de esta fórmula de una manera encadenada permite contemplar la probabilidad como una forma de conocimiento en función de la experiencia que se va adquiriendo.

Solución:

Llamemos \(E\)=“estar embarazada”. Nos dicen que

\[P(E)=0.15, \ P(+ \mid E)=0.9, \ P(+\mid \bar{E}) = 0.5\] Por el teorema de Bayes: \[P(E\mid +)=\frac{P(+\mid E)\cdot P(E)}{P(+)},\] y el denominador lo calculamos mediante el teorema de la probabilidad total: \[P(+)=P(+\mid E)\cdot P(E) + P(+\mid \bar{E})\cdot P(\bar{E})\] Entonces \[P(E\mid +)=\frac{0.9\cdot 0.15}{0.9\cdot 0.15+0.15\cdot 0.85}=\frac{0.135}{0.135+0.425}=\frac{0.135}{0.56}=0.241.\] Como en otras ocasiones, quizá sea posible entenderlo mejor mediante una tabla

| Embarazo | No Embarazo | Totales | |

|---|---|---|---|

| Test Positivo | \(0.9\cdot 0.15\) | \(0.5\cdot 0.15\) | |

| Test Negativo | |||

| Totales | \(0.15\) | \(1\) |

Completamos la tabla:

| Embarazo | No Embarazo | Totales | |

|---|---|---|---|

| Test Positivo | \(0.135\) | \(0.075\) | \(0.21\) |

| Test Negativo | \(0.015\) | \(0.775\) | \(0.79\) |

| Totales | \(0.15\) | \(0.85\) | \(1\) |

- Ahora supongamos que la mujer, para confirmar su estado, se realiza un nuevo test de embarazo y obtiene nuevamente un resultado positivo. Con esta información adicional, ¿cómo cambian las conclusiones?

Calculemos ahora la probabilidad de estar embarazada, sabiendo que el nuevo test ha dado positivo (la probabilidad de embarazo “a priori” ha cambiado a 0.241):

\[P(E\mid +)=\frac{P(+\mid E)\cdot P(E)}{P(+\mid E)\cdot P(E) + P(+\mid \bar{E})\cdot P(\bar{E})}=\] \[=\frac{0.9\cdot 0.241}{0.9\cdot 0.241+0.15\cdot 0.759}=0.364\] Si se repite sucesivamente el test de embarazo, obteniendo resultados positivos, la probabilidad de embarazo sería: \(Test 3 = 0.507,\ Test4=0.649,\ Test5= 0.769, \ Test 6= 0.857, \ Test7= 0.915 \cdots \ Test10=0.984\).

4.17.2 Ejemplos importantes de aplicación de la estadística Bayesiana

En el mencionado libro La teoría que nunca murió (McGrayne 2012) se describen con detalle ejemplos reales de aplicación de métodos estadísticos basados en la regla de Bayes o, mejor dicho, en la Estadística Bayesiana. El nombre de estadística Bayesiana surgió como una especie de alternativa a la estadística llamada frecuentista, la cual, básicamente, se formó a partir de los trabajos de Ronald Fisher de inferencia matemática. La estadística Bayesiana parte del principio de que los parámetros que describen una población no son valores fijos e inmutables, sino que son variables aleatorias con una distribución a priori determinada. Asimismo, considera que las probabilidades de los sucesos pueden ser subjetivas, e irse modificando a medida que se van conociendo datos del problema en el que se trabaje (como en el ejemplo del test de embarazo del apartado anterior).

Fue precisamente Ronald Fisher uno de los mayores objetores a este tipo de pensamiento, por cuanto consideraba que las probabilidades deben calcularse, bien a través de la frecuencia relativa, bien por la regla de Laplace, y que los parámetros de las poblaciones no podían considerarse variables, sino valores fijos que había precisamente que estimar. Este hecho fue quizá lo que motivó que las técnicas basadas en el pensamiento bayesiano fuesen menos difundidas e investigadas durante varias décadas. Además, la derivación de muchas técnicas de tipo bayesiano y la resolución de problemas asociados no pudieron llevarse a cabo hasta la existencia de ordenadores con capacidad de cálculo adecuada, por cuanto, en muchas ocasiones, conllevan aparejados problemas de tipo numérico importantes.

En realidad, la estadística bayesiana y la estadística frecuentista, si bien en un principio (primeras décadas del siglo XX) parecían formas de pensar contrapuestas, no lo son en absoluto. Hoy en dia existe un campo de trabajo y de aplicación de la estadística bayesiana muy amplio, tanto a nivel teórico como aplicado, del cual puede uno hacerse idea sin más que teclear los términos “bayesian inference” en google.

A continuación, citamos algunas aplicaciones de la estadística bayesiana que adquirieron popularidad:

El índice de paternidad: La fórmula descrita por Essen-Moller es una consecuencia del teorema de Bayes. Puede verse, por ejemplo, en (Mickey, Gjertson, and Terasaki 1986).

En problemas legales (juicios) existen numerosos ejemplos de utilización del teorema de Bayes. Uno de los más conocidos es la llamada

falacia del fiscal. The Guardian: A formula for justice . Asimismo, existen numerosos ejemplos de aplicación del teorema de Bayes para la resolución de casos judiciales. Muchos de ellos pueden consultarse en el libro de Gabriel Ruiz Garzón Condenados por la estadística (Ruiz-Garzón 2015).Busqueda de barcos perdidos: Busqueda Bayesiana. Un ejemplo de búsqueda de este tipo fue la realizada para localizar cuatro bombas atómicas que el ejercito americano perdió en el mar en Palomares (Almería), en 1966, tras el accidente aéreo de un B-52. El suceso terminó con el famoso baño del ministro Fraga y el embajador americano en la playa, para demostrar que no existía radioactividad alguna.

Figura 4.33: Fraga saludando a los cientos de estadísticos bayesianos que se agolparon en la playa, y que la censura franquista impidió ver.

En el paquete de R rSARP está implementada la busqueda bayesiana. El lector interesado encontrará en la viñeta (pequeño manual) del paquete anotaciones muy interesantes.

- Los filtros de spam del correo electrónico son un ejemplo sencillo de lo que se conoce como filtros bayesianos. Un gestor de correo electrónico debe decidir, a partir de un efecto (el mensaje de correo que contiene cosas raras, como caracteres extraños, mensajes en lengua extranjera, declaraciones de amor de desconocidos…) si la causa es un mensaje o no de spam (y filtrar o no dicho correo). Para ello, el gestor irá “aprendiendo” de los datos que el usuario le va enseñando paulatinamente, con lo cual la probabilidad de acierto crece con el tiempo.

También, las redes bayesianas son un ejemplo de utilización del resultado de Bayes en la inteligencia artificial (Castillo, Gutiérrez, and Hadi 1997);(García 2012).

- Los métodos actuariales proceden de la aplicación del teorema de Bayes a los seguros, a través de los trabajos del italiano Bruno de Finetti (1906-1985) (Bernardo 1998).

Figura 4.34: El estadístico italiano Bruno de Finetti.

El famoso caso Dreyfuss. wikipedia (1894–1906), referente a un militar judío francés injustamente acusado de espionaje y encarcelado en la isla del diablo. En una revisión de las pruebas presentadas contra el militar (entre cuyos testigos favorables destacó el matemático Henri Poincaré) se utilizó la regla de Bayes en varias ocasiones (Ruiz-Garzón 2015). En la sección El caso Dreyfuss detallamos este caso.

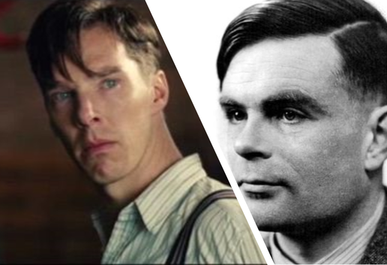

La descodificación de los códigos generados por la máquina alemana Enigma en la II guerra mundial: en Blentchley Park, un equipo de científicos dirigido por el matemático Alan Touring (considerado el padre de la informática) utilizó la regla de Bayes de manera continuada, parece que sin haberla conocido previamente. BlogElPais (Mardia and Cooper 2016) (Good 1979)

Figura 4.35: Izquierda: Benedict Cumberbach en el papel de Alan Touring en la pelicula “The imitation game” (2015). Derecha: el verdadero Alan Touring.

La invasión alemana de Rusia en la II guerra mundial: como Kolmogorov usó la regla de Bayes para conseguir mejorar la precisión de la artilleria rusa contra el ejercito alemán que estuvo a punto de entrar en Moscú (Kolmogorov and Hewitt 1948).

Cálculo del riesgo de explosión de una bomba nuclear por accidente durante la guerra fría. (Barrett, Baum, and Hostetler 2013)

Estos y más ejemplos son citados y ampliamente comentados y documentados en el libro de Sharon McGrayne (McGrayne 2012).

References

Barrett, Anthony M, Seth D Baum, and Kelly Hostetler. 2013. “Analyzing and Reducing the Risks of Inadvertent Nuclear War Between the United States and Russia.” Science & Global Security 21 (2). Taylor & Francis: 106–33.

Bernardo, José Miguel. 1998. “Bruno de Finetti En La Estadistica Contemporanea.” Historia de La Matématica En El Siglo XX, S. Rios (Ed.), Real Academia de Ciencias, Madrid, 63–80.

Castillo, Enrique, José Manuel Gutiérrez, and Ali S Hadi. 1997. “Sistemas Expertos Y Modelos de Redes Probabilisticas.” Academia de Ingenieria.

García, Alberto. 2012. Inteligencia Artificial: Fundamentos, Práctica Y Aplicaciones. Rc Libros.

Good, Irving J. 1979. “Studies in the History of Probability and Statistics. Xxxvii Am Turing’s Statistical Work in World War Ii.” Biometrika. JSTOR, 393–96.

Kolmogorov, Andreĭ Nikolaevich, and Edwin Hewitt. 1948. “Collection of Articles on the Theory of Firing.” Rand Corporation.

Mardia, Kanti V, and S Barry Cooper. 2016. “Alan Turing and Enigmatic Statistics.”

McGrayne, S.B. 2012. La Teoría Que Nunca Murió. Crítica.

Mickey, MR, DW Gjertson, and PI Terasaki. 1986. “Empirical Validation of the Essen-Möller Probability of Paternity.” American Journal of Human Genetics 39 (1). Elsevier: 123.

Paulos, J.A., and J.M. Llosa. 1990. El Hombre Anumérico: El Analfabetismo Matemático Y Sus Consecuencias. Matatemas (Tusquets Editores). Tusquets.

Ruiz-Garzón, G. 2015. Condenados Por La Estadística. Servicio de Publicaciones de la Universidad de Cadiz.

Villegas, Miguel Angel Gómez. 2001. “El Ensayo Encaminado a Resolver Un Problema En La Doctrina Del Azar.” Revista de La Real Academia de Ciencias Exactas, Físicas Y Naturales 95 (1). Real Academia de Ciencias Exactas, Físicas y Naturales: 81–85.