8.4 La teoría de Neyman-Pearson

Buscando fortalecer las bases lógicas de los test de significación de Fisher, Egon Pearson (1895-1980) (hijo de Karl Pearson) y Jerzy Neyman (1894-1981) idearon varias mejoras. El eje principal de su investigación era el siguiente interrogante: ¿qué hacer si se obtiene un resultado significativo en un test estadístico? Se rechaza la hipótesis nula, pero los test de significación no arrojaban ninguna pista sobre qué hipótesis elegir a cambio.

La teoría de Neyman-Pearson utilizó el NHST de Fisher y el \(p\)-valor como parte de un proceso formal de decisión. Así, plantearon una elección real entre dos hipótesis rivales. El contraste de hipótesis quedó convertido en un método para discernir entre dos hipótesis: la hipótesis nula y la hipótesis alternativa \(H_1\).

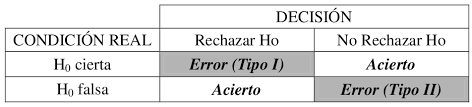

Todo contraste de hipótesis conduce pues, a aceptar o rechazar la hipótesis nula planteada (aceptando, en este último caso, la hipótesis alternativa). Ahora bien, pueden darse las siguientes situaciones.

Se acepta la hipótesis nula siendo verdadera. Esta es una decisión correcta.

Se rechaza la hipótesis nula siendo falsa. Esta es otra situación correcta.

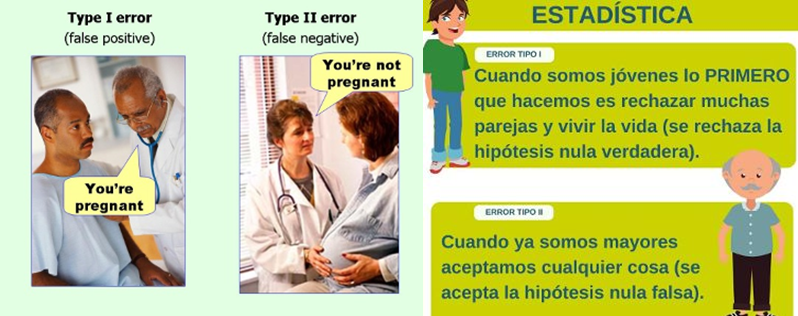

Se rechaza la hipótesis nula siendo verdadera. Estamos cometiendo un error, que se llama error de tipo uno. La probabilidad de cometer este error viene dada por el nivel de significación \(\alpha\), fijado de antemano.

Se acepta la hipótesis nula siendo falsa. También cometemos un error, que se llama error de tipo II. La probabilidad de cometer este error se representa por \(\beta\), y la probabilidad \(1-\beta\) se llama potencia del contraste, que cuantifica la probabilidad de rechazar la hipótesis nula cuando es falsa.

Figura 8.3: Posibles opciones en un test de hipótesis.

Veamos. Si tenemos una hipótesis nula: \(H_0\): un tratamiento nuevo no es efectivo, frente a \(H_1:\) el tratamiento sí es efectivo siempre es posible construir más de un test de hipótesis para contrastar la hipótesis nula frente a la alternativa.

Por ejemplo, tiramos una moneda al aire. Si sale cara, aceptamos \(H_0\). Si sale cruz, rechazamos \(H_1\).

La probabilidad de cometer un error de tipo I es \(0.5\), igual que la probabilidad de cometer un error de tipo II.

Si en vez de tirar una moneda tiramos un dado y decidimos mediante la regla: “aceptamos la hipótesis nula si sale un 1, la rechazamos si sale cualquier otro número”, la probabilidad de error de tipo I es \(5/6\) y la de error de tipo II es \(1/6\).

Obviamente ambos test son bastante absurdos, pero nos sirve para ver que siempre existen test con sus correspondientes errores.

Figura 8.4: Ejemplos errores tipo I y II.

Un acusado ante un tribunal:

\(H_0: inocente\)

\(H_1: culpable\)El error de tipo I es rechazar que es inocente, siéndolo.

El error de tipo II es rechazar que es culpable, cuando es inocente.

Si se ponen las hipótesis al revés: \(H_0: culpable\) frente a \(H_1: inocente\) se comprueba enseguida que los errores de tipo I y tipo II se permutan.

Una alarma de incendio. Cuando suena una alarma, ante un exceso de calor, o bien que un gamberro ha acercado un mechero al sensor (se ve en las películas), la alarma puede sonar y no haber fuego.

\(H_0: fuego\)

\(H_1: no fuego\)

El error de tipo I es rechazar que hay fuego, cuando en realidad lo hay. El error de tipo II es aceptar que hay fuego, cuando en realidad no lo hay.

Con estos dos ejemplos, podemos ver que no es posible disminuir simultáneamente la probabilidad de error de tipo I y la probabilidad de error de tipo II: una opción para no cometer errores de tipo I en el caso de un juicio sería declarar inocente a casi todo el mundo, lo cual conlleva a cometer muchos errores de tipo II. En el caso de la alarma, puede hacerse que el aparato no tenga demasiada sensibilidad, para que no haya falsas alarmas, pero esto puede hacer peligrar el hecho de que, ante un incendio de verdad, la alarma no se active.

Neyman y Pearson demostraron que, en bastantes circunstancias, una vez fijada la probabilidad \(\alpha\) de error de tipo I -esto es, una vez acotado el porcentaje de veces que tomaremos una decisión equivocada al rechazar la hipótesis nula cuándo es verdadera- es posible construir y utilizar contrastes de máxima potencia, es decir, contrastes que minimizan la probabilidad \(\beta\), o de error de tipo II (o sea, maximizan la llamada potencia del test: su sensibilidad o capacidad para detectar que la hipótesis nula es falsa).

Este último párrafo seguro que apesta a matemáticas. Por si alguien no se había dado cuenta, para decidir entre dos hipótesis (la nula y la alternativa) podemos, habitualmente, realizar más de un test o proceso de decisión.

Supongamos que queremos elegir entre:

\(H_0: inocente\) frente a \(H_1: culpable\)

podemos revisar las pruebas, interrogar a los testigos, etc. y tomar una decisión. Habrá una probabilidad de error de tipo I y una probabilidad de error de tipo II (1- potencia).

Pero se podría decidir simplemente tirando una moneda al aire. La probabilidad de cometer un error de tipo I es \(0.5\). Igual que la potencia del test (1- probabilidad de error de tipo II).

Ahora, en vez de tirar una moneda tiramos un dado. Si sale el 1, decidimos que el acusado es culpable, y si no es inocente. La probabilidad de cometer un error de tipo I es \(1/6\). La potencia es la probabilidad de rechazar la hipótesis nula siendo falsa, es decir \(5/6\) (el que el acusado sea inocente o culpable no va a influir en el resultado del lanzamiento de la moneda; son sucesos independientes).

Vemos que reglas de decisión diferentes ocasionan probabilidades de error diferentes. En una situación “seria”, las hipótesis a elegir son de tipo estadístico. La forma de decidir será alguna función también de tipo estadístico (va a ser una variable aleatoria). A partir de ella calcularemos las probabilidades de error.

Supongamos que hay \(2\) posibles formas de decidir (\(2\) variables aleatorias). Neymann y Pearson dijeron que la mejor manera de decir entre ambas es mantener para ambas la misma probabilidad de error de tipo I, y luego elegir la que dé mayor potencia (o menor probabilidad de error de tipo II) (Mismo valor de \(\alpha\), máxima potencia).

En un célebre resultado publicado en \(1933\), Neyman y Pearson probaron que en el caso de hipótesis rivales simples (que asignan valores específicos al parámetro desconocido) existe automáticamente una clase de test óptimos, de bajo tamaño y máxima potencia: los basados en la razón de verosimilitudes. Los contrastes de hipótesis que se utilizan en los casos prácticos, cuando se quiere saber, por ejemplo, si un tratamiento es efectivo, o si una proporción en una muestra aproxima una proporción real (caso de una encuesta electoral) son los propuestos mediante la teoría de Neyman y Pearson.

Quiere esto decir que son los que, desde un punto de vista matemático, son mejores para decidir entre la hipótesis nula y alternativa. Ya hemos visto antes que podemos construir muchos procedimientos de decisión (por ejemplo, tirando una moneda al aire). Aunque se puedan pensar procedimientos matemáticos más correctos, los test de Neyman y Pearson son óptimos desde el punto de vista antes comentado.