6.5 El teorema central del límite

En el resultado anterior, veíamos que la suma de variables aleatorias normales es otra variable aleatoria normal. Sin embargo, la normalidad de una suma de variables no se limita solo a las variables normales. El teorema central del límite es un resultado matemático que garantiza que, si sumamos variables cualesquiera (no necesariamente normales), la variable suma también seguirá una distribución normal (esto siempre que se cumplan algunas condiciones básicas).

Así, cuando un dato o resultado es la suma de contribuciones independientes, de igual magnitud y “con un tamaño típico”, este resultado corresponderá a una distribución Gaussiana siempre que el número de contribuciones (el número de sumandos) sea un número considerable (no pequeño).

Con un tamaño típico se quiere garantizar que las contribuciones tienen que “estar controladas”, esto es, las contribuciones extremas tienen que estar controladas por una probabilidad muy pequeña (En jerga matemática las contribuciones tiene que tener varianza finita).

Este teorema asegura, de manera esquemática, que, cuando sumamos un número grande de variables, la variable resultante sigue una distribución normal.

De manera general, si \(X_{\mathrm{1}},X_{\mathrm{2}},...,X_n\) son variables de media o esperanza \({\mu }_i\mathrm{=}E\mathrm{(}X_i\mathrm{)}\) y varianza \({\sigma }^{\mathrm{2}}_i\mathrm{=}Var\mathrm{(}X_i\mathrm{),} \ i\mathrm{=1,...,}n,\) se verifica que la variable suma \(Y\mathrm{=}X_{\mathrm{1}}\mathrm{+}X_{\mathrm{2}}\mathrm{+...+}X_n\) (si \(n\) es un número tendiendo a infinito) se puede aproximar por una variable normal, de media la suma de las medias y varianza la suma de varianzas (desviación típica = raiz de la suma de varianzas), es decir \[Y\mathrm{=}X_{\mathrm{1}}\mathrm{+}X_{\mathrm{2}}\mathrm{+...+}X_n\ \mathrm{\approx }\ N\left(\sum^n_{i\mathrm{=1}}{}{\mu }_i,\sqrt{\sum^n_{i\mathrm{=1}}{}{\sigma }^{\mathrm{2}}_i}\right).\]

Este teorema (del que damos únicamente una idea general, sin establecer las hipótesis matemáticas reales) establece la importancia de la distribución normal. Su resultado es que, cuando se suma un número grande de variables aleatorias, la variable resultante es una variable con distribución aproximadamente igual a la distribución normal. Incluso, el término número grande(porque matemáticamente el teorema se establece cuando \(n\) tiende a infinito) no lo es tanto, porque, en la práctica, con tener que \(n\) sea un número mayor o igual a \(30\), la aproximación ya proporciona buenas resultados.

Además, el teorema es cierto independientemente de la distribución que sigan las variables que se sumen (no importa si son exponenciales, binomiales, etc.). Lo único que se necesita es saber su media y su varianza.

consumo de petroleo (gas, electricidad... ) de una ciudad es la suma de los consumos individuales de las familias o particulares. Por ello la distribución de esta variable (consumo) va a seguir una distribución normal.

tiempo de realización de un proyecto complejo (como construir una casa, un submarino, un avión, una red de carreteras, un oleoducto…) es la suma de los tiempos de las distintas tareas que componen el proyecto. A pesar de que habrá tareas que tendrán un tiempo fijo, la mayoría serán variables con diferente tiempo medio y diferente variación. Pero la suma de los tiempos seguirá una distribución normal, y se podrán calcular probabilidades de finalización en un tiempo determinado (y a su vez el coste de este tiempo).

La proporción de una característica A en una muestra sigue una distribución normal. Comprobémoslo.

La proporción muestral de una característica A es el número de veces que dicha característica \(A\) aparece en una muestra. Por ejemplo, si \(A\) representa tener una enfermedad cualquiera, \(p=P(A)\) es la probabilidad de que una persona tenga la enfermedad.

Si se seleccionan, de manera independiente, \(n\) personas, tenemos una muestra de \(n\) individuos de esa población, y la proporción muestral es: \[\hat{p}=\dfrac{\text{número de individuos en la muestra con esa enfermedad}}{n}\] En vez de tener una enfermedad, \(A\) puede representar estar de acuerdo o no con algo, tener trabajo o no, etc (cualquier cosa que admita solo 2 posibilidades complementarias).

Cada vez que consideramos una persona, podemos considerar la variable de Bernoulli \(X\)=tiene la enfermedad (o característica) A. Esta variable toma los valores \(1\) con probabilidad \(p\) y \(0\) con probabilidad \(1-p\).

De esta manera, la proporción muestral que acabamos de definir se puede considerar como \[\hat{p}=\dfrac{X_1+X_2+...X_n}{n},\] donde \(X_1\) es la variable \(X\) en el individuo \(1\),…, \(X_n\) es la variable \(X\) en el individuo \(n\), es decir vale \(1\) o \(0\) en cada individuo, según tenga la característica \(A\) o no la tenga.

De manera que, si \(n\) es grande, por el teorema central del límite, la variable suma \(X_1\)+\(X_2\)+…+\(X_n\) se aproximará mediante una distribución normal, de media la suma de las medias (cada variable de Bernoulli tiene de media \(p\)) y de desviación típica la raiz cuadrada de la suma de varianzas (y cada variable de Bernoulli tiene de varianza \(p\cdot (1-p)\)). En consecuencia, la variable suma \(Y\) verificará: \[Y=X_1+X_2+...+X_n \ \mathrm{\approx } \ N(\mu,\sigma)\] donde \(\mu= p+p+...+p=np\) y \(\sigma= \sqrt{p\cdot (1-p)+...+p\cdot (1-p)} = \sqrt{np(1-p)}\).

Supongamos ahora que lanzamos una moneda. La variable \(X\) que vale \(1\) si sale cara y \(0\) si sale cruz es una variable de Bernoulli. Si lanzamos una moneda, por ejemplo, \(200\) veces, la variable que mide el número de caras que salen es una suma de \(200\) variables (\(X_i\) cuenta \(1\) o \(0\) si sale cara en el lanzamiento \(i\)).

Supongamos que repetimos esta operación \(10\) veces (cada operación es lanzar la moneda \(200\) veces). La primera vez pueden salir \(115\) caras, la segunda \(94\), etc. Se supone que el número de caras andará cerca de \(100\) (es la media, \(200\cdot 0.5\)).

Podemos simular el experimento con R:

y=rbinom(10,200,0.5)

y ## [1] 102 94 98 103 114 109 94 90 109 109Si en vez de repetirlo \(10\) veces, lo hacemos \(1000\), tenemos mil valores de la variable. Dibujamos su histograma:

y=rbinom(1000,200,0.5)

hist(y, col="lightblue")

abline(v=100, col="red")Como vemos, se parece mucho a la campana de Gauss, con media \(100\) y desviación típica \(\sqrt{200\cdot 0.5 \cdot 0.5}=7.071.\)

Consideremos de nuevo una proporción. Según acabamos de ver, la proporción muestral es \[\hat{p}=\dfrac{X_1+X_2+...X_n}{n},\] y, como la suma de arriba es aproximadamente una distribución normal, de parámetros media \(np\) y varianza \(np(1-p)\), la proporción muestral también sigue aproximadamente una distribución normal. \[\hat{p}=\dfrac{X_1+X_2+...X_n}{n} \approx N\left( \dfrac{np}{n},\sqrt{ \dfrac{np(1-p)}{n^2}}\right)=N\left( p, \sqrt{ \dfrac{p(1-p)}{n}}\right)\]

La proporción de gente en la muestra que dirá “NO”, cuando le preguntemos si cree que el hombre llegó a la luna, será un número más o menos cercano a \(0.57\) (quizá no demasiado, puesto que \(50\) son pocas personas).

Podemos simular en R el proceso de preguntar a \(50\) personas hoy, mañana, pasado y así, por ejemplo, durante \(20\) días:

y=rbinom(20,50,0.57)

y/50 # proporción en cada muestra de 50 personas## [1] 0.32 0.60 0.66 0.56 0.60 0.54 0.54 0.54 0.56 0.56

## [11] 0.56 0.56 0.60 0.62 0.66 0.58 0.58 0.46 0.54 0.64Si en vez de repetirlo \(20\) días, lo hacemos \(1000\), tenemos mil valores de la proporción muestral, y, como antes, podemos dibujar su histograma:

y=rbinom(1000,50,0.57)/50

hist(y, col="lightblue")

abline(v=0.57, col="red") Vemos, por lo tanto, que la proporción muestral toma valores cuya distribución es aproximadamente normal, de media la verdadera proporción \(p\) y desviación típica \(\sqrt{p(1-p)/n}\), en este caso \(\sqrt{0.57(1-0.57)/1000}=0.015.\)

Son, precisamente, este tipo de resultados un fuerte apoyo de la teoría del muestreo, en la cual se fundamentan las encuestas de opinión o electorales. Si las muestras de la población en la que se realiza un sondeo son relativamente grandes, se puede precisar con bastante fiabilidad la opinión de una población a través de la muestra, y la variabilidad existente en esta “opinión muestral”.

Solución

La variable \(T\)=tiempo que tarda Zenón en comer un jabalí tiene media \(12\) y varianza \(9\).

Por lo tanto, la variable que mide el tiempo en comer \(50\) jabalíes sigue, aproximadamente, una distribución normal de media \(50\cdot 12\) y varianza \(50\cdot 9\). Es, por lo tanto, aproximadamente \(N(600,\sqrt{450})=N(600,21.21)\).

Así, la probabilidad pedida es \[ P(\text{tiempo total}<570)=P(Z<\frac{570-600}{21.21}) = P(Z<-1.41)=0.0786. \]

6.5.1 Para pensar un poco: genética.

Galton se dio cuenta que en variables como la estatura aparecen dos efectos principales que hay que tener en cuenta: Los efectos genéticos (la estatura de los padres) y los que no lo son. Ahora bien, ya hemos hablado de que los padres altos tienden a tener descendencia alta, aunque exista una regresión a la media. Pero, curiosamente, debería existir una cierta clase dentro de la población total (los altos) cuya descendencia debería ser más bien alta; al igual que los padres bajos deberían tener descendencia más bien baja.

Esta situación puede expresarse de la siguiente manera: supongamos que elegimos dos números reales positivos concretos \(x_0\) e \(y_0\), y buscamos todos los pares de padres verificando que uno de ellos mide \(x_0\) unidades de altura y el otro \(y_0\) unidades de altura. A continuación, buscamos en todos los descendientes de estos pares de padres. Se puede suponer que existe una cierta función \(f\) que denota el efecto genético de las alturas de los padres en la altura de la descendencia, y una variable aleatoria \(W\) que denote los efectos aleatorios en las alturas de la descendencia. Luego, para un conjunto dado de alturas de padres \({x_0, y_0}\), la variable aleatoria que representa las alturas de la descendencia está dada por \[H = f(x_0,y_0) + W.\]

Si suponemos que el efecto de \(f\) es grande en comparación con el efecto de \(W\), entonces la varianza (variabilidad) de \(W\) será pequeña. Pero, como \(f\) es determinista, la varianza de \(H\) es igual a la varianza de \(W\), por lo que la varianza de \(H\) también será pequeña. Sin embargo, Galton observó de sus datos que la varianza de las alturas de la descendencia de un determinado par de la altura de los padres no es pequeña. Esto parece implicar que la herencia juega un papel pequeño en la determinación de la altura de un individuo.

Ahora consideremos la explicación moderna de por qué ciertos rasgos, tales como las alturas, se distribuyen normalmente. Para hacerlo, necesitamos introducir alguna terminología del campo de la genética. Las células en un organismo vivo que no están directamente involucradas en la transmisión de material genético a la descendencia se llaman células somáticas, y las células restantes se llaman células germinales. Los organismos de una especie dada tiene su información genética codificada en conjuntos de entidades físicas, llamados cromosomas. Los cromosomas están emparejados en cada célula somática.

Por ejemplo, los seres humanos tienen 23 pares de cromosomas en cada célula somática. Las células sexuales contienen un cromosoma de cada par. En la reproducción sexual, dos células sexuales, una de cada padre, contribuye con sus cromosomas para crear el conjunto de cromosomas para la descendencia. Los cromosomas contienen muchas subunidades, llamadas genes. Los genes consisten en moléculas de ADN, y un gen tiene, codificado en su ADN, información que conduce al registro de proteínas. En el presente contexto, consideraremos aquellos genes que contienen información que tiene un efecto sobre algún rasgo físico, como la altura. El emparejamiento de los cromosomas da lugar a un emparejamiento de los genes.

En una especie dada, cada gen puede ser de varias formas. Estas formas se llaman alelos. Los diferentes alelos producen diferentes efectos en un rasgo físico en cuestión. De los dos alelos que se encuentran en un par de genes dado en un organismo, uno de los alelos proviene del padre y el otro alelo de la madre. Los posibles tipos de pares de alelos (sin tener en cuenta el orden) se llaman genotipos.

Si suponemos que la altura de un ser humano está en gran medida controlada por un gen, estamos asumiendo que cada padre tiene un par de alelos que controla en gran medida su altura. Debido a que cada padre contribuye con un alelo de este par de genes a cada uno de sus descendientes, hay cuatro posibles pares de alelos para la descendencia en esta ubicación del gen. La suposición es que estos pares de alelos controlan en gran medida la altura de la descendencia, y también suponemos que los factores genéticos superan a los factores no genéticos. Se sigue que entre la descendencia deberíamos ver varios modos en la distribución de la altura; un modo correspondiente a cada posible par de alelos.

Una hipótesis alternativa que explica la observación de los alturas en la descendencia de un sexo dado, es la hipótesis de múltiples genes. Debajo esta hipótesis, suponemos que hay muchos genes que afectan a la altura de un individuo. Estos genes pueden diferir en la cantidad de sus efectos. Por lo tanto, podemos representar cada par de genes por una variable aleatoria \(X_i\), donde el valor de cada variable es el efecto del par de alelos en la altura del individuo. Por lo tanto, por ejemplo, si cada padre tiene dos alelos diferentes en el par de genes en consideración, entonces la descendencia tiene uno de cuatro posibles pares de alelos en esta ubicación del gen. Ahora, la altura de la descendencia es una variable aleatoria, que se puede expresar como \[H = X_1 + X_2 + \ldots + X_n + W,\] si hay \(n\) genes que afectan a la altura (aquí, como antes, la variable aleatoria \(W\) denota los efectos no genéticos). Aunque \(n\) es fijo, si es bastante grande, entonces el teorema central del límite garantiza que \(X_1 + X_2 + \ldots + X_n\) tiene una distribución aproximadamente normal. Ahora, si suponemos que la suma tiene un efecto acumulativo significativamente mayor que \(W\), entonces \(H\) tiene una distribución aproximadamente normal.

Otra característica observada de la distribución de las alturas de los adultos de un sexo en una población es que la varianza no parece aumentar o disminuir de una generación a la siguiente. Esto era conocido en el momento de Galton, y sus intentos de explicar esto lo llevó a la idea de la regresión a la media.

Usando la hipótesis de múltiples genes, es fácil explicar por qué la varianza debería ser constante de generación en generación. Comenzaremos por suponer que, para una ubicación específica de un gen, hay \(k\) alelos que denotaremos por \(A_1, A_2, \ldots, A_k\). Supongamos que la descendencia se produce por apareamiento aleatorio. Consideramos el conjunto \(S\) de todos los alelos (en un gen concreto) en todas las células germinales de todos los individuos en la generación principal. En términos del conjunto \(S\), por apareamiento aleatorio queremos decir que cada par de alelos en \(S\) es igualmente probable que resida en cualquier descendencia en particular. Para \(1 \leq i \leq k\), sea \(p_i\) la proporción de alelos en la población de padres que son de tipo \(A_i\). Está claro que esto es lo mismo que la proporción de alelos en las células germinales de la población de origen, suponiendo que cada padre produce aproximadamente la misma cantidad de células germinales.

Consideremos la distribución de alelos en la descendencia. Como cada célula germinal tiene la misma probabilidad de ser elegida para cualquier descendencia en particular, la distribución de alelos en la descendencia es la misma que en los padres. A continuación, consideramos la distribución de genotipos en las dos generaciones.

La distribución de genotipos en la generación de descendientes depende solo de la distribución de los alelos en la generación principal (en particular, no depende de la distribución de genotipos en la generación principal). Las frecuencias de los genotipos dependerá únicamente de las frecuencias de los alelos en la generación principal.

Esto significa que si comenzamos con cierta generación y cierta distribución de alelos, en todas las generaciones posteriores a una considerada, tanto el alelo como la distribución del genotipo serán corregidas. Esta última declaración es conocida como la Ley Hardy-Weinberg.

La ley de Hardy-Weinberg -llamada así por el matemático G. H. Hardy (1877-1947) y el médico alemán Wilhelm Weinberg (1862-1937)-, es un principio fundamental que los genetistas utilizan en el estudio de la evolución de las poblaciones. En términos sencillos, la ley de Hardy-Weinberg afirma que, si una gran población se aparea de forma totalmente aleatoria (y no sufre los efectos de mutaciones, migraciones o selecciones), la constitución genética permanece constante de una generación a la siguiente.

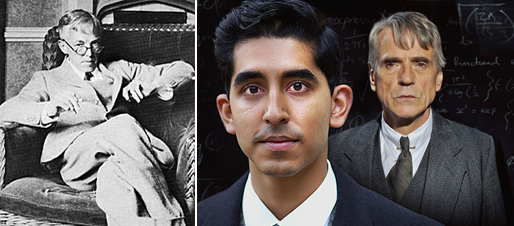

Figura 6.25: G. H. Hardy, que fue interpretado por Jeremy Irons en la película El hombre que conocía el infinito.

Podemos describir las consecuencias de esta ley para la distribución de alturas entre adultos de un sexo en una población. Recordamos que la altura de una descendencia viene dada por una variable aleatoria \(H\), donde \[H = X_1 + X_2 + \ldots + X_n + W,\] con las \(X_i\) correspondientes a los genes que afectan a la altura, y la variable aleatoria \(W\) que denota efectos no genéticos.

La ley de Hardy-Weinberg establece que, para cada \(X\), la distribución en la generación descendiente es la misma que la distribución en la generación de padres. Por lo tanto, si suponemos que la distribución de \(W\) es aproximadamente la misma de generación en generación (o si suponemos que sus efectos son pequeños), entonces la distribución de \(H\) es la misma de generación en generación. De hecho, los efectos de la nutrición forman parte de \(W\), y está claro que en muchas poblaciones humanas, las dietas han cambiado bastante de una generación a otra en los últimos tiempos. Se cree que este cambio es una de las razones por las cuales los humanos, en promedio, estamos creciendo. Asímismo, también se cree que los efectos de W son pequeños en relación con la efectos de los padres (la genética).

Obviamente, este razonamiento puede realizarse no solo con la estatura, sino con cualquier otra variable característica de los seres humanos, para entender la importancia de la herencia en el desarrollo de dichas características en generaciones posteriores.