Kapitel 3 Zufallsvariable und deren Verteilungen

Lernziele

- Zufallsvariable erkennen und von deterministischen Variablen abgrenzen können

- Unterschiede zwischen diskreten und stetigen Zufallsvariablen kennen

- Wahrscheinlichkeitsfunktionen darstellen, erkennen und damit Wahrscheinlichkeiten ermitteln können: Binomial-, Poisson-, hypergeometrische Verteilung

- Dichtefunktionen darstellen, erkennen und damit Wahrscheinlichkeiten ermitteln können: Normal-, Lognormal-, Exponentialverteilung

- Anwendungsbeispiele für die Verteilungen kennen

- Parameter der Verteilungen kennen und interpretieren können

- Verteilungsfunktion kennen

- Erwartungswert, Varianz und Kovarianz aus den Wahrscheinlichkeits- bzw. Dichtefunktionen herleiten können

- Darstellung von zweidimensionalen Zufallsvariablen

Wenn wir ein zufälliges Experiment betrachten, interessieren wir uns häufig nicht für den exakten Ausgang sondern für bestimmte Ereignisse, die sich auf den Ausgang des Experimentes beziehen. Beispielsweise im Fall eines Schusses auf eine Zielscheibe interessiert z.B. nicht die exakte Lage des Einschusses, sondern eine davon abgeleitete zufällige Größe, der Abstand zum Mittelpunkt.

Allgemein formuliert kann man sagen, in einem zufälligen Experiment in einem Wahrscheinlichkeitsraum \((\Omega,\mathcal{A},\mathbb P)\) interessieren wir uns nicht für das Ergebnis \(\omega\), sondern für einen Wert \(f(\omega)\), welcher mithilfe einer Abbildung vom Ergebnisraum in einen anderen messbaren Raum definiert ist, d. h. \(f: \Omega \to \Omega'\). Wir betrachten also Ereignisse der Form \[f^{-1}(A'):=\{\omega\in \Omega: f(\omega)\in A'\}\] wobei \(A'\) die im Bildraum von \(f\) interessierenden Ereignisse durchläuft. Die Abbildung \(f\) ist dann eine Zufallsgröße, also als Definition zusammengefasst. Für die Bezeichnung von Zufallsvariablen werden üblicherweise Großbuchstaben verwendet (also z.B: \(X\) anstelle von \(f\)).

Definition 3.1 (Zufallsvariable) Seien ein Wahrscheinlichkeitsraum \((\Omega,\mathcal{A},\mathbb P)\) und ein messbarer Raum \((\Omega',\mathcal{A}')\). Dann heißt die Funktion \(X: \Omega \to \Omega'\) Zufallsgröße oder Zufallsvariable, falls \(X^{-1}(\mathcal A') \subset \mathcal A\).

Formal ist eine Zufallsvariable also eine Zuordnungsvorschrift, die jedem möglichen Ergebnis eines Zufallsexperiments eine Größe zuordnet. Der Name Zufallsvariable ist etwas weniger passend als der Begriff Zufallsgröße, da es sich weniger um eine Variable als um eine Abbildung, also eine Zuordnungsvorschrift handelt. Weitere Beispiele für Zufallsvariablen wären z.B. der Ausgang eines Münz- oder Würfelwurfes, die Anzahl der Jungen unter den Kindern einer Familie oder die Verspätungen bei der Abfahrtzeit eines Zuges.

Eng verknüpft mit dem Begriff der Zufallsvariablen ist die sogenannte Wahrscheinlichkeitsverteilung. Die Verteilung \(P_X\) einer Zufallsvariablen \(X\) wird definiert als Bildmaß des Wahrscheinlichkeitsmaßes \(\mathbb P\), d.h.:

Definition 3.2 (Wahrscheinlichkeitsverteilung) Sei \(X\) eine Zufallsgröße, also eine Abbildung von einem Wahrscheinlichkeitsraum in einen Ereignisraum, \(X: (\Omega,\mathcal{A},\mathbb P) \to (\Omega',\mathcal{A}')\). Das Wahrscheinlichkeitsmaß \(P^X:\mathcal A' \to [0,1]\) definiert durch \[P_X(A):=\mathbb P(X^{-1}(A)), \quad A \in \mathcal A'\] heißt dann Verteilung von \(X\).

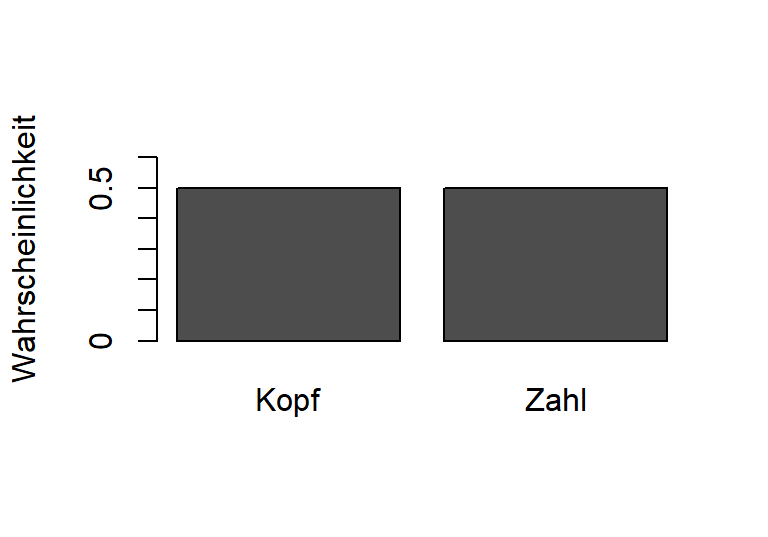

Man kann also sagen, eine Wahrscheinlichkeitsverteilung ist eine Zuordnung von möglichen Ausgängen eines Zufallsexperimentes zu der jeweiligen Wahrscheinlichkeit. Beispielsweise ist die Verteilung für das Experiment eines fairen Münzwurfs gegeben durch die zugeordneten Wahrscheinlichkeiten für Kopf und Zahl, vgl. Abb. 3.1, also:

\[P(\text{,,Kopf''}) = 0,5, \quad P(\text{,,Zahl''}) = 0,5\]

Abbildung 3.1: Grafische Darstellung der Wahrscheinlichkeitsverteilung beim Münzwurf

Im Folgenden lernen wir konkrete Beispiele für Verteilungen kennen.

3.1 Diskrete Verteilungen

Eine Zufallsvariable folgt einer statistischen Verteilung. Wenn die Zufallsvariable nur eine abzählbare Anzahl von Werten annehmen kann, ist die zugehörige Verteilung diskret. Dazu gehören insbesondere Verteilungen, die nur für bestimmte Werte der Zufallsvariable definiert sind (beispielsweise \(\{Kopf, Zahl\}\) beim Münzwurf oder \(\{1,2,3,4,5,6\}\) beim Würfelwurf).

Definition 3.3 (diskrete Zufallsvariable) Eine Zufallsvariable \(X\) heißt diskret verteilt, wenn eine abzählbare Menge \(B = \{b_1,b_2,\dots\} \subset {\mathbb R}\) existiert mit \(\mathbb P({X\in B})=1\).

Formal ausgedrückt heißt dies, dass bei diskreten Verteilungen die Ergebnismenge abzählbar ist, so dass die Wahrscheinlichkeitsverteilung durch Angabe der Wahrscheinlichkeiten der einzelnen Elementarereignisse eindeutig bestimmt ist. Die Funktion, welche diese Zuordnung bestimmt, nennen wir Wahrscheinlichkeitsfunktion. Wenn Sie Wahrscheinlichkeiten für diskrete Zufallsvariablen bestimmen möchten, beispielsweise für die Augenzahl 1, 2 oder 3 beim Würfelwurf, dann können Sie, weil diskret, die einzelnen Wahrscheinlichkeiten aufsummieren: \(\tfrac{1}{6} + \tfrac{1}{6} + \tfrac{1}{6} = \tfrac{3}{6} = \tfrac{1}{2}\).

3.1.1 Binomialverteilung

Die Binomialverteilung ist eine der wichtigsten diskreten Verteilungen. Sie wird angewendet auf Zufallsexperimente mit genau zwei Ausgängen, die statistisch als Erfolg bzw. Misserfolg bezeichnet werden. Dies ist keine Wertung der Ausgänge, sondern eine Konvention. Die beiden Ausgänge müssen dabei nicht gleich wahrscheinlich sein. Allerdings muss bei Wiederholung des Zufallsexperiments die Erfolgs- bzw. Misserfolgswahrscheinlichkeit über die Versuche hinweg konstant bleiben. Zudem müssen die Wiederholungen unabhängig von einander sein, d.h. die Ergebnisse aus den vorhergehenden Versuchen dürfen die Ergebnisse der Folgeversuche nicht beeinflussen.

Beispiele für binomialverteilte Zufallsvariable sind z.B.:

- Geschlecht des Kindes ist Junge oder Mädchen.

- Münzwurf; das Ergebnis ist hier entweder „Kopf“ oder „Zahl“.

- Kunde kauft ein Produkt oder nicht

- Patient wird geheilt oder nicht

- Jäger trifft ein Reh oder nicht.

Die Binomialverteilung wird darüber hinaus von Versicherern angewandt, wenn diese die Anzahl der Versicherungsfälle in einem Bestand von Versicherten mit gleichem Alter und gleichem Geschlecht modellieren. Darüber hinaus wird die Binomialverteilung auch zur Optionsbewertung eingesetzt. Der Ausgangspunkt ist dann die Tatsache, dass das Basisinstrument, meist eine Aktie, in der betrachteten Periode entweder im Wert steigen oder fallen kann – also wiederum ein Zufallsexperiment mit zwei möglichen Ausgängen.

Die Binomialverteilung wird mittels ihrer Wahrscheinlichkeitsfunktion definiert:

Definition 3.4 (Binomialverteilung) Eine Zufallsvariable \(X\) folgt einer Binomialverteilung mit Parametern \(n\in \mathbb N\), \(p \in [0,1]\), in Kurznotation \(X \sim B(n,p)\), wenn sie folgende Wahrscheinlichkeitsfunktion hat: \[P({X=k})= B(n,p)(k):=\dbinom{n}{k} \cdot p^k (1-p)^{n-k}\\=\frac{n!}{k!(n-k)!} \cdot p^k (1-p)^{n-k}, \quad k=0,1,\dots,n.\]

Dabei ist \(X\) die Zufallsvariable, und die Binomialverteilung hat zwei Parameter: \(n\) und \(p\). \(n\) ist die Anzahl der Versuche, \(p\) ist die Erfolgswahrscheinlichkeit. Der erste Term in der Wahrscheinlichkeitsfunktion ist der Binomialkoeffizient:

\[\dbinom{n}{k}=\frac{n!}{k!(n-k)!}\]

Der Ausdruck \(x!\) wird Fakultät von \(x\) gelesen und steht für das Produkt aller natürlichen Zahlen von 1 bis \(x\):

\(1! = 1\)

\(2! = 1\cdot 2 = 2\)

\(3! = 1 \cdot 2 \cdot 3 = 6\)

\(4! = 1 \cdot 2 \cdot 3 \cdot 4 = 24\)

\(5! = 1 \cdot 2 \cdot 3 \cdot 4 \cdot 5 = 120\) usw.

Hieraus erkennen Sie, dass sich Binomialkoeffizienten häufig kürzen lassen:

\[5! = 3! \cdot 4 \cdot 5 = 4! \cdot 5 = 120\] \[\dbinom{5}{3}=\frac{5!}{3!(5-3)!}=\frac{3!\cdot 4\cdot 5}{3!\cdot 2}=2\cdot 5=10\]

Beispiel 3.1 (Wahrscheinlichkeit für die Anzahl an Jungen mit der Binomialverteilung)

Mittelwert und Varianz einer binomialverteilten Zufallsvariable lassen sich einfach ermitteln:

\[\overline{x}=n \cdot p\] \[s^2=n \cdot p \cdot (1-p)\]

Für große \(n\) bzw. \(k\) wird die Binomialverteilung rechenaufwendig und dadurch fehleranfällig. Es besteht jedoch die Möglichkeit, die Binomialverteilung durch eine andere, einfacher handhabbare Verteilung anzunähern („zu approximieren“). Falls die Erfolgswahrscheinlichkeit bei der Binomialverteilung nahe bei 0,5 liegt, ist die Verteilung nahezu symmetrisch und kann durch eine Normalverteilung approximiert werden. Wenn das p weit entfernt von 0,5 liegt, d. h. nahe an 0 oder an 1, dann ist die Approximationsgüte bei der Normalverteilung nicht ideal. In diesem Fall sollte sie mit der Poissonverteilung angenähert werden, welche wir als Nächstes kennenlernen. Die Approximation funktioniert für große n besonders gut.

3.1.2 Poissonverteilung

Die Poissonverteilung ist ebenfalls eine diskrete Verteilung. Sie hat zwei wesentliche Anwendungsgebiete:

- Modellieren der Anzahl seltener Ereignisse in einem Zeitabschnitt und

- Approximation einer asymmetrischen Binomialverteilung.

Beispiele für den ersten Punkt könnten sein: Anzahl der Tore in einem Fußballspiel, Anzahl der Bankkunden, die innerhalb einer Stunde in der Schalterhalle eintreffen, um Kontoauszüge zu drucken – auf dieser Grundlage entscheidet die Bank, wie viele Drucker sie in der Schalterhalle vorhält – oder die Anzahl der Fehler, die einer Verwaltungsangestellten beim Bearbeiten von Rechnungen unterlaufen.

Sie werden sich daran erinnern, dass die Binomialverteilung von Versicherern angewandt wird, wenn diese die Anzahl der Versicherungsfälle in einem Bestand von Versicherten mit gleichem Alter und gleichem Geschlecht modellieren. Die Poissonverteilung kommt für Versicherte mit unterschiedlichem Alter oder unterschiedlichem Geschlecht zum Einsatz. Außerdem wird die Poissonverteilung für die Frequenzverteilung von Naturkatastrophen angewandt, die beispielsweise in der Gebäudeversicherung zu Auszahlungen durch Versicherer führen.

Definition 3.5 (Poissonverteilung) Eine Zufallsvariable \(X\) folgt einer Poissonverteilung mit Parameter \(\lambda>0\), in Kurznotation \(X \sim P_\lambda\), wenn sie folgende Wahrscheinlichkeitsfunktion hat: \[P({X=k})= P_\lambda(k)=e^{-\lambda}\frac{\lambda^k }{k!}, \quad k=0,1,\dots\]

Die Poissonverteilung hat nur einen Parameter, der meist mit Lambda \(\lambda\) oder \(\mu\) bezeichnet wird. Das Symbol \(e\) steht für die Eulersche Zahl (\(e\approx2,71828\)), benannt nach dem Schweizer Mathematiker Leonhard Euler (1707-1783).

Beispiel 3.2 (Schadensverteilung mit der Poissonverteilung)

3.1.3 Hypergeometrische Verteilung

Fragen wir uns noch einmal, wie groß die Wahrscheinlichkeit ist, im Lotto zu gewinnen. Beim Lotto werden Kugeln ohne Zurücklegen gezogen, d. h., jede Kugel kann nur ein Mal in der Stichprobe vorkommen. Dadurch ändert sich bei jedem Zug die Wahrscheinlichkeit, denn es ist bei jedem Zug eine andere Zahl an Kugeln in der Urne.

Definieren wir nun eine Zufallsvariable, die die Anzahl der Erfolge in einer Stichprobe misst. In der Grundgesamtheit haben wir eine gewisse Anzahl Erfolge (nennen wir sie „\(e\)“) und eine gewisse Anzahl Misserfolge („\(m\)“). \(n\) ist die Anzahl der Versuche. Dann ist \(X\) hypergeometrisch verteilt mit drei Parametern \(N_e\) , \(N_m\) und \(n\), wobei \(N_e\) (\(N_m\)) die Anzahl der Erfolge (Misserfolge) in der Grundgesamtheit ist. Demnach gilt \(N_e+N_m=N\), der Umfang der Grundgesamtheit. Wenn wir weniger häufig ziehen als wir Erfolge oder Misserfolge in der Grundgesamtheit haben, d.h. \(n≤\min(N_e,N_m\)), dann kann \(X\) die Werte 0, 1, 2, 3, 4 usw. annehmen und

\[P(X=k)=\frac{\dbinom{N_e}{k} \dbinom{N_m}{n-k}}{\dbinom{N_e+N_m}{n}}\]

Mit \(N=N_e+N_m\) und \(M=N_e\) erhalten wir eine etwas andere Parametrisierung, welche wir als Definition für die hypergeometrische Verteilung benutzen:

Definition 3.6 (Hypergeometrische Verteilung) Eine Zufallsvariable \(X\) folgt einer hypergeometrischen Verteilung mit Parametern \(N\), \(M\leq N\) und \(n\leq N\), in Kurznotation \(X \sim H(N,M,n)\), wenn sie folgende Wahrscheinlichkeitsfunktion hat: \[P(X=k)=H(N,M,n)(k):=\frac{\dbinom{M}{k} \dbinom{N-M}{n-k}}{\dbinom{N}{n}},\] für \(\quad k\in \Omega = \{\max\{0,n+M-N\},\dots,\min\{n,M\}\}\).

Beispiel 3.3 (Ziehen ohne Zurücklegen mit der hypergeometrischen Verteilung)

Sie sollten nun mit der hypergeometrischen Verteilung so vertraut sein, dass wir uns dem Lottospiel 6 aus 49 zuwenden können. Bei diesem Spiel werden 6 Zahlen aus einer Grundgesamtheit von 49 Zahlen ohne Zurücklegen zufällig ausgewählt. Wenn Sie diese 6 Zahlen zuvor zutreffend vorhergesagt haben, dann gewinnen Sie. Somit stellt sich die Frage, wie viele „Ihrer“ Zahlen richtig sein werden.

Beispiel 3.4 (Lotto-Spiel) Die Zufallsvariable X bezeichnet die Anzahl der Zahlen, die Sie zutreffend auf Ihrem Spielzettel angekreuzt haben. Die möglichen Werte von X lauten daher 0, 1, 2, 3, 4, 5 oder 6. In der Grundgesamtheit von 49 Zahlen gibt es genau 6 richtige (\(N_e=6\)) und 43 falsche (\(N_m=49-6=43\)). Da im Spiel 6 Zahlen gezogen werden, ist \(n=6\). Damit können wir die Wahrscheinlichkeitsfunktion von X aufstellen:

| \(P(X=k)\) für \(n=6\), \(N_e=6\), \(N_m=43\), \(N=49\) | |

|---|---|

| X=0 | \(\frac{\tbinom{6}{0}\tbinom{(43}{6}}{\tbinom{49}{6}}=0{,}436\) |

| X=1 | \(\frac{\tbinom{6}{1}\tbinom{(43}{5}}{\tbinom{49}{6}}=0{,}413\) |

| X=2 | \(\frac{\tbinom{6}{2}\tbinom{(43}{4}}{\tbinom{49}{6}}=0{,}132\) |

| X=3 | 0,018 |

| X=4 | 0,001 |

| X=5 | 0,00002 |

| X=6 | 0,00000007 |

| Summe | 1 |

Demnach liegt die Wahrscheinlichkeit für genau zwei Richtige im Lotto bei reichlich 13 %. Am größten ist die Wahrscheinlichkeit für gar keinen Richtigen (knapp 44 %).

Aufgabe 3.1 Wie hoch ist die Wahrscheinlichkeit, im Lotto 5 oder 6 Richtige zu haben? Wie groß ist die Wahrscheinlichkeit, weniger als 2 Richtige zu erzielen?

Falls die Stichprobengröße \(n\) im Vergleich zur Anzahl an Erfolgen \(N_e\) und Misserfolgen \(N_m\) in der Grundgesamtheit klein ist, ist \(X\) annähernd binomialverteilt. Als Faustregel nehmen wir an, klein bedeutet, dass wir weniger als 5% von \(N_e+N_m\) ziehen. Als Parameter der Binomialverteilung verwenden wir dann \(n\) (Anzahl der Versuche) und \(p=\tfrac{N_e}{N}\).

Der große Vorteil der Annäherung besteht darin, dass der Rechenaufwand gesenkt wird. Da nun Computer diesen übernehmen können, wird heutzutage meist mit der exakten Verteilung gearbeitet.

Wir haben nun drei diskrete Wahrscheinlichkeitsverteilungen kennengelernt: Binomial-, Poisson- und hypergeometrische Verteilung. Mit den Wahrscheinlichkeitsfunktionen können wir Wahrscheinlichkeiten unmittelbar berechnen. Wir lernen nun stetige Wahrscheinlichkeitsverteilungen kennen, bei denen die Wahrscheinlichkeiten nicht etwa die Funktionswerte der Wahrscheinlichkeitsfunktionen sind, sondern vielmehr Flächen unter sogenannten Dichtefunktionen (siehe hierzu Abb. 3.2).

3.2 Absolutstetige Verteilungen

Während die diskreten Verteilungen nur für abzählbar viele Werte der Zufallsvariable definiert sind, sind die absolutstetigen Verteilungen für überabzählbar viele Werte, z.B. für alle reellen Zahlen, definiert. Ein Beispiel dafür ist die Wertentwicklung eines Aktienportfolios oder die Länge von produzierten Bleistiften.

Formal ausgedrückt heißt dies, dass die Ergebnismenge so umfangreich wie die Menge der reellen Zahlen (also überabzählbar) ist. Für Verteilungen reelwertiger Zufallsvariablen können wir dies wie folgt definieren:

Definition 3.7 (absolutstetige Verteilung) Eine reelweertige Zufallsvariable \(X\) hat eine absolutstetige Verteilung \(P\), genau dann wenn \(P\) eine Dichte besitzt, d.h. es gibt eine Funktion \(f:{\mathbb R}\to [0,\infty)\), so dass für jedes Intervall \([a,b]\subset {\mathbb R}\) die Wahrscheilichkeit dass X im Intervall \([a,b]\) liegt durch das Integral von \(f\) auf \([a,b]\) gegeben ist: \[P(a\leq X \leq b)=\int_a^b f(x) \, dx\]

Während Wahrscheinlichkeiten für diskrete Zufallsvariable durch Aufsummieren bestimmt werden können (beispielsweise für die Augenzahl 1, 2 oder 3 beim Würfelwurf, die Wahrscheinlichkeit: \(1/6 + 1/6 + 1/6 = 3/6 = ½\)), ist dies bei absolutstetigen Zufallsvariablen nicht der Fall. Tatsächlich ist die Wahrscheinlichkeit für einen einzelnen Wert immer Null, da \(\mathbb P(a\leq X\leq a)=\int_a^a f(x)=0\).

Stattdessen ist im stetigen Fall die Wahrscheinlichkeit, dass beispielsweise ein erwachsener Mann zwischen 1,80m und 1,85m groß ist, nicht mehr die Summe einzelner Wahrscheinlichkeiten, sondern vielmehr das Integral der Dichtefunktion, d. h. anschaulich die Fläche darunter zwischen den Intervallgrenzen 1,80m und 1,85m (vgl. Abbildung 3.2).

Während wir also im diskreten Fall mit der Wahrscheinlichkeitsverteilung bzw. -funktion eine unmittelbare Zuordnung vom Ergebnis zur Wahrscheinlichkeit erhalten, heißt die entsprechende Funktion für eine stetige Zufallsvariable „Dichtefunktion“, und die Wahrscheinlichkeiten sind nicht etwa deren Funktionswerte (wie im diskreten Fall), sondern die Flächen unter der Dichtefunktion. Insgesamt ist die Fläche, die die Dichtefunktion mit der Abszissenachse einschließt, die Summe aller Wahrscheinlichkeiten und somit gleich eins:

\[P(\Omega)=∫_{-\infty}^\infty f(x)dx=1.\]![Grafische Darstellung einer Dichtefunktion und der Wahrscheinlichkeit, dass die stetige Zufallsvariable einen Wert im Intervall [a,b] annimmt.](quantitative-methoden_files/figure-html/AbbildungG12-1.png)

Abbildung 3.2: Grafische Darstellung einer Dichtefunktion und der Wahrscheinlichkeit, dass die stetige Zufallsvariable einen Wert im Intervall [a,b] annimmt.

3.2.1 Normalverteilung

Die wichtigste stetige Verteilung ist die Normalverteilung. Sie wurde von Carl Friedrich Gauß (1777-1855) entdeckt und wird deshalb auch als Gauß-Verteilung bezeichnet. Sie hat die charakteristische Glockenform, die Sie aus Abb. 3.2 kennen. Der „Höcker“ in der Mitte ist der Mittelwert der Verteilung, um den sie symmetrisch verläuft. Zufallsvariablen, welche normalverteilt sind, können beliebige reelle Werte annehmen.

Für unsere Zwecke besonders wichtig ist die Erkenntnis, dass wir Wahrscheinlichkeiten jetzt nicht mehr als Funktionswerte (wie in den Tabellen oben) berechnen, sondern das Integral einer Wahrscheinlichkeitsdichte bilden müssen:

Definition 3.8 (Dichtefunktion der Normalverteilung) Eine Zufallsvariable \(X\) folgt einer Normalverteilung mit Mittelwert \(\mu\) (\(\mu \in {\mathbb R}\)) und Varianz \(\sigma^2\) (mit \(\sigma>0\)), in Kurznotation \(X \sim N(\mu,\sigma^2)\) wenn sie folgende Dichte besitzt: \[\varphi_{(\mu,\sigma^2)}(x) := f(x)=\frac{1}{\sigma\sqrt{2\pi}} e^{-\frac{1}{2} \left(\frac{x-\mu}{\sigma}\right)^2}\]

An dieser Funktion erkennen Sie die beiden Parameter der Normalverteilung, die Ihnen aus den Abschnitten 1.1 (Lagemaße) und 1.3 (Streuungsmaße) bekannt vorkommen: \(\mu\) ist der Erwartungswert der Verteilung – die Stelle, an der sich der „Höcker“ der Glockenkurve befindet – und \(\sigma\) ist die Standardabweichung, die ein Maß dafür ist, wie breit die Verteilung streut. Darüber hinaus sind in der Dichtefunktion die beiden Naturkonstanten \(\pi\) (3,1416) und \(e\) (2,7183) enthalten.

Wenn Sie sich Abb. 3.2 anschauen, stellen Sie fest, dass x-Werte nahe dem Mittelwert recht wahrscheinlich sind, weil dort die Dichtefunktion hoch ist; sie schließt im mittleren Bereich eine größere Fläche mit der Abszisse ein als in den äußeren Bereichen der Verteilung. Die äußeren Bereiche heißen „Flanken“ (auf englisch: tails). Bei sehr vielen Phänomenen ist genau dies der Fall: Die typischen Werte treten häufig auf, während extremere Beobachtungen nur selten gemacht werden. Beispielsweise ist die Körpergröße von erwachsenen Menschen normalverteilt: die meisten sind sozusagen mittelgroß, während einige wenige ganz klein und einige wenige riesig sind.

Nun ist es nicht ganz trivial, diese Funktion zu integrieren. Glücklicherweise müssen wir das auch nicht, denn die Flächen sind tabelliert und darüber hinaus sind Funktionen zum Bestimmen der Wahrscheinlichkeiten einer Normalverteilung in praktisch jeder Statistiksoftware zu finden. Allerdings gibt es unendlich viele \((\mu,\sigma)\)-Kombinationen und somit auch unendlich viele Normalverteilungen, aber nur endlich viele Tabellen! Die gebräuchlichste Normalverteilung ist die Standardnormalverteilung: Sie hat den Mittelwert 0 und die Varianz 1. Die Flächen für diese \(N(0,1)\)-Verteilung ist tabelliert und im Anhang in Tabelle 8.1 zu finden.

Wie gelangen wir nun von einer beliebigen Normalverteilung zur Standardnormalverteilung? Das hierzu notwendige Verfahren heißt „Standardisieren“; die standardisierte Zufallsvariable bezeichnen wir mit \(Z\). Wir erzeugen also aus einer beliebig normalverteilten Zufallsvariable \(X\) die standardnormalverteilte Zufallsvariable \(Z\):

\[Z=\frac{X-\mu}{\sigma}\] Diese Werte werden manchmal als Z-Scores bezeichnet. Vielleicht haben Sie den Begriff schon auf Laborergebnissen von ärztlichen Untersuchungen gesehen. Die Z-Scores dort beschreiben in standardisierter Form die Abweichung eines empirischen Messwerts von dem zu erwartenden Mittelwert in der Grundgesamtheit. Genaugenommen handelt es sich dabei allerdings nicht mehr um eine Standardisierung, sondern um eine Studentisierung, bei welcher keine Zufallsvariable, sondern eine empirische Beobachtung entsprechend transformiert wird. Statt Erwartungswert und Standardabweichung kommen dann die empirischen Gegenstücke zum Einsatz.

Beispiel 3.5 (Standardisieren einer Zufallsvariablen) Die Körpergröße von erwachsenen Männern sei normalverteilt mit Mittelwert 174 cm und Standardabweichung 9,6 cm. Wie groß ist die Wahrscheinlichkeit, dass ein zufällig ausgewählter erwachsener Mann größer als 1,80 m ist?

Wir transformieren zunächst: \[Z=\frac{180-174}{9{,}6}=0{,}625 \approx 0{,}63\] Dieses Ergebnis bedeutet, dass die Fläche rechts von 1,80 m in der ursprünglichen Normalverteilung gleich der Fläche rechts von 0,63 in der Standardnormalverteilung ist.

Als Fläche lesen wir aus der Tabelle ab: \(z=0{,}6\) an der vertikalen Achse und \(z=0{,}03\) an der horizontalen Achse ergibt 0,2643, d. h., 26 % der Fläche liegen rechts von 0,63. Gleichermaßen sind 26 % der erwachsenen Männer größer als 1,80 m, und die Wahrscheinlichkeit, dass ein zufällig ausgewählter Mann größer als 1,80 m ist, liegt ebenfalls bei 26 %.

Aufgabe 3.2 (Gewicht von Müslipackungen) Müslipackungen wiegen nominal 750 Gramm, aber das tatsächliche Gewicht schwankt um diesen Wert, da die füllenden Maschinen nicht perfekt abfüllen. Das Gewicht der Packungen folgt einer Normalverteilung mit Mittelwert \(\mu=750\) Gramm und einer Standardabweichung von \(\sigma=5\) Gramm. Welcher Anteil der Packungen wiegt mehr als 760 Gramm? Welcher Anteil der Packungen wiegt weniger als 740 Gramm? Welcher Anteil der Packungen wiegt weniger als 760 Gramm? Welcher Anteil der Packungen wiegt zwischen 740 und 760 Gramm?

Bei den diskreten Zufallsvariablen haben wir kennengelernt, dass man Verteilungen durch andere, einfacher handhabbare approximieren kann. Dies ist auch mit stetigen Zufallsvariablen möglich: Die Binomialverteilung nähert sich mit steigender Anzahl der Versuche (und mit einer Erfolgswahrscheinlichkeit von möglichst nahe 0,5) der Normalverteilung an, so dass Sie die Binomial- durch die Normalverteilung approximieren können. In diesem Fall müssen Sie zunächst, ausgehend von der Binomialverteilung, die Parameter für die „synthetische“ Normalverteilung berechnen:

\(\mu=n\cdot p\)

\(\sigma^2=n\cdot p\cdot (1-p)\)

Beispiel 3.6 (Approximation der Binomialverteilung durch die Normalverteilung)

3.2.2 Lognormalverteilung

Wenn Y eine normalverteilte Zufallsvariable mit positiven Werten ist und wir nun auf Y die Exponentialfunktion anwenden, also \(X = \exp(Y)\), dann folgt diese neue Zufallsvariable \(X\) einer Lognormalverteilung. Umgekehrt gilt, dass der Logarithmus einer lognormalverteilten Zufallsvariable eine normalverteilte Zufallsvariable ergibt:

\[Y=\log(X) \sim N(\mu,\sigma^2)\]

Die Dichtefunktion der Lognormalverteilung für positive x lautet:

\[f(x)=\frac 1 {x\sqrt{2\pi \sigma^2}} e^{\frac{-(\log(x)-\mu)^2}{2\sigma^2}}\] Die Lognormalverteilung übernimmt ihre Parameter von der Normalverteilung, also \(\mu\) und \(\sigma^2\). Zu beachten ist, dass diese Parameter Erwartungswert und Varianz von der logarithmierten, also normalverteilten Zufallsvariable Y sind, nicht jedoch von der lognormalverteilten Zufallsvariable X. Die lognormalverteilte Zufallsvariable X hat dagegen den Erwartungswert \(E(X)=e^{\mu+\sigma^2⁄2}\) und die Varianz \(Var(X)=e^{2\mu+\sigma^2} (e^{\sigma^2}-1)\).

Im Gegensatz zur Normalverteilung kann die Lognormalverteilung sehr schief sein: Die klassische Anwendung für die Lognormalverteilung ist ein Szenario mit vielen recht kleinen Werten und wenigen sehr großen, also beispielsweise die Vermögensverteilung, die wir zu Beginn der Veranstaltung besprochen haben.

Da die Dichte der Lognormalverteilung nur für \(x>0\) positiv ist, kann sie – im Gegensatz zur Normalverteilung – direkt für die Modellierung von Schadenhöhen verwendet werden. Sie wird dazu vor allem im Nicht-Leben-Bereich angewandt: Es treten Kleinere Schäden vergleichsweise häufig auf, während es nur einige wenige große Schäden gibt.

Auch zur Modellierung von Aktienkursen und in der Optionsbewertung findet die Lognormalverteilung Anwendung: Hier sind kleine Kursschwankungen wahrscheinlicher als sehr große.

3.2.3 Exponentialverteilung, Gammaverteilung

Mit der Exponentialverteilung wird die Zeitdauer zwischen zwei aufeinanderfolgenden, seltenen Ereignissen modelliert, beispielsweise die Zeit, die zwischen zwei Erdbeben einer bestimmten Stärke vergeht. Insbesondere für Versicherer ist es interessant, die Zeit zwischen zwei seltenen Ereignissen zu modellieren (Tsunamis, Erdbeben, Stürme usw.). Auch die Lebensdauer von Maschinen, die Zeitdauer zwischen Unfällen, Zeitspannen im Zusammenhang mit radioaktivem Zerfall usw. sind exponentialverteilt.

Sicher kommt Ihnen die Formulierung „seltene Ereignisse“ bekannt vor: Die Anzahl dieser seltenen Ereignisse ist poissonverteilt, während die Zeit zwischen den Ereignissen einer Exponentialverteilung folgt. Zur Einprägung erinnern Sie sich: Die Anzahl der Ereignisse ist offenkundig ein diskretes Merkmal und deshalb muss sie auch einer diskreten Verteilung folgen, und zwar der Poissonverteilung. Im Gegensatz dazu ist die Zeitdauer ein stetiges Merkmal, das durch eine stetige Verteilung abgebildet wird.

Nicht nur die Zeitdauer zwischen zwei aufeinanderfolgenden seltenen Ereignissen wird mit der Exponentialverteilung modelliert, sondern auch die Zeitdauer von beispielsweise Telefonanrufen in einem Call Center.

Die Exponential-, Binomial- und Poissonverteilung hängen eng miteinander zusammen. In Beispiel 3.2 haben wir die Binomialverteilung durch die Poissonverteilung approximiert. Diese Poissonapproximation verdeutlicht uns, unter welchen Umständen eine Zufallsvariable einer Exponentialverteilung folgt:

Die Poissonverteilung beschreibt die Anzahl von Ereignissen in einem festen Zeitintervall in einem sogenannten Poissonprozess, also z. B.: Wie viele Bankkunden treffen in einem kurzen Zeitintervall am Bankschalter ein? Wählen wir den Zeitabschnitt sehr klein, so gibt es entweder einen Erfolg (Bankkunde kommt an) oder einen Misserfolg (Bankkunde geht zur Nachbarbank). Die einzelnen Ereignisse, ob ein Kunde ankommt oder nicht, werden als unabhängig (vom vorhergehenden Kunden) angenommen – eine Bedingung, die in der Praxis meist nur annähernd erfüllt ist. Die Erfolgswahrscheinlichkeit \(\pi\) ist über die einzelnen „Versuche“ konstant. Die Anzahl der Erfolge ist dann binomialverteilt. Falls nun \(\pi\) klein und die Anzahl der Versuche \(n\) groß ist, nähert sich die Verteilung der Zufallsvariable einer Poissonverteilung an. Es lässt sich dann mathematisch zeigen, dass der Zeitabstand zwischen zwei seltenen Ereignissen eine stetige Zufallsvariable ist, die einer Exponentialverteilung folgt.

Die Dichtefunktion der Exponentialverteilung lautet: \[f(x)=\lambda e^{-\lambda x}\] Die Verteilung hat somit einen Parameter \(\lambda\) (wie bei der Poissonverteilung), allerdings ist der Erwartungswert hier \(1/\lambda\). Dies ist der Wert, auf den sich langfristig die Zeitspanne zwischen zwei aufeinanderfolgenden seltenen Ereignissen einpendeln wird.

Beispiel 3.7 (Wartezeiten von Erdbeben) Die Zeitspanne zwischen zwei aufeinanderfolgenden Erdbeben der Stärke 7.0 oder stärker folgt einer Exponentialverteilung. Der Erwartungswert beträgt 25 Tage. Wie groß ist die Wahrscheinlichkeit, dass zwischen zwei starken Erdbeben weniger als drei Tage vergehen?

Der Erwartungswert beträgt 25 Tage und wir wissen, dass dieser zugleich \(1/\lambda\) ist. Deshalb ist \(\lambda = 1/25 = 0,04\). Wir suchen \(P(X<3)\); da es eine stetige Verteilung ist, muss \(P(X≤3)\) genauso groß sein. Um die Wahrscheinlichkeit zu berechnen, könnten Sie entweder die Dichtefunktion von 0 bis 3 integrieren oder den Wert 3 in die Verteilungsfunktion einsetzen, wenn Sie diese hätten. Das Ergebnis lautet 0,113; mit einer Wahrscheinlichkeit von 11 % vergehen zwischen zwei starken Erdbeben weniger als drei Tage.

Die Exponentialverteilung ist ein Spezialfall der Gammaverteilung (\(\Gamma\)-Verteilung), deren Dichtefunktion

\[f(x)=\frac{\lambda^k}{\Gamma(k)} x^{k-1} e^{-\lambda x}, \text{ wobei }k, \lambda, x>0,\]

lautet.

Dies ist eine stetige Verteilung mit zwei Parametern k und \(\lambda\). k ist ein Formparameter, da er über die Form der Verteilung entscheidet. \(\lambda\) ist ein Skalenparameter, der beeinflusst, wie stark die Funktion entlang der Abszissenachse gestreckt oder gestaucht wird. Die Gammafunktion ist \(\Gamma(x)=\int_0^\infty t^{x-1} e^{-t} \, dt\). Der Faktor \(\lambda^k⁄\Gamma(k)\) stellt sicher, dass der Flächeninhalt unter der Gammaverteilung insgesamt gerade gleich 1 ist.

Für \(k=1\) ist die Gammaverteilung eine Exponentialverteilung.

Die Gammaverteilung wird zur Modellierung kleiner bis mittlerer Schäden verwendet (z.B. Gewerbe-, Hausrat-, Kfz-Kasko und -haftpflichtversicherung).

3.2.4 Überblick über Extremwertverteilungen

Besonders hohe finanzielle Verluste (bei Banken) oder außergewöhnlich hohe Versicherungsschäden, die einen gegebenen Schwellenwert überschreiten, werden mit Extremwertverteilungen modelliert.

(Die Ausführungen in diesem Abschnitt sind teilweise wörtlich aus Cottin and Döhler 2013 entnommen.)

Extremwertverteilungen sind stetige Verteilungen und erfassen die Verteilung von Extremwerten, d. h., sie beantworten beispielsweise die Frage, ob die Maxima einer Verteilung folgen.

Weibull-Verteilung

Die Dichtefunktion der Weibullverteilung lautet \(f(x)=k\lambda x^{k-1} e^{-\lambda x^k}\). Während der Parameter \(k\) die Form der Verteilung bestimmt, ist \(\lambda\) der Skalenparameter (wie bei der Gammaverteilung), \(k\), \(λ\), \(x>0\).

Für den Spezialfall \(k=1\) ergibt sich, wie bei der Gammaverteilung, eine Exponentialverteilung.

Für \(k<1\) wird die Weibullverteilung zur Modellierung von Großschäden, beispielsweise im Industriebereich, in der Kfz-Haftpflicht und in der Rückversicherung verwendet. Für \(k>1\) wird die Weibullverteilung zur Modellierung von Kleinschäden eingesetzt; die Dichtefunktion ähnelt dann der der Gammaverteilung.

Pareto-Verteilung

Die Pareto-Verteilung liefert nur für \(x≥x_0\) positive Werte, und zwar nach der Dichtefunktion \(f(x)=ax_0^a x^{-a-1}\). Die Wahrscheinlichkeit für extrem hohe Schadensummen konvergiert bei der Pareto-Verteilung langsamer gegen Null als beispielsweise bei der Exponentialverteilung. Deshalb wird die Pareto-Verteilung zur Modellierung von Großschäden eingesetzt, vor allem in der Industrie-Feuerversicherung und in der Rückversicherung. Die breite Flanke der Pareto-Verteilung charakterisiert sie als sogenannte Heavy-Tail-Verteilung, d.h. ihre Dichte fällt langsamer als exponentiell, sodass auf deren Verteilungsenden relativ viel Masse liegt (verglichen mit z. B. einer Exponentialverteilung oder Normalverteilung).

Für \(x_0=1\) ergibt sich eine Log-Gamma-Verteilung mit zwei Parametern \(k=1\) und \(\lambda=a\), die wir hier nicht weiter betrachten, auch wenn sie zur Modellierung von Großschäden oberhalb eines gegebenen Schwellenwertes angewendet wird.

Wenn eine gegebene Pareto-Verteilung um \(x_0\) nach links verschoben wird, erhält man eine Nullpunkt-Pareto-Verteilung: \(X \sim \operatorname{Null-Pareto}(x_0,a)\), die für alle \(x≥0\) positive Werte annimmt. Falls X einer Nullpunkt-Pareto-Verteilung mit den Parametern \((x_0,a)\) folgt, dann ist X zugleich verallgemeinert Pareto-verteilt mit den Parametern \((\zeta,\beta)\), wobei \(a=1⁄\zeta\) und \(x_0=\beta⁄\zeta\) und \(\zeta>0\).

Die verallgemeinerte Pareto-Verteilung heißt auf Englisch „Generalised Pareto Distribution“, kurz GPD, so dass \(X\sim GPD(\zeta,\beta)\). Dabei ist \(\beta\) ein Skalenparameter und \(\zeta\) ein Formparameter. Die Dichte- und Verteilungsfunktion nehmen erst für positive x-Werte positive Werte an. Die GPD wird zur Modellierung von Versicherungsschäden oder Kursverlusten über einem gegebenen Schwellenwert angewendet.

Verallgemeinerte Extremwertverteilung

Abschließend stellen wir die verallgemeinerte Extremwertverteilung vor, aus der als Sonderfälle Fréchet-, Gumbel- und negative Weibull-Verteilung entstehen. Die Generalised-Extreme-Value-(GEV)-Verteilung hat drei Parameter: \(X \sim GEV(\zeta,\mu,\sigma)\), wobei \(\zeta\) eine beliebige reelle Zahl ist und \(\mu\) der Lage- und \(\sigma\) der Skalenparameter (\(\sigma>0\)). Je nach Wahl von \(\zeta\) ergibt sich einer der folgenden Spezialfälle:

- \(\zeta>0\): Fréchet-Verteilung

- \(\zeta=0\): Gumbel-Verteilung

- \(\zeta<0\): Negative Weibull-Verteilung (verschobene und gespiegelte Weibull-Verteilung)

Während die Fréchet-Verteilung nach unten beschränkt ist (also die Werte der Dichtefunktion gleich Null sind für x-Werte unterhalb einer bestimmten Schwelle), ist die negative Weibull-Verteilung nach oben beschränkt (also Werte der Dichtefunktion gleich Null für x-Werte oberhalb einer bestimmten Schwelle). Nimmt man die extremen Schäden als hohe positive Werte an, so lassen sich diese mit der negativen Weibull-Verteilung nicht abbilden. Deshalb werden Ihnen im Risikomanagement vor allem die Fréchet- und die Gumbel-Verteilung begegnen.

Die folgende Tabelle fasst die wesentlichen Dichtefunktionen zusammen:

| Dichtefunktion | |

|---|---|

| Fréchet | \(f(x)=\frac{\alpha}{x^{\alpha+1}} \exp(-x^{-\alpha}); \quad \alpha,x>0\) |

| Weibull | \(f(x)=k \lambda x^{k-1} e^{-\lambda x^k}\) |

| Gumbel | \(f(x)=e^{-x} \exp(-e^{-x}), µ=0,σ=1\) |

| Pareto | \(f(x)=ax_0^a x^{-a-1}\) |

Während beispielsweise die Schadenanzahl Poisson-verteilt ist, folgt die Schadenhöhe einer Pareto-Verteilung. Die Fréchet- und Weibull-Verteilungen werden ebenfalls vor allem für Schadenhöhen von Naturgefahren angewendet (beispielsweise Sturm und Hagel, Hochwasser). Die Pareto-Verteilung ist in der Tarifierung von Rückversicherungen unerlässlich.

Am Rande sei angemerkt, dass Sie Zufallsvariablen transformieren können. Wenn Sie beispielsweise eine Zufallsvariable betrachten, die einer Normalverteilung folgt und Sie diese Zufallsvariable logarithmieren, dann folgt die transformierte Zufallsvariable einer Lognormalverteilung. Ebenso lassen sich Fréchet-, Weibull- und Gumbelverteilungen durch Transformation von Zufallsvariablen ineinander überführen. Wir werden dies hier nicht vertiefen.

Es gibt eine außerordentlich große Anzahl an Verteilungen, die wir hier bei weitem nicht alle ansprechen können. Das Ziel der Veranstaltung besteht vielmehr darin, Sie mit den grundsätzlichen Konzepten von Verteilungen, dem Standardisieren von Zufallsvariablen und dem Approximieren von Verteilungen vertraut zu machen, damit Sie diese Konzepte auf ganz unterschiedliche Verteilungen auch – und vor allem! - außerhalb der Vorlesung selbstständig anwenden können.

3.3 Verteilungsfunktionen

Wir kommen nun zurück auf den Abschnitt 1.5, in dem wir die empirische Verteilungsfunktion kennengelernt haben. Dafür werden die Wahrscheinlichkeiten, die bis zu einem bestimmten Wert „aufgelaufen“ sind, aufsummiert. Im stetigen Fall erfolgt das „Aufsummieren“ über das Integral, d. h., die Verteilungsfunktion ist die integrierte Dichtefunktion und Sie erhalten die Dichtefunktion aus der Verteilungsfunktion durch Ableiten. Nachdem wir mit mehreren Dichtefunktionen vertraut sind, können wir unsere Betrachtungen formalisieren.

Formal definieren wir die Verteilungsfunktion:

\[F(x)=P(X≤x)\]

Definition 3.9 (Verteilungsfunktion) \(X\) sei eine Zufallsvariable über \((\Omega,\mathcal{A},\mathbb P)\), d.h. \(X: (\Omega,\mathcal A)\to ({\mathbb R},\mathbb{B})\). Definiere \(F:{\mathbb R}\to [0,1]\) durch \[F(x):= P({X\leq x}) \\ = P(\{\omega \in \Omega: X(\omega)\leq x\}) ,\quad x\in {\mathbb R}\] \(F\) heißt dann Verteilungsfunktion von \(X\).

Die Verteilungsfunktion beginnt daher (nahezu, asymptotisch) bei Null und endet in einer Asymptote, die sich der 1 annähert (siehe Abb. 1.4). Die Verteilungsfunktion steigt stetig an (d. h. ist schwach monoton wachsend); fallen kann sie nicht, da die Wahrscheinlichkeiten, die „im Hintergrund“ aufsummiert werden, mindestens Null sind.

Verteilungsfunktionen sind nützlich, um Wahrscheinlichkeiten zu berechnen. Stellen Sie sich in Abb. 3.2 vor, Sie wollten die Wahrscheinlichkeit dafür berechnen, dass die Zufallsvariable einen Wert zwischen a und b annimmt: \(P(a≤X≤b)\). Diese Wahrscheinlichkeit ist gleich der Differenz der Verteilungsfunktionswerte: \(P(a≤X≤b)=F(b)-F(a)\).

Wichtige Dichte- und Verteilungsfunktionen haben manchmal eigene, in der Literatur gebräuchliche Namen: So wird die Dichtefunktion der Standardnormalverteilung üblicherweise als \(\varphi (x)\) bezeichnet und die zugehörige Verteilungsfunktion als \(\Phi (x)\).

Sie können nun sowohl im diskreten als auch im stetigen Fall Wahrscheinlichkeiten berechnen – sowohl über die Wahrscheinlichkeits- und Dichtefunktionen als auch über die Verteilungsfunktion.

3.4 Erwartungswert, Varianz und Kovarianz

Die drei Kennzahlen Erwartungswert, Varianz und Kovarianz kennen Sie bereits aus dem Kapitel zur deskriptiven Statistik. Durch unsere Kenntnisse zu Wahrscheinlichkeits- und Dichtefunktionen können wir nun unser Wissen formalisieren. Dies geschieht analog zum Abschnitt 3.3 über Verteilungsfunktionen, die Sie ebenfalls bereits vorher kannten.

Der Erwartungswert ist eine Art theoretischer Mittelwert und wird mit \(E(X)\) bezeichnet. Dabei ist X die Zufallsvariable, während x deren Realisation (also ein konkreter Wert) ist. In der deskriptiven Statistik haben wir den Mittelwert berechnet, indem wir die relativen Häufigkeiten mit der Merkmalsausprägung multipliziert haben. Da wir nun die Wahrscheinlichkeiten aus der Wahrscheinlichkeits- bzw. Dichtefunktion kennen, ersetzen wir die relativen Häufigkeiten durch diese Wahrscheinlichkeiten und ermitteln so den Erwartungswert. Die mathematische Varianz ist die erwartete quadratische Abweichung vom Erwartungswert.

Manchmal wird gesagt, der Erwartungswert sei der Wert, den der Statistiker im Mittel erwartet. Diese Aussage wird dann leicht missverstanden: Ein Statistiker erwartet natürlich nicht, dass beim Würfelwert der Erwartungswert (die Augenzahl 3,5) geworfen wird, sondern eher, dass das arithmetische Mittel bei zunehmend großer Versuchszahl mit höherer Wahrscheinlichkeit nahe am Erwartungswert liegen wird.

| Erwartungswert | Varianz | Kovarianz | ||

|---|---|---|---|---|

| diskrete Zufallsvariable | \(E(X)=∑ x_i p_i\) | \(Var(X)=E(X-E(X))^2\) | \(Cov(X,Y)=E(X-E(X)) \cdot (Y-E(Y))\) | |

| stetige Zufallsvariable | \(E(x)=∫x f(x) \, dx\) | |||

Mit diesen Erkenntnissen lassen sich einige wesentliche Eigenschaften für Erwartungswert, Varianz und Kovarianz herausarbeiten, wobei \(X\), \(Y\) Zufallsvariablen und a, b, c, d konstante reelle Werte sind:

\(E(aX+bY)=aE(X)+bE(Y)\) (Linearität des Erwartungswert-Operator)

\(Var(aX)=a^2 Var(X)\)

Falls \(X≤Y\), dann gilt auch \(E(X)≤E(Y)\) (Monotonie)

\(Var(X)=Cov(X,X)=EX^2-(E(X))^2\)

\(Var(X+c)=Var(X)\) (Invarianz bzgl. des Lageparameters: eine konstante \(c\) Verschiebung fügt keine Streuung hinzu)

\(Var(X+Y)=Var(X)+Var(Y)+2\cdot Cov(X,Y)\) (wird angewandt in der Portfoliotheorie; siehe Beispiel 1.9)

\(Cov(aX+b,cY+d)=ac\cdot Cov(X,Y)\)

\(Cov(X,Y)=E(X\cdot Y)-E(X)\cdot E(Y)\)

Der Erwartungswert ist das erste Moment einer Verteilung, die Varianz das zweite. Wir kommen darauf zurück, wenn wir mit der Methode der Momente schätzen (Abschnitt 6.1).

Ganz sicher erinnern Sie sich an unsere Ausführungen zur Unabhängigkeit. Falls zwei Zufallsvariablen X und Y unabhängig sind, dann gilt \(Cov(X,Y)=0\). Umgekehrt gilt dieser Schluss im Allgemeinen nicht, weil mit der Kovarianz ausschließlich lineare Abhängigkeiten erfasst werden.

Wir können nun Erwartungswert und Varianz für die Verteilungen zusammenfassen, die wir in den Abschnitten 3.1 und 3.2 kennengelernt haben.

| Diskrete Verteilung | E(X) | Var(X) |

|---|---|---|

| Binomialverteilung | \(n\cdot p\) | \(n\cdot p\cdot (1-p)\) |

| Poissonverteilung | \(\lambda\) | \(\lambda\) |

| Hypergeometrische Verteilung | \(n \frac{N_e}{N}\) | \(n \frac{N_e}{N}(1-\frac{N_e}{N})\frac{N-n}{N-1}\) |

| Stetige Verteilung | E(X) | Var(X) |

|---|---|---|

| Normalverteilung | \(\mu\) | \(\sigma^2\) |

| Lognormalverteilung | \(e^{\mu+\frac{\sigma^2}{2}}\) | \(e^{2\mu+\sigma^2} (e^{\sigma^2}-1)\) |

| Exponentialverteilung | \(\frac{1}{\lambda}\) | \(\frac{1}{\lambda^2}\) |

3.5 Die zweidimensionale Verteilung

Die bisher betrachteten Wahrscheinlichkeits- und Dichtefunktionen beschreiben einzelne Merkmale, beispielsweise die Anzahl der Tore in einem Fußballspiel oder die Körpergröße von erwachsenen Männern. Wenn nur ein Merkmal erfasst wird, können von dieser eindimensionalen Verteilung keine Aussagen über einen möglichen Zusammenhang dieser Zufallsvariable mit einer anderen gemacht werden. Oftmals interessiert aber gerade dieser Zusammenhang. Deshalb betrachten wir in diesem Abschnitt eine Dichtefunktion (die Normalverteilung), die zwei Zufallsvariablen gleichzeitig beschreiben kann.

Wenn die beiden untersuchten Merkmale miteinander zusammenhängen und die Beziehung stochastisch ist, besitzen die beiden Zufallsvariablen auch eine gemeinsame Verteilung. Für die Interpretation ist es dann von Bedeutung, ob man bei Kenntnis der Merkmalsausprägung der ersten Variable die zweite Variable vorhersagen kann. Möglicherweise kann man auch den Wert der zweiten Variable steuern, indem man den Wert steuert, den die erste Variable annimmt (und umgekehrt). Beispielsweise wissen wir, dass der Umsatz steigt, wenn die Werbeausgaben steigen. Aber in welchem Ausmaß steigt der Umsatz, wenn die Werbeausgaben um 10 % steigen?

Es ist denkbar, dass zwei gemeinsam verteilte Zufallsvariablen (X,Y) beide diskret, beide stetig oder eine diskret und eine stetig sind. Wir behandeln hier ausschließlich den Fall, dass beide Variablen stetig und gemeinsam normalverteilt sind.

Die Werte der Dichtefunktion hängen nun nicht mehr nur von einer Variable X ab, sondern zugleich von X und Y: \(f(x,y)\). Die Funktionswerte sind genauso wie im eindimensionalen Fall nichtnegativ \(f(x,y)≥0\), und das Integral der Dichtefunktion über alle x und y ist gleich 1:

\[∫_x ∫_y f(x,y) \, dy \, dx=1\]

Grafisch dargestellt ist die Dichtefunktion nun ein Gebirge über einer Fläche, die von x und y aufgespannt wird.

Wahrscheinlichkeiten sind jetzt nicht mehr Flächen unter der Dichtefunktion, sondern Volumen-Ausschnitte aus dem Gebirge, die über ein Doppelintegral berechnet werden:

\[P(a<X<b,c<Y<d)=∫_c^d ∫_a^b f(x,y) \, dx\, dy\]

Falls eine gemeinsame Dichtefunktion gegeben ist, aber Fragen zu einer Zufallsvariable betrachtet werden sollen, muss die Randdichtefunktion herangezogen werden. Die Randdichte von X erhalten wir durch Integration der gemeinsamen Dichte über alle Y (und umgekehrt):

\[f_1 (x)=∫_{-∞}^∞ f(x,y) \, dy\]

Wenn wir das Gebirge der gemeinsamen Dichtefunktion an einer Stelle x durchschneiden, dann hat die Schnittfläche den Flächeninhalt des Funktionswertes der Randdichte von X an der Stelle x (und analog für Y).

Aus dieser Randdichte für X können der Erwartungswert von X (\(EX\)), \(EX^2\) und daraus die Varianz von \(X\) berechnet werden:

\[EX=∫_{-∞}^∞ xf_1 (x) \, dx\]

\[EX^2=∫_{-∞}^∞ x^2 f_1 (x) \, dx\]

\[Var(X)=EX^2-(EX)^2\]

Ebenso kann aus der zweidimensionalen Dichtefunktion die gemeinsame Verteilungsfunktion ermittelt werden, indem integriert wird:

\[F(s,t)=P(X≤s,Y≤t)=∫_{-∞}^s ∫_{-∞}^t f(x,y) \, dy \, dx\]

Abschließend seien die bedingten Dichtefunktionen erwähnt. Die bedingte Dichte von Y, gegeben X, ist

\[f_{(2|1)}(y│x)=\frac{f(x,y)}{f_1 (x)} \text{ für }f_1 (x)≠0\]

und analog für die bedingte Dichte von X, gegeben Y. Diese bedingten Dichten geben Auskunft über das Verhalten der einen Variable (Y) für einen festen, gegebenen Wert von X. Grafisch schneiden wir zunächst das Gebirge in der Fläche X durch. Diese Schnittfläche ist ihrer Form nach die bedingte Dichtefunktion, aber die Fläche unter ihr ist meistens nicht gleich eins. Deshalb muss diese noch normiert werden, indem wir durch den Flächeninhalt der Schnittfläche dividieren. Dieser Flächeninhalt ist gerade gleich die Randdichte von X an der Stelle, an der das Gebirge geschnitten wird.

Betrachten wir eine zweidimensionale Normalverteilung. Hierfür spannen die x- und die y-Achse eine Ebene auf, auf der das Gebirge entsteht. Die gemeinsame Dichtefunktion wird dann entlang der senkrechten Achse abgetragen. Nehmen wir nun an, wir schneiden das Gebirge entlang der y-Achse bei \(x=2\) durch. Die dabei entstehende Schnittfläche wird durch die gemeinsame Dichtefunktion \(f(x=2,y)\) begrenzt. Der Flächeninhalt der Schnittfläche ist nicht gleich 1, sondern muss noch skaliert werden, indem die gemeinsame Dichtefunktion durch die Randdichte an der Stelle \(x=2\) dividiert wird:

\[f_{2|1} (y│x=2)=\frac{f(x,y)}{f_1 (x)}=\frac{f(x=2,y)}{f_1 (x=2)}\]

Somit entsteht die bedingte Dichtefunktion von \(y\) gegeben \(x=2\). Der Flächeninhalt der Schnittfläche vor dem Skalieren entspricht dem Funktionswert der Randdichte von X an der Stelle \(x=2\): \(f_1(x=2)\).

Die Berechnung von den hier besprochenen zweidimensionalen Dichten, Randdichten und bedingten Dichten erfordert Computerprogramme und wird deshalb innerhalb dieses Moduls nicht geübt. Aus diesem Grund verzichten wir hier auf Rechenbeispiele. Im Folgenden wird allein zur Veranschaulichung ein Beispiel rein verbal präsentiert (entnommen aus Zucchini et al. (2009)).

Beispiel 3.8 Betrachtet werden zwei Zufallsvariablen: der wirtschaftliche Wert eines Baumes (Wert des Holzes) und die Höhe des Baumes. Es ist unmittelbar einsichtig, dass beide Variablen miteinander zusammenhängen. Es ist ferner vorstellbar, dass die meisten Bäume eine mittlere Höhe haben, während es einige wenige ganz kleine und einige wenige sehr große Bäume gibt. Das Volumen des Holzes ist in etwa eine kubische Funktion seiner Höhe.

| Mit welcher Wahrscheinlichkeit hat ein zufällig ausgewählter Baum eine Höhe zwischen \(x_1\) und \(x_2\) Metern und einen Wert zwischen \(y_1\) und \(y_2\) Euro? | gemeinsame Dichtefunktion wird integriert von \(x_1\) bis \(x_2\) und \(y_1\) bis \(y_2\) |

| Mit welcher Wahrscheinlichkeit hat ein Baum eine Höhe zwischen \(x_1\) und \(x_2\) Metern? | Randdichte von \(X\) wird von \(x_1\) bis \(x_2\) integriert |

| Mit welcher Wahrscheinlichkeit hat ein Baum einen Holzwert zwischen \(y_1\) und \(y_2\) Euro? | Randdichte von \(Y\) wird von \(y_1\) bis \(y_2\) integriert |

| Mit welcher Wahrscheinlichkeit hat ein Baum einen Holzwert zwischen \(y_1\) und \(y_2\) Euro, wenn die Höhe der Bäume \(x\) beträgt? | Bedingte Dichte von \(Y\), gegeben \(X=x\), wird von \(y_1\) bis \(y_2\) integriert |

| Wenn die Bäume einen Holzwert von \(Y=y\) haben sollen, wie wahrscheinlich ist es dann, dass sie eine Höhe zwischen \(x_1\) und \(x_2\) Metern haben? | Bedingte Dichte von \(X\), gegeben \(Y=y\), wird von \(x_1\) bis \(x_2\) integriert |

Wir haben nun zweidimensionale Verteilungen, ihre gemeinsamen Dichtefunktionen, Verteilungsfunktionen sowie die Rand- und bedingten Dichten im Überblick kennengelernt. Mit diesen Betrachtungen schließen wir die Verteilungen ab. Im folgenden Kapitel wenden wir die Normalverteilung an (Zentraler Grenzwertsatz). Wegen der herausragenden praktischen Bedeutung der Normalverteilung sollten Sie daher den Abschnitt 3.2.1 noch einmal wiederholen, bevor Sie mit Kapitel 4 fortfahren.

Schlüsselbegriffe:

Zufallsvariable versus deterministische Variable; Diskrete und stetige Zufallsvariable; Binomial-, Poisson-, hypergeometrische Verteilung; Normal-, Lognormal-, Exponentialverteilung; Verteilungsfunktion; Erwartungswert, Varianz und Kovarianz; Darstellung von zweidimensionalen Zufallsvariablen

Literatur: