5 Modelos con Variables Cualitativas

5.1 Introducción

En un modelo econométrico, las variables representan a los conceptos u operaciones económicas que queremos analizar. Normalmente utilizamos variables cuantitativas, es decir, aquellas cuyos valores vienen expresados de forma numérica; sin embargo, también existe la posibilidad de incluir en el modelo econométrico información cualitativa, siempre que esta pueda expresarse de esa forma.

Las variables cualitativas expresan cualidades o atributos de los agentes o individuos (sexo, religión, nacionalidad, nivel de estudios, etc.) y también recogen acontecimientos extraordinarios como guerras, terremotos, climatologías adversas, huelgas, cambios políticos, etc.

No cabe duda de que una forma de recoger factores de este tipo sería la utilización de variables proxy o aproximadas a las variables utilizadas. Por ejemplo, si quiero utilizar una variable que mida el nivel cultural de un país (variable cualitativa) puedo utilizar como variable proxy el número de bibliotecas existentes en un país, o representar una climatología adversa a partir de las temperaturas medias o precipitaciones. Sin embargo, no siempre es posible encontrar este tipo de variables y, en cualquier caso, debemos de ser conscientes de la posible existencia de errores en la definición de la variable.

Puesto que las variables cualitativas normalmente recogen aspectos de la presencia o no de determinado atributo (ser hombre o mujer, tener estudios universitarios o no tenerlos, etc.…) se utilizan variables construidas artificialmente, llamadas también ficticias o dummy, que generalmente toman dos valores, 1 ó 0, según se dé o no cierta cualidad o atributo. Habitualmente a la variable ficticia se le asigna el valor 1 en presencia de la cualidad y 0 en caso contrario. Las variables que toman valores 1 y 0, también reciben el nombre de variables dicotómicas o binarias.

Las variables dicotómicas pueden combinarse para caracterizar variables definidas por su pertenencia o no a un grupo. Si incluyo una variable cualitativa que me define la pertenencia o no de un país a un grupo, por ejemplo renta alta, media y baja, introduciré tres variables cualitativas en el modelo asociadas a la pertenencia o no a cada grupo; la primera caracterizaría a los individuos con renta alta, la segunda a los individuos con renta media, y la tercera a los individuos con renta baja.

Los modelos que utilizan variables cualitativas como regresores se diferencian en dos grupos, los modelos de Análisis de la Varianza o modelos ANOVA, que únicamente incluyen variables cualitativas como regresores; y los modelos de Análisis de la Covarianza o modelos ANCOVA que incluyen tanto variables cualitativas como cuantitativas. Los modelos ANOVA son muy utilizados en Sociología, Psicología, Educación, etc.; en Economía son más comunes los modelos ANCOVA.

5.2 Modelos ANOVA: efectos fijos

Un problema estadístico clásico es la comparación de medias de dos distribuciones normales. Supongamos que las observaciones de la variable \(Y_i\) provienen de dos distribuciones normales con medias \(\mu_1\) y \(\mu_2\) y varianza común \(\sigma^2\). El tamaño de la primera distribución se circunscribe a las \(n_1\) primeras observaciones, y el de la segunda a las \(n-n_1\) restantes. Queremos constrastar la hipótesis \(H_0:\mu_1=\mu_2\) frente a la alternativa \(H_1:\mu_1 \neq \mu_2\) al nivel de significación de \(\alpha\).

Este contraste de igualdad de medias cabe formularlo en el marco del modelo lineal general. Así, bajo \(H_0\) tenemos el siguiente modelo de regresión múltiple utilizando variables Dummy:

\[ Y_i=\mu_1 D_{1i} + \mu_2 D_{2i} + u_i \ \ \ \ (1)\]

donde \(D_{1i}\) toma valor uno en las \(n_1\) primeras observaciones y cero en las restantes, y \(D_{2i}\) toma cero en las \(n_1\) primeras observaciones y uno en las restantes, o lo que es lo mismo \(D_{2i} = 1-D_{1i}\).

Este modelo ANOVA puede formularse tambien a partir de las siguientes expresiones:

\[ Y_i=\beta_0 + \mu_1 D_{1i} + u_i \ \ \ \ (2)\]

\[ Y_i=\beta_0 + \mu_2 D_{2i} + u_i \ \ \ \ (3)\]

El contraste de igualdad de medias, se realiza a través del contraste de significación global, para el que construimos el estadístico experimental \(F_{exp}=\frac {\frac {R^2}{k-1}}{\frac {1-R^2}{n-k}}\), siendo el estadístico teórico \(F_{tco}\). La hipótesis se rechazaría con la regla de decisión \(F_{exp}>F_{tco}\).

Si se utiliza la especificación del modelo (2), el coeficiente asociado a la categoria \(D_1\) vendrá dado por la suma (\(\beta_0+\mu_1\)), y para \(D_2\) por \(\beta_1\). Si queremos contrastar la hipótesis de igualdad de medias en ambos grupos, equivaldría a contrastar la hipótesis nula \(H_0:\mu_1=0\).

Si se utiliza la especificación del modelo (3), el coeficiente asociado a la categoria \(D_2\) vendrá dado por la suma (\(\beta_0+\mu_2\)), y para \(D_1\) por \(\beta_0\). Si queremos analizar la hipótesis de igualdad de medias en ambos grupos, equivaldría a contrastar la hipótesis nula \(H_0:\mu_2=0\)

El análisis de la varianza (ANOVA) se debe al estadístico-genético Sir Ronald Aylmer Fisher (1890-1962), autor del libro “Statistics Methods for Research Workers” publicado en 1925 y pionero de la aplicación de métodos estadísticos en el diseño de experimentos, introduciendo el concepto de aleatorización. Fue creado para resolver diversos problemas agrícolas y tiene por objetivo descomponer la variabilidad de los datos asociados a un experimento en componentes independientes, las cuales, son asignables a distintas causas.

Por tanto, este análisis surge en el ámbito del diseño de experimentos, cuya metodología estudia como realizar comparaciones lo más homogéneas posibles, para aumentar, en consecuencia, la probabilidad de detectar cambios o identificar variables influyentes.

Respecto a la aleatorización, se establece el siguiente principio: todos los factores no controlados por el experimentador y que pueden influir en los resultados se asignan al azar a las observaciones. La aleatorización es fundamental, ya que:

Previene la existencia de sesgos.

Evita la dependencia entre observaciones.

Confirma la validez de los procedimientos estadísticos más comunes.

El problema que vamos a estudiar es, si disponemos de n elementos que se diferencian en un factor, por ejemplo, estudiantes de distintas aulas, vehículos de distinta marca, efectos de distintos medicamentos, productos sometidos a diferentes canales de distribución, fondos de inversión en distintos momentos temporales, etc. En cada elemento estudiado (fondos, productos, personas, vehículos,…) observamos cierta característica, variable respuesta, que varía aleatoriamente de un elemento a otro, como el consumo de combustible, la altura de cada persona, las ventas de un producto, etc. Se desea conocer si hay o no relación entre el valor medio esperado de la característica objeto de estudio y el factor.

Por tanto podemos decir que el análisis de la varianza es un método estadístico para determinar si una variable determinada, llamada dependiente y medida en escala no métrica, toma valores medios iguales o distintos en los grupos que forma otra variable, llamada independiente y en escala métrica. Como ejemplo, partiendo de la base de datos “mtcars”, vamos a analizar si la autonomía de los vehículos, medida en millas por galón de combustible, es la misma según su número de cilindros (4, 6 ó 8).

5.2.1 Análisis de la varianza de un factor

El diseño que hemos planteado se conoce como análisis de la varianza de un factor, puesto que se considera la influencia de una sola variable (número de cilindros). En el siguiente apartado se verá el análisis de la varianza con dos o más factores, donde como ejemplo se considerará la influencia conjunta de dos variables independientes, el número de cilindros (4, 6 ó 8) y el tipo de transmisión (automática [0] o manual [1]).

Planetamiento

El objetivo del análisis de la varianza es contrastar la homogeneidad simultánea de k poblaciones (\(k \geq 2\)) que siguen la ley de probabilidad \(N(\mu_i, \sigma^2)\) para i=1,…,L, con varianza común desconocida. Es necesario suponer que las distribuciones tienen varianza común para plantear el modelo.

La homogeneidad de las poblaciones se contrastará mediante la igualdad simultánea de sus medias \(\mu_i\), es decir, trataremos de contrastar la hipótesis nula:

\[H_0: \mu_1 = \mu_2 = ... = \mu_L = \mu \ \ \ (homogeneidad\ de\ las\ k\ poblaciones)\]

frente a la alternativa

\[H_1: \exists\ \mu_i\neq \mu_j \ \ \ (al\ menos\ existen\ dos\ medias\ que\ son\ diferentes)\]

El objetivo del análisis es comprobar la hipótesis (nula) de que la media es igual en las distintas poblaciones. Si la hipótesis es cierta, entonces las diferencias entre los valores obtenidos y los valores medios son debidas al azar (variabilidad aleatoria) y no a un efecto sistemático.

Se denomina factor a la variable que supuestamente ejerce una influencia sobre la variable dependiente. En nuestro ejemplo, la variable dependiente sería la autonomía de los vehículos, medida en millas por galón, mientras que el factor el número de cilindros.

Los niveles del factor serán cada uno de los valores posibles del factor (4, 6, 8).

El error muestral es el error debido a la aleatoriedad en la selección de los elementos muestrales. Se representa por: \(u_{ij}=y_{ij}-\mu_i\ \forall i,j\)

Un modelo es replicado si el experimento se repite varias veces para cada nivel de factor.

Un modelo de análisis de la varianza se llama equilibrado (balanced) cuando todos los grupos que forma la variable independiente son de igual tamaño, es decir cuando el número de observaciones para cada nivel del factor es siempre el mismo (el experimento se repite para cada nivel del factor el mismo número de veces). En caso de no ser igual, se llama no equilibrado (unbalanced).

Modelo

El planteamiento anteriormente expuesto da lugar a la formulación de un modelo matemático. Dicho modelo es el siguiente:

\[y_{ij} = \mu + \alpha_i + u_{ij}\]

donde \(\mu_i = \mu + \alpha_i\) serán las medias estimadas por el modelo, siendo, por tanto, \(\mu\) la media general, \(\alpha_i\) el efecto del factor en cada nivel y \(\sum\alpha_i=0\).

La estimación de estos parámetros teóricos se realiza del siguiente modo:

\[\hat \mu = \bar y_{..} \ \ \ \ \ \ \ \ \ \ \ \hat \alpha_i = \bar y_{i.} - \bar y_{..} \ \ \ \ \ \ \ \ \ \ \ \hat \mu_i = \hat \mu + \hat \alpha_i = \bar y_{i.} \ \ \ \ \ \ \ \ \ \ \ \hat u_{ij}= e_{ij} = y_{ij} - \bar y_{i.}\]

Siendo \(\bar y_{i.} = \frac {\sum_{j=1}^{n_i}y_{ij}} {n_i}\) la media muestral para cada grupo (en nuestro caso las autonomías medias de los vehículos según tengan 4, 6 ó 8 cilindros), con \(n_i\) el número de observaciones o muestras, y \(\bar y_{..} = \frac {\sum_{i=1}^{L} \sum_{j=1}^{n_i}y_{ij}} {n}\) la media global, o autonomía media del conjunto de vehículos analizados.

El modelo estimado queda por tanto:

\[y_{ij} = \bar y_{..} + (\bar y_{i.} - \bar y_{..}) + (y_{ij} - \bar y_{i.})\]

Tabla ANOVA

Partiendo de la expresión anterior, la variabilidad total (\(VT\)) de la variable respuesta será igual a:

\[VT = \sum_{i=1}^L \sum_{j=1}^{n_i}(y_{ij}-\bar y_{..})^2 = \sum_{i=1}^L \sum_{j=1}^{n_i}[(\bar y_{i.} - \bar y_{..}) + (y_{ij} - \bar y_{i.})]^2\]

Es fácilmente demostrable que:

\[2\sum_{i=1}^L \sum_{j=1}^{n_i}(\bar y_{i.} - \bar y_{..}) (y_{ij} - \bar y_{i.}) = 2\sum_{i=1}^L (\bar y_{i.} - \bar y_{..})\sum_{j=1}^{n_i} (y_{ij} - \bar y_{i.}) = 0\]

y por tanto:

\[VT = \sum_{i=1}^L \sum_{j=1}^{n_i}(\bar y_{i.} - \bar y_{..})^2 + \sum_{i=1}^L \sum_{j=1}^{n_i}(y_{ij} - \bar y_{i.})^2 = VE + VNE\]

El primer sumatorio de cuadrados constituye la variabilidad explicada (VE) por el modelo y el segundo la variabilidad no explicada (VNE), es decir:

\[VE=\sum_{i=1}^L \sum_{j=1}^{n_i}(\bar y_{i.} - \bar y_{..})^2 = \sum_{i=1}^L n_i(\bar{y}_{i.}-\bar{y}_{..})^2 = \sum_{i=1}^L n_i\hat \alpha_{i}^2\]

\[VNE=\sum_{i=1}^L \sum_{j=1}^{n_i} ({y}_{ij}-\bar{y}_{i.})^2 = \sum_{i=1}^L \sum_{j=1}^{n_i}e_{ij}^2\]

La tabla ANOVA queda, por tanto, como sigue:

Tabla nº 2. Tabla ANOVA. Modelo con un factor

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio | Estadistico \(F\) |

|---|---|---|---|---|

| Entre grupos | \(VE\) | \(L-1\) | \(\frac {VE}{L-1}=\hat S_R^2\) | \(\frac {\hat S_R^2}{\hat S_e^2}\) |

| Dentro de los grupos | \(VNE\) | \(n-L\) | \(\frac {VNE}{n-L}=\hat S_e^2\) | |

| Total | \(VT\) | \(n-1\) | \(\frac {VT}{n-1}=\hat S_y^2\) |

Si las medias de la autonomía de los vehículos fueran muy distintas entre sí y, además, la varianza dentro de cada grupo fuera pequeña (los grupos muy distintos entre sí y, dentro de cada grupo un comportamiento muy homogéneo), la variabilidad total sería debida a la diferencia entre grupos. Sin embargo, si las medias en los grupos fueran muy parecidas entre sí, dado que se supone que la varianza dentro de cada grupo es la misma, la variabilidad total sería debida a la variabilidad dentro de los grupos.

Para contrastar la hipótesis nula de igualdad de medias se construye el estadístico F, que compara la variabilidad debida a las diferencias entre los grupos y la variabilidad debida a la diferencia dentro de los grupos. El estadístico F nos ha de decir si tenemos pruebas suficientes” para rechazar o aceptar la hipótesis nula, y se distribuye según una F de Snedecor con L-1 grados de libertad en el numerador y N-L en el denominador. Si el p-valor asociado a este estadístico es menor que el grado de significación fijado, rechazaremos la hipótesis de igualdad de medias.

En términos del modelo planteado, la hipótesis nula es: \(H_0:\alpha_i=0 \ \ \forall i\).

En el siguiente “Chunk” construimos la tabla anova con la función “aov” (Analysis Of Variance) y estimamos un modelo ANOVA con la función “model.tables”. Finalmente, representamos las tres distribuciones a través de un diagrama de cajas múltiple.

summary(aov(mpg~as.factor(cyl),data=mtcars))## Df Sum Sq Mean Sq F value Pr(>F)

## as.factor(cyl) 2 824.8 412.4 39.7 4.98e-09 ***

## Residuals 29 301.3 10.4

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1model.tables(aov(mpg~as.factor(cyl),data=mtcars),type="means")## Tables of means

## Grand mean

##

## 20.09062

##

## as.factor(cyl)

## 4 6 8

## 26.66 19.74 15.1

## rep 11.00 7.00 14.0library(ggplot2)

ggplot(mtcars, aes(as.factor(cyl), mpg)) + geom_boxplot()

La hipótesis más relevante que deben cumplir los datos para poder aplicar un análisis de la varianza, es la hipótesis de homoscedasticidad, es decir, que la varianza de la variable dependiente (millas por galón) es constante en los grupos definidos por el factor (número de cilindros). Esta prueba puede realizarse a través de la función leveneTest de la librería car, y como vemos, existe heterocedasticidad, dado que el grupo de 4 cilindros presenta una variabilidad mayor al resto, tal como se puede intuir en el diagrama de cajas. También puede verse como a mayor número de cilindros la variabilidad disminuye.

library(car)## Loading required package: carDataleveneTest(mtcars$mpg,as.factor(mtcars$cyl),center=mean)## Levene's Test for Homogeneity of Variance (center = mean)

## Df F value Pr(>F)

## group 2 6.4843 0.004703 **

## 29

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1Algunos autores (Uriel, 1995; Stevens, 1986) afirman, sin embargo, que el estadístico F no se ve muy afectado por el hecho de que no exista homoscedasticidad siempre que las muestras de los diferentes grupos sean del mismo o similar tamaño. Se afirma que el estadístico se verá afectado cuando la razón entre el tamaño muestral del grupo de mayor tamaño y el más pequeño sea superior a 2.

Por otro lado, en el caso particular de que la hipótesis de homogeneidad de varianzas sea rechazada debido a que la varianza cambia con la media, existe una familia de transformaciones que proporciona, en general, homogeneidad en varianzas. Esta familia es de la forma:

\[T(X)=\begin{bmatrix} X^p \ \ si\ p\ne0\\ ln(X) \ \ si\ p=0 \end{bmatrix}\]

Aplicando el logaritmo neperiano, es decir, con p=0, obtenemos ya un p-valor no significativo en el test de Levene, y por tanto homogeneidad de varianzas, obteniendo como resultado del ANOVA lo siguiente:

library(car)

lnmpg <- log(mtcars$mpg)

cylf <- as.factor(mtcars$cyl)

leveneTest(lnmpg,cylf,center=mean)## Levene's Test for Homogeneity of Variance (center = mean)

## Df F value Pr(>F)

## group 2 1.6622 0.2073

## 29modelo.aov <- aov(lnmpg~cylf)

summary(modelo.aov)## Df Sum Sq Mean Sq F value Pr(>F)

## cylf 2 2.0081 1.0040 39.31 5.52e-09 ***

## Residuals 29 0.7407 0.0255

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1model.tables(modelo.aov)## Tables of effects

##

## cylf

## 4 6 8

## 0.3129 0.02292 -0.2573

## rep 11.0000 7.00000 14.0000Existen en R diferentes pruebas de cara a verificar la hipótesis de normalidad. Usando la variable transformada, y dado que la muestra es pequeña, optamos por el test de Shapiro-Wilk, donde como vemos, al no ser significativo (p-valor mayor que 0,05), podemos asumir que las distribuciones son normales:

logmpg <- split(log(mtcars$mpg), as.factor(mtcars$cyl))

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

print(shapiro.test(logmpg.i[[1]]))

}##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.91722, p-value = 0.2961

##

##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.89736, p-value = 0.3153

##

##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.89341, p-value = 0.09052Para muestras grandes, es preferible la prueba de Lilliefors (Kolmogorov-Smirnov), disponible en el paquete nortest. A pesar de que continuamente se alude al test Kolmogorov-Smirnov como un test válido para contrastar la normalidad, esto no es del todo cierto. Este test asume que se conoce la media y varianza poblacional, lo que en la mayoría de los casos no es posible. Esto hace que el test sea muy conservador y poco potente. Para solventar este problema, se desarrolló una modificación del Kolmogorov-Smirnov conocida como test Lilliefors. El test Lilliefors asume que la media y varianza son desconocidas, estando especialmente desarrollado para contrastar la normalidad. Es la alternativa al test de Shapiro-Wilk cuando el número de observaciones es mayor de 50.

Los resultados para nuestro ejemplo serían los siguientes:

library(nortest)

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

print(lillie.test(logmpg.i[[1]]))

}##

## Lilliefors (Kolmogorov-Smirnov) normality test

##

## data: logmpg.i[[1]]

## D = 0.16847, p-value = 0.5164

##

##

## Lilliefors (Kolmogorov-Smirnov) normality test

##

## data: logmpg.i[[1]]

## D = 0.2343, p-value = 0.2907

##

##

## Lilliefors (Kolmogorov-Smirnov) normality test

##

## data: logmpg.i[[1]]

## D = 0.19852, p-value = 0.1412El test de Jarque-Bera no requiere estimaciones de los parámetros que caracterizan la normal. El estadístico de Jarque-Bera cuantifica que tanto se desvían los coeficientes de asimetría y curtosis de los esperados en una distribución normal. Su formulación es la siguiente:

\[JB = \frac {n-k+1} {6} (S^2 + \frac {1} {4} (C-3)^2)\]

donde \(n\) es el número de observaciones (o grados de libertad en general); \(S\) es la asimetría de la muestra, \(C\) la curtosis y \(k\) el número de regresores.

El estadístico de Jarque-Bera se distribuye asintóticamente como una distribución chi cuadrado con dos grados de libertad y puede usarse para probar la hipótesis nula de que los datos pertenecen a una distribución normal. Como hipótesis nula se considera que la asimetría y el exceso de curtosis, conjuntamente, son nulos, es decir:

\[H_0: C=0;\ \ S=3\]

Puede calcularse mediante la función jarque.bera.test() del paquete tseries. Los resultados con este test serían:

library(tseries)

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

print(jarque.bera.test(logmpg.i[[1]]))

}##

## Jarque Bera Test

##

## data: logmpg.i[[1]]

## X-squared = 0.99886, df = 2, p-value = 0.6069

##

##

## Jarque Bera Test

##

## data: logmpg.i[[1]]

## X-squared = 0.71437, df = 2, p-value = 0.6996

##

##

## Jarque Bera Test

##

## data: logmpg.i[[1]]

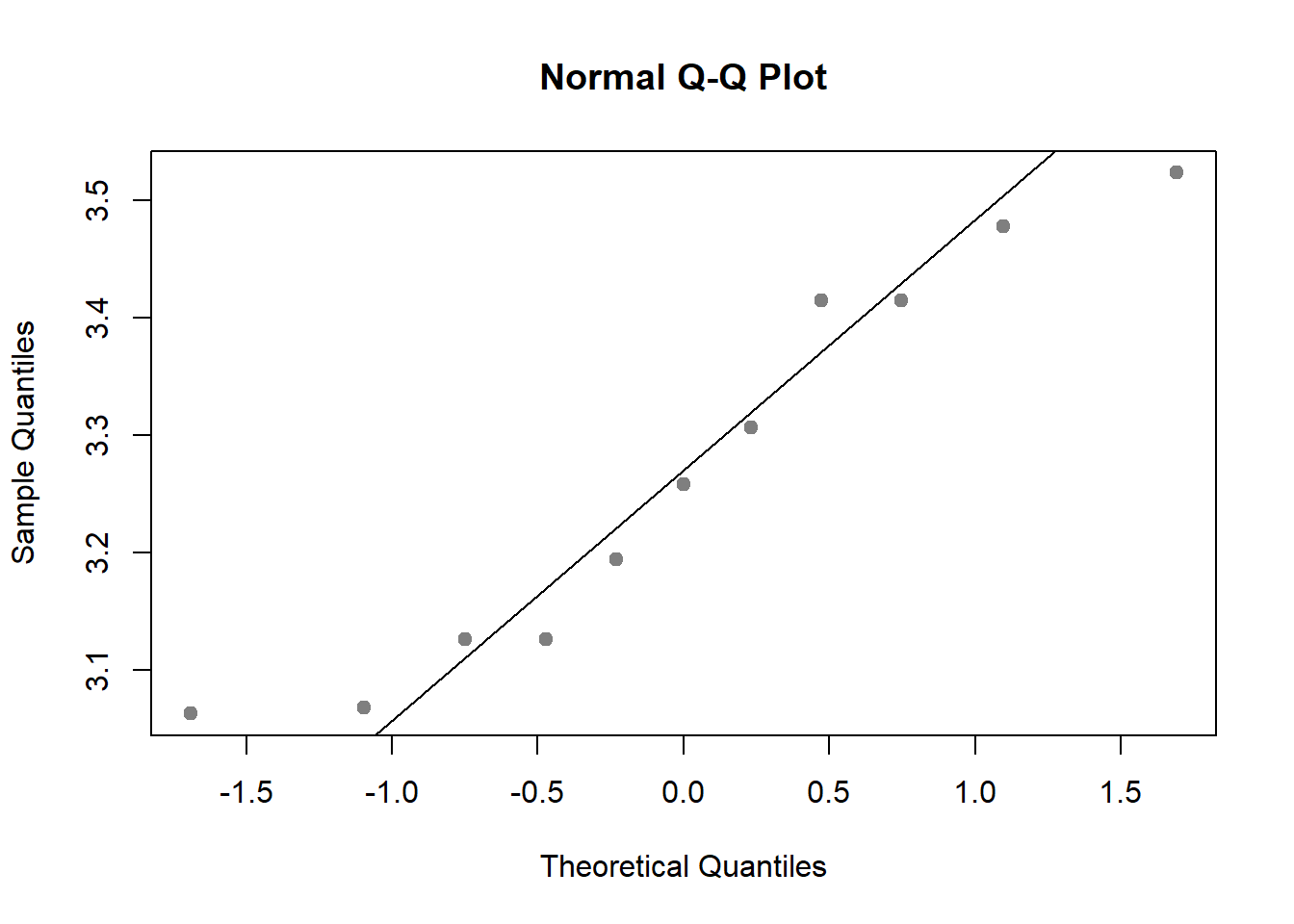

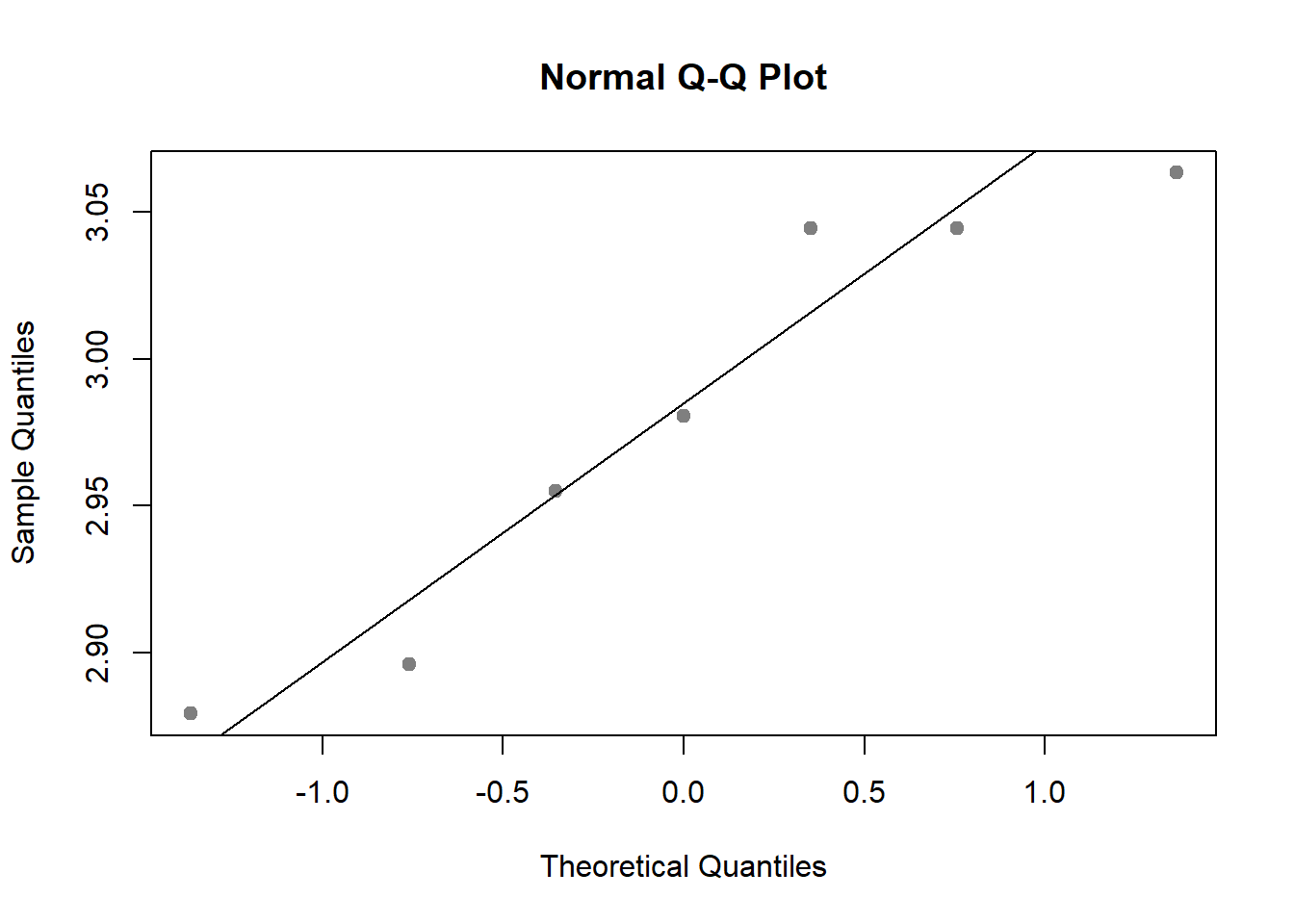

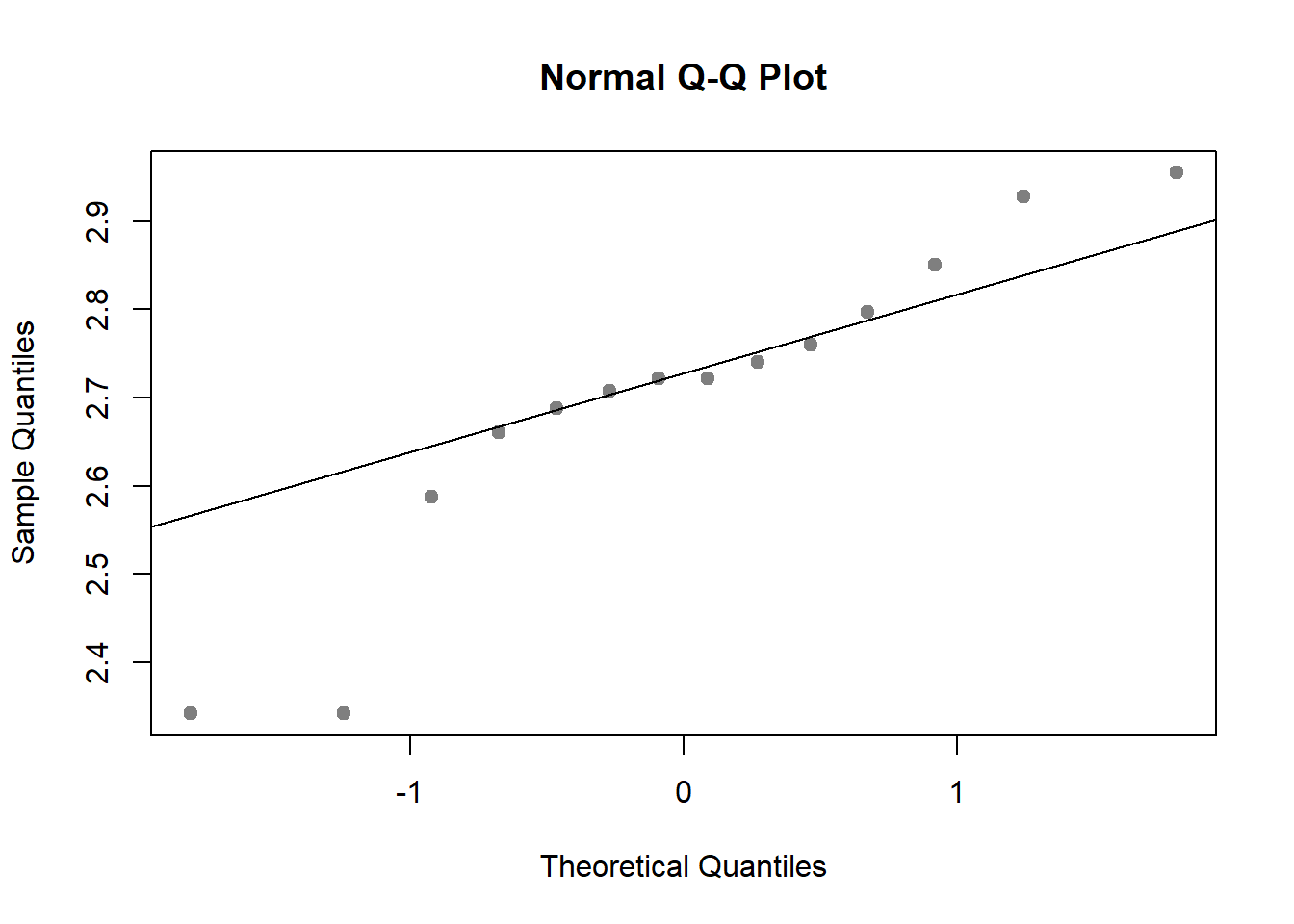

## X-squared = 1.549, df = 2, p-value = 0.4609También podemos utilizar métodos gráficos, representando el histograma junto a la curva normal teórica o el denominado gráfico de cuantiles teóricos (gráfico Q-Q). Este último, se realiza a partir de la función qqnorm.

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

qqnorm(logmpg.i[[1]], pch = 19, col = "gray50")

qqline(logmpg.i[[1]])

}

Con estos resultados, lo que sabemos es que alguna de las medias es diferente. Para averiguar que medias diieren de las otras, se pueden efectuar comparaciones de medias dos a dos y evaluar en cada caso las diferencias con el resto de los grupos.

Los dos procedimientos más utilizados para la comparación de medias por pares son los tests de Tukey y de Scheffe. El primero será preferible en modelos balanceados, en el caso de no balanceados, como el ejemplo que estamos realizando, optaremos por Scheffe.

El test de Scheffe está disponible en el paquete agricolae, disponiendo de dos opciones de presentación de resultados. Si queremos agrupar los niveles del factor con medias similares, especificamos la opción group=TRUE.

library(agricolae)

scheffe.test(modelo.aov,"cylf", group=TRUE,console=TRUE,

main="Autonomía según cilindrada")##

## Study: Autonomía según cilindrada

##

## Scheffe Test for lnmpg

##

## Mean Square Error : 0.02553996

##

## cylf, means

##

## lnmpg std r Min Max

## 4 3.270454 0.16762136 11 3.063391 3.523415

## 6 2.980439 0.07431982 7 2.879198 3.063391

## 8 2.700171 0.18113932 14 2.341806 2.954910

##

## Alpha: 0.05 ; DF Error: 29

## Critical Value of F: 3.327654

##

## Groups according to probability of means differences and alpha level( 0.05 )

##

## Means with the same letter are not significantly different.

##

## lnmpg groups

## 4 3.270454 a

## 6 2.980439 b

## 8 2.700171 cSi lo que buscamos es realizar todas las comparaciones de pares posibles, debemos especificar la opción group=FALSE.

library(agricolae)

scheffe.test(modelo.aov,"cylf", group=FALSE,console=TRUE,

main="Autonomía según cilindrada")##

## Study: Autonomía según cilindrada

##

## Scheffe Test for lnmpg

##

## Mean Square Error : 0.02553996

##

## cylf, means

##

## lnmpg std r Min Max

## 4 3.270454 0.16762136 11 3.063391 3.523415

## 6 2.980439 0.07431982 7 2.879198 3.063391

## 8 2.700171 0.18113932 14 2.341806 2.954910

##

## Alpha: 0.05 ; DF Error: 29

## Critical Value of F: 3.327654

##

## Comparison between treatments means

##

## Difference pvalue sig LCL UCL

## 4 - 6 0.2900143 0.0032 ** 0.1145018 0.4655268

## 4 - 8 0.5702825 0.0000 *** 0.4240221 0.7165429

## 6 - 8 0.2802682 0.0029 ** 0.1122278 0.4483086Como puede observarse, a mayor número de cilindros se obtiene una menor autonomía, es decir, un mayor consumo de combustible, siendo todas las comparaciones estadísticamente significativas.

Para realizar el test de Tukey, se ha de utilizar la función glht del paquete multcomp. Los resultados para nuestro ejemplo serían los siguientes:

require(multcomp)## Loading required package: multcomp## Loading required package: mvtnorm## Loading required package: survival## Loading required package: TH.data##

## Attaching package: 'TH.data'## The following object is masked from 'package:MASS':

##

## geysersummary(glht(modelo.aov, linfct = mcp(cylf = "Tukey")))##

## Simultaneous Tests for General Linear Hypotheses

##

## Multiple Comparisons of Means: Tukey Contrasts

##

##

## Fit: aov(formula = lnmpg ~ cylf)

##

## Linear Hypotheses:

## Estimate Std. Error t value Pr(>|t|)

## 6 - 4 == 0 -0.29001 0.07727 -3.753 0.00222 **

## 8 - 4 == 0 -0.57028 0.06439 -8.857 < 0.001 ***

## 8 - 6 == 0 -0.28027 0.07398 -3.788 0.00189 **

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

## (Adjusted p values reported -- single-step method)5.2.2 Análisis de la varianza con dos factores

En el ejemplo anterior estudiábamos el posible efecto del número de cilindros del motor en el consumo de combustible de los vehículos. Imaginemos ahora que se desea estudiar además el posible efecto del tipo de transmisión (automática [0] o manual [1]).

Podríamos pensar que es necesario llevar a cabo un análisis de la varianza de un factor para cada uno de ellos, sin embargo es posible trabajar con las dos variables independientes de manera simultánea en un único estudio.

El diseño experimental que se sigue en estos casos, es conocido como diseño factorial, donde dos o más variables independientes son manipuladas en un único estudio de tal forma que en el análisis se representan todas las posibles combinaciones de los diversos niveles de las variables independientes. Teóricamente, aunque un diseño factorial puede incluir cualquier número de variables independientes, en la práctica resulta poco adecuado utilizar más de tres o cuatro.

En síntesis, en nuestro caso queremos constatar si:

La autonomía de los vehículos varía dependiendo del número de cilindros del motor.

La autonomía de los vehículos varía dependiendo del tipo de transmisión.

La autonomía de los vehículos varía de forma conjunta según el número de cilindros del motor y el tipo de transmisión.

Modelo

El modelo matemático subyacente es el siguiente:

\[y_{ijk} = \mu + \alpha_i + \beta_j + (\alpha\beta)_{ij} + u_{ijk}\]

siendo \(\alpha_i\) el efecto del primer factor, \(\beta_j\) el del segundo y \((\alpha\beta)_{ij}\) la interacción entre ambos.

La estimación de estos parámetros teóricos se realiza, análogamente al caso anterior, del siguiente modo:

\[\hat \mu = \bar y_{...} \ \ \ \ \ \ \ \ \ \ \ \hat \alpha_i = \bar y_{i..} - \bar y_{...} \ \ \ \ \ \ \ \ \ \ \ \hat \beta_j = \bar y_{.j.} - \bar y_{...} \ \ \ \ \ \ \ \ \ \ \ \hat {(\alpha\beta)}_{ij} = \bar y_{ij.} - \bar y_{i..} -\bar y_{.j.} + \bar y_{...}\] \[\hat \mu_{ij} = \hat \mu + \hat \alpha_i + \hat \beta_i + \hat {(\alpha\beta)}_{ij}\ \ \ \ \ \ \ \ \ \ \ \hat u_{ijk}= e_{ijk} = y_{ijk} - \bar y_{ij.}\]

Siendo \(\bar y_{i..}\), \(\bar y_{.j.}\) y \(\bar y_{ij.}\) las medias muestrales para el primer factor, para el segundo y para el cruce de ambos respectivamente..

El modelo estimado queda por tanto:

\[y_{ijk} = \bar y_{...} + (\bar y_{i..} - \bar y_{...}) + (\bar y_{.j.} - \bar y_{...}) + (\bar y_{ij.} - \bar y_{i..} - \bar y_{.j.} + \bar y_{...}) + (y_{ijk} - \bar y_{ij.})\]

Tabla ANOVA

De una manera similar al caso de un factor, la varianza total puede descomponerse del siguiente modo (donde I es el número total de grupos del primer factor, en nuestro caso, los tres niveles del número de cilindros; J es el número total de grupos del segundo factor, en nuestro caso 2, transmisión automática y manual):

\[VT = \sum_{i=1}^I \sum_{j=1}^J \sum_{k=1}^{n_{ij}} ({y}_{ijk} - \bar{y}_{...})^2 = \sum_{i=1}^I \sum_{j=1}^J n_{ij} (\bar {y}_{ij.} - \bar{y}_{...})^2 + \sum_{i=1}^I \sum_{j=1}^J \sum_{k=1}^{n_{ij}} ({y}_{ijk} - \bar{y}_{ij.})^2 = VE + VNE\]

El primer término de la expresión anterior refleja la suma de los cuadrados con respecto a la media muestral global. El triple sumatorio se refiere: el primero a los niveles del primer factor (número de cilindros), el segundo a los del segundo factor (tipo de transmisión) y el tercero a los datos individuales del cruce de los dos anteriores.

El segundo término de la expresión se descompone en dos sumandos. El primero refleja las diferencias al cuadrado entre la media de cada celda y la media global, y constituye la variabilidad explicada por el modelo \(VE\), mientras que el segundo sumando es la suma de cuadrados residual o variación no explicada \(VNE\).

Lo interesante está en analizar qué ocasiona las diferencias del primer sumando, es decir, las diferencias al cuadrado entre la media de cada celda. Puede demostrarse que:

\[VE = \sum_{i=1}^I \sum_{j=1}^J n_{ij} (\bar{y}_{ij.} - \bar{y}_{...})^2 = \sum_{i=1}^I \sum_{j=1}^J n_{ij} (\bar{y}_{i..} - \bar{y}_{...})^2 + \sum_{i=1}^I \sum_{j=1}^J n_{ij} (\bar{y}_{.j.} - \bar{y}_{...})^2 +\] \[+\sum_{i=1}^I \sum_{j=1}^J \sum_{k=1}^{n_{ij}} (\bar{y}_{ij.} - \bar{y}_{i..} - \bar{y}_{.j.} + \bar{y}_{...})^2 = VE_A + VE_B + VE_{AxB}\]

Se ve claramente en esta expresión que los dos primeros sumandos corresponden a sumas; las denominaremos \(VE_A\) y \(VE_B\) y reflejan la variabilidad explicada por cada uno de los dos factores. El último término refleja la interacción de los factores A y B, es decir, el efecto de los dos factores que no es debido individualmente a ninguno de ellos. El efecto interacción, será denominado \(VE_{AxB}\).

La interacción será significativa si el comportamiento de la variable respuesta en un factor es diferente en función de los niveles del otro factor. Así, partiendo de nuestro ejemplo, hemos visto que en media el consumo de combustible aumenta a medida que aumenta el número de los cilindros del motor. Si consideramos el tipo de transmisión, y resultara que esto ocurre en los coches automáticos, pero en los manuales disminuyera el consumo con el aumento del número de cilindros, existirá efecto de interacción.

En síntesis, la suma total de cuadrados puede descomponerse, en el caso de dos factores del siguiente modo:

\[VT = VE_A+VE_B+VE_{AxB}+VNE\]

Al igual que en el caso de un factor, cada suma de cuadrados tiene sus propios grados de libertad, igual al número de niveles del factor menos 1. Los grados de libertad asociados a la interacción será la multiplicación de los asociados a ambos factores, es decir, \((I-1)*(J-1)\). Se muestra a continuación la tabla ANOVA donde se construye cada uno de los estadísticos F que, ahora, han de permitirnos determinar si el efecto de cada factor por separado y la interacción de ambos, son o no significativos.

Tabla nº 3. Tabla ANOVA. Modelo con dos factores e interacción

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio (MC) | E(MC) | Estadistico \(F\) |

|---|---|---|---|---|---|

| Factor A | \(VE_A=JK\sum_i\hat\alpha_i^2\) | \(I-1\) | \(MCF_A=\frac{VE_A}{I-1}\) | \(\sigma^2+JK\frac{\sum\alpha_i^2}{I-1}\) | \(F=\frac{MCF_A}{MCR}\) |

| Factor B | \(VE_B=IK\sum_j\hat\beta_j^2\) | \(J-1\) | \(MCF_B=\frac{VE_B}{J-1}\) | \(\sigma^2+IK\frac{\sum\beta_j^2}{J-1}\) | \(F=\frac{MCF_B}{MCR}\) |

| Interacción | \(VE_{AxB}=K\sum_{ij}\hat {(\alpha\beta)}_{ij}^2\) | \((I-1)(J-1)\) | \(MCF_{AxB}=\frac{VE_{AxB}}{(I-1)(J-1)}\) | \(\sigma^2+K\frac{\sum(\alpha\beta)_j^2}{(I-1)(J-1)}\) | \(F=\frac{MCF_{AxB}}{MCR}\) |

| Error o residual | \(VNE=\sum_{ijk}e_{ijk}\) | \(IJ(K-1)=n-IJ\) | \(MCR=\frac{VNE}{n-IJ}\) | \(\sigma^2\) | |

| Total | \(VT=VE_A+VE_B+VNE\) | \(n-1\) | \(MCT=\frac {VT}{n-1}\) |

La columna E(MC) hace referencia al valor esperado o esperanza matemática de las varianzas o medias cuadráticas de las distintas fuentes de variación. Esta esperanza, como puede observarse, es igual a la suma de la varianza residual y J*K veces la media cuadrática del propio factor. Al construir los estadísticos F como el cociente entre la media cuadrática estimada para cada factor y la del error, en términos de esperanza, obtenemos (tomando como ejemplo el factor A):

\[\frac{E(MCF_A)}{E(MCR)} = \frac{\sigma^2+JK\frac{\sum\alpha_j^2}{I-1}}{\sigma^2}\]

Por tanto, si consideramos válida la hipótesis nula correspondiente a \(\alpha_i=0\) \(\forall i\), la esperanza matemática del estadítico F será igual a 1, aumentando su valor a medida que aumenta la media cuadrática del factor.

Se muestra a continuación el ANOVA planteado en R, donde como vemos, tanto el tipo de transmisión como la interacción de éste con el número de cilindros resultan ser no significativos.

lnmpg <- log(mtcars$mpg)

cylf <- as.factor(mtcars$cyl)

amf <- as.factor(mtcars$am)

# Test de Levene para factor Número de cilindros

leveneTest(lnmpg,cylf,center=mean)## Levene's Test for Homogeneity of Variance (center = mean)

## Df F value Pr(>F)

## group 2 1.6622 0.2073

## 29# Test de Levene para factor Tipo de transmisión

leveneTest(lnmpg,amf,center=mean)## Levene's Test for Homogeneity of Variance (center = mean)

## Df F value Pr(>F)

## group 1 0.4653 0.5004

## 30# Test de Shapiro-Wilk para factor Número de cilindros

logmpg <- split(log(mtcars$mpg), as.factor(mtcars$cyl))

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

print(shapiro.test(logmpg.i[[1]]))

}##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.91722, p-value = 0.2961

##

##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.89736, p-value = 0.3153

##

##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.89341, p-value = 0.09052# Test de Shapiro-Wilk para factor Tipo de transmisión

logmpg <- split(log(mtcars$mpg), as.factor(mtcars$am))

for (i in 1:length(logmpg)){

logmpg.i <- as.vector(logmpg[i])

print(shapiro.test(logmpg.i[[1]]))

}##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.9557, p-value = 0.4909

##

##

## Shapiro-Wilk normality test

##

## data: logmpg.i[[1]]

## W = 0.94212, p-value = 0.485# Modelo ANOVA

modelo.aov <- aov(lnmpg~cylf+amf+cylf:amf)

summary(modelo.aov)## Df Sum Sq Mean Sq F value Pr(>F)

## cylf 2 2.0081 1.0040 40.362 1.06e-08 ***

## amf 1 0.0681 0.0681 2.737 0.110

## cylf:amf 2 0.0258 0.0129 0.519 0.601

## Residuals 26 0.6468 0.0249

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1model.tables(modelo.aov)## Tables of effects

##

## cylf

## 4 6 8

## 0.3129 0.02292 -0.2573

## rep 11.0000 7.00000 14.0000

##

## amf

## 0 1

## -0.03253 0.04754

## rep 19.00000 13.00000

##

## cylf:amf

## amf

## cylf 0 1

## 4 -0.061 0.023

## rep 3.000 8.000

## 6 0.015 -0.020

## rep 4.000 3.000

## 8 0.010 -0.061

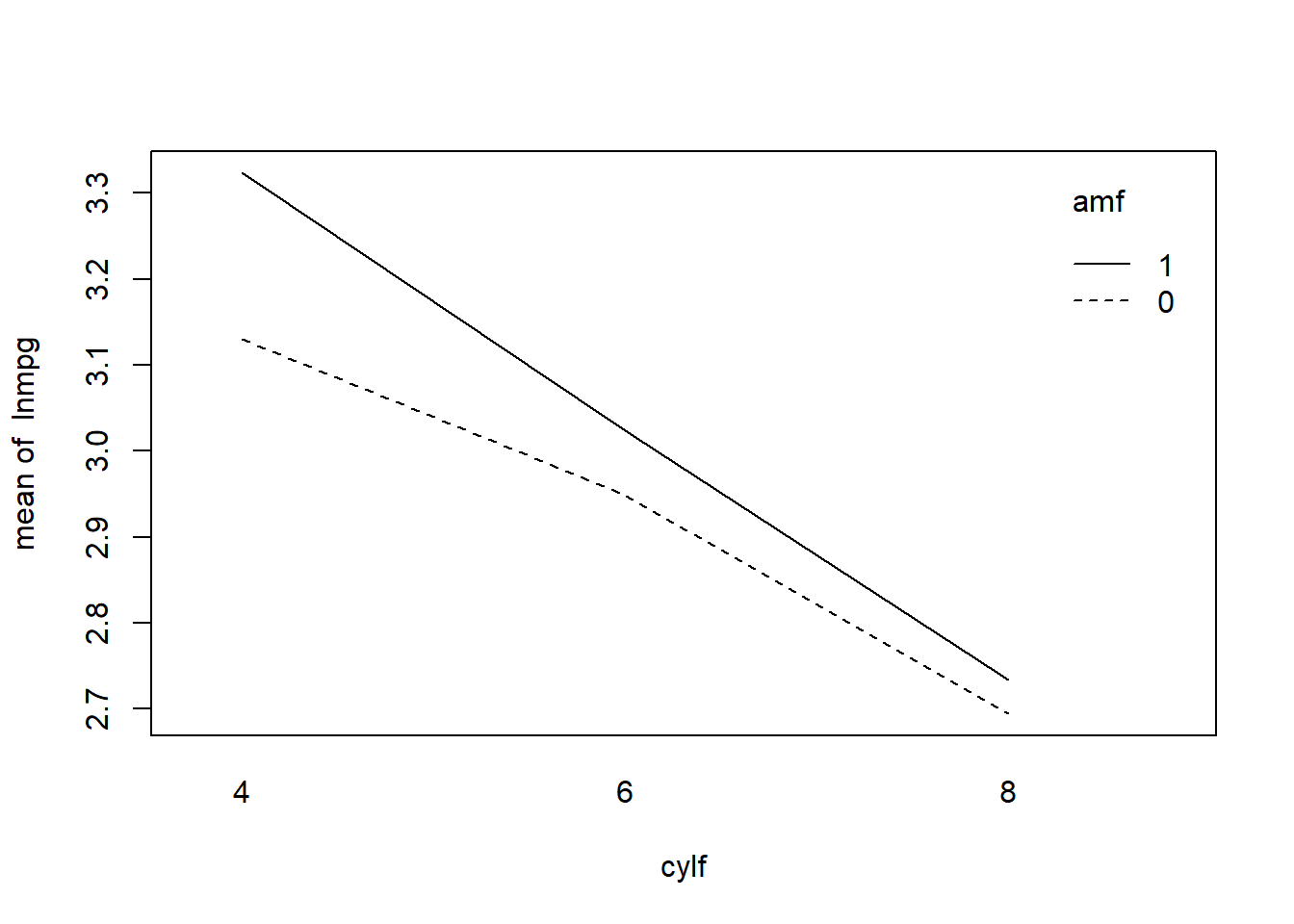

## rep 12.000 2.000Por último, el gráfico de interacción se construye del siguiente modo:

interaction.plot(cylf,amf,lnmpg)

donde si bien puede apreciarse un ligero mayor consumo de los vehículos automáticos (menor autonomía), dicha diferencia, eliminando el efecto del número de cilindros, no llega a ser estadísticamente significativa, tal y como hemos visto.

5.2.3 Modelos con más de dos factores

La generalización del modelo de dos factores con interacción a uno con tres o más factores es inmediata.

Por ejemplo, es fácil comprobar que en el diseño factorial completo de tres factores con réplicas, incluyendo la interacción de tercer orden, quedaría:

\[y_{ijkl} = \mu + \alpha_i + \beta_j + \gamma_k + (\alpha\beta)_{ij} + (\alpha\gamma)_{ik} + (\beta\gamma)_{jk} + (\alpha\beta\gamma)_{ijk} + u_{ijkl}\]

la variabilidad total (\(VT\)) se desglosa en:

\[VT = VE_A +VE_B + VE_C + VE_{AxB} + VE_{AxC} + VE_{BxC} + VE_{AxBxC} + VNE\]

y la tabla ANOVA:

Tabla nº 4. Tabla ANOVA. Modelo con tres factores e interacción

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio | Estadistico \(F\) |

|---|---|---|---|---|

| Factor A | \(VE_A\) | \(I-1\) | \(MCF_A=\frac{VE_A}{I-1}\) | \(F=\frac{MCF_A}{MCR}\) |

| Factor B | \(VE_B\) | \(J-1\) | \(MCF_B=\frac{VE_B}{J-1}\) | \(F=\frac{MCF_B}{MCR}\) |

| Factor C | \(VE_C\) | \(K-1\) | \(MCF_C=\frac{VE_C}{K-1}\) | \(F=\frac{MCF_C}{MCR}\) |

| Interacción AxB | \(VE_{AxB}\) | \((I-1)(J-1)\) | \(MCF_{AxB}=\frac{VE_{AxB}}{(I-1)(J-1)}\) | \(F=\frac{MCF_{AxB}}{MCR}\) |

| Interacción AxC | \(VE_{AxC}\) | \((I-1)(K-1)\) | \(MCF_{AxC}=\frac{VE_{AxC}}{(I-1)(K-1)}\) | \(F=\frac{MCF_{AxC}}{MCR}\) |

| Interacción BxC | \(VE_{BxC}\) | \((J-1)(K-1)\) | \(MCF_{BxC}=\frac{VE_{BxC}}{(J-1)(K-1)}\) | \(F=\frac{MCF_{BxC}}{MCR}\) |

| Interacción AxBxC | \(VE_{AxBxC}\) | \((I-1)(J-1)(K-1)\) | \(MCF_{AxBxC}=\frac{VE_{AxBxC}}{(I-1)(J-1)(K-1)}\) | \(F=\frac{MCF_{AxBxC}}{MCR}\) |

| Error o residual | \(VNE\) | \(n-IJK\) | \(MCR=\frac{VNE}{n-IJK}\) | |

| Total | \(VT\) | \(n-1\) | \(MCT=\frac {VT}{n-1}\) |

Al igual que en el modelo de regresión, es conveniente la aplicación de técnicas se selección de factores (fordward, backward, stepwise). Al eliminar los efectos no significativos del modelo, además de facilitar su interpretación, ganamos grados de libertad en el término error y reducimos su variabilidad.

5.3 Modelos de componentes de la varianza: efectos aleatorios

Como hemos visto hasta ahora, el factor es una variable independiente o experimental controlada por el investigador. Puede tomar pocos o muchos valores o niveles, a cada uno de los cuales se asignan los grupos o muestras.

Si se toman L niveles y las inferencias se refieren exclusivamente a los L niveles y no a otros que podrían haber sido incluidos, el ANOVA se llama de efectos fijos, sistemático o paramétrico. El interés del diseño se centra en saber si esos niveles concretos difieren entre sí.

Cuando los niveles son muchos y se seleccionan al azar L niveles, pero las inferencias se desean hacer respecto al total de niveles, el análisis de varianza se denomina de efectos aleatorios. La idea básica es que el investigador no tiene interés en niveles particulares del factor.

Los modelos basados en factores aleatorios se denominan Componentes de la varianza, y lo que se persigue es evaluar la cantidad de variación de la variable dependiente que se asocia con una o más variables de efectos aleatorios.

5.3.1 Modelo de un factor aleatorio

En estos modelos se mide que parte de la variabilidad de la respuesta es debida al factor. Dado que el factor es una variable aleatoria, la variabilidad observada en el experimento será:

\[\sigma^2_y = \sigma^2_{\alpha} + \sigma^2\]

Por tanto, lo que se pretende averiguar es si \(\sigma^2_{\alpha}\) es igual a 0 (hipótesis nula) o, por el contrario, el factor incorpora al experimento una variabilidad significativa.

El modelo queda por tanto:

\[y_{ik} = \mu + \alpha_i + u_{ik}\]

con \(\alpha_i \rightarrow N(0,\sigma^2_{\alpha})\) y \(u_{ik} \rightarrow N(0,\sigma^2)\), siendo la hipótesis nula del modelo:

\[H_0: \sigma^2_{\alpha} = 0\]

De forma análoga al modelo con efectos fijos, los estimadores de los parámetros del modelo serían:

\[\hat \mu = \bar y_{..}\] \[\hat \alpha_i = \bar y_{i.} - \bar y_{..}\]

\[e_{ik} = y_{ik} - \bar y_{i.}\]

donde la descomposición de la variabilidad quedaría:

\[VE(\alpha) = K \sum_{i=1}^I(\bar y_{i.} - \bar y_{..})^2\] \[VNE = \sum_{i=1}^I \sum_{k=1}^K (y_{ik} - \bar y_{i.})^2 = \sum_{i=1}^I \sum_{k=1}^K e^2_{ik}\] \[VT = VE(\alpha) + VNE\]

quedando la tabla ANOVA de la siguiente manera:

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio (MC) | E(MC) | Estadistico \(F\) |

|---|---|---|---|---|---|

| Entre grupos (VE) | \(VE(\alpha)\) | \(I-1\) | \(\hat S^2_{\alpha}=\frac{VE(\alpha)}{I-1}\) | \(\sigma^2+K\sigma^2_{\alpha}\) | \(F=\frac{\hat S^2_{\alpha}}{\hat S^2_R}\) |

| Interna (VNE) | \(VNE\) | \(I(K-1)\) | \(\hat S^2_R=\frac{VNE}{n-I}\) | \(\sigma^2\) | |

| Total | \(VT=VE+VNE\) | \((I-1)+I(K-1)=n-1\) | \(\hat S^2_y=\frac {VT}{n-1}\) |

Si \(\alpha\) fuera un efecto fijo, recordar que la esperanza de la media cuadrática sería:

\[E(MC(\alpha)) = \sigma^2 + K \frac {\sum_{i=1}^I\alpha_i^2} {I-1}\] es decir, cambian las esperanzas de las medias cuadráticas.

Teniendo en cuenta las esperanzas de las medias cuadráticas, las variabilidades del error (interna) y entre grupos se estimarían del siguiente modo:

\[\hat \sigma^2 = \hat S^2_R\] \[\hat S^2_{\alpha} = \hat \sigma^2 + K \hat \sigma^2_{\alpha} => \] \[\hat \sigma^2_{\alpha} = \frac {\hat S^2_{\alpha}-\hat S^2_R} {K}\]

5.3.2 Modelo de dos factores aleatorios con interacción

En este modelo la variabilidad observada en el experimento será:

\[\sigma^2_y = \sigma^2_{\alpha} + \sigma^2_{\beta} + \sigma^2_{\alpha\beta} + \sigma^2\]

El modelo a estimar sería el siguiente:

\[y_{ijk} = \mu + \alpha_i + \beta_j + \alpha\beta_{ij} + u_{ijk}\]

con \(\alpha_i \rightarrow N(0,\sigma^2_{\alpha})\), \(\beta_j \rightarrow N(0,\sigma^2_{\beta})\) y \(u_{ijk} \rightarrow N(0,\sigma^2)\), siendo las hipótesis nulas del modelo:

\[H_{01}: \sigma^2_{\alpha} = 0\] \[H_{02}: \sigma^2_{\beta} = 0\] \[H_{03}: \sigma^2_{\alpha\beta} = 0\]

Los estimadores de los parámetros del modelo se calculan del siguiente modo:

\[\hat \mu = \bar y_{...}\] \[\hat \alpha_i = \bar y_{i..} - \bar y_{...}\] \[\hat \beta_j = \bar y_{.j.} - \bar y_{...}\] \[\hat {\alpha\beta_j} = \bar y_{ij.} - \bar y_{i..} - \bar y_{.j.} + \bar y_{...}\] \[e_{ijk} = y_{ijk} - \bar y_{ij.}\]

y la descomposición de la variabilidad quedaría:

\[VE(\alpha) = JK \sum_{i=1}^I\hat \alpha_i^2 \ \ \ \ \ \ \ VE(\beta) = IK \sum_{j=1}^I\hat \beta_j^2 \ \ \ \ \ \ \ VE(\alpha\beta) = K \sum_{i=1}^I \sum_{j=1}^J\hat {\alpha\beta_j}^2\] \[VNE = \sum_{i=1}^I \sum_{j=1}^J \sum_{k=1}^K (y_{ijk} - \bar y_{ij.})^2 = \sum_{i=1}^I \sum_{j=1}^J \sum_{k=1}^K e^2_{ijk}\] \[VT = VE(\alpha) + VE(\beta) + VE(\alpha\beta) + VNE\]

quedando la tabla ANOVA de la siguiente manera:

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio (MC) | E(MC) | Estadistico \(F\) |

|---|---|---|---|---|---|

| Tratamiento A | \(VE(\alpha)\) | \(I-1\) | \(\hat S^2_{\alpha}=\frac{VE(\alpha)}{I-1}\) | \(\sigma^2+JK\sigma^2_{\alpha}+K\sigma^2_{\alpha\beta}\) | \(F_\alpha=\frac{\hat S^2_{\alpha}}{\hat S^2_{\alpha\beta}}\) |

| Tratamiento B | \(VE(\beta)\) | \(J-1\) | \(\hat S^2_{\beta}=\frac{VE(\beta)}{J-1}\) | \(\sigma^2+IK\sigma^2_{\beta}+K\sigma^2_{\alpha\beta}\) | \(F_\beta=\frac{\hat S^2_{\beta}}{\hat S^2_{\alpha\beta}}\) |

| Interacción | \(VE(\alpha\beta)\) | \((I-1)(J-1)\) | \(\hat S^2_{\alpha\beta}=\frac{VE(\alpha\beta)}{(I-1)(J-1)}\) | \(\sigma^2+K\sigma^2_{\alpha\beta}\) | \(F_{\alpha\beta}=\frac{\hat S^2_{\alpha\beta}}{\hat S^2_R}\) |

| Error (VNE) | \(VNE\) | \(IJ(K-1)\) | \(\hat S^2_R=\frac{VNE}{IJ(K-1)}\) | \(\sigma^2\) | |

| Total | \(VT=VE+VNE\) | \(n-1\) | \(\hat S^2_y=\frac {VT}{n-1}\) |

Como vemos, el denominador del test en los efectos principales es ahora la Media Cuadrática de la interacción.

5.3.3 Modelos con más de dos factores y modelos mixtos

Al igual que en el caso de los modelos ANOVA con efectos fijos, analizamos a continuación el modelo con tres efectos aleatorios y las correspondientes interacciones. Como veremos a continuación, la generalización a más de dos factores es también directa, si bien se complica la construcción de las pruebas F para los tres efectos principales.

Los grados de libertad y las esperanzas de las medias cuadráticas quedarían en este caso:

| Fuente de variación | Grados de libertad | E(MC) |

|---|---|---|

| Tratamiento A | \(I-1\) | \(\sigma^2+JKL\sigma^2_{\alpha}+KL\sigma^2_{\alpha\beta}+JL\sigma^2_{\alpha\gamma}+L\sigma^2_{\alpha\beta\gamma}\) |

| Tratamiento B | \(J-1\) | \(\sigma^2+IKL\sigma^2_{\beta}+KL\sigma^2_{\alpha\beta}+IL\sigma^2_{\beta\gamma}+L\sigma^2_{\alpha\beta\gamma}\) |

| Tratamiento C | \(K-1\) | \(\sigma^2+IJL\sigma^2_{\gamma}+JL\sigma^2_{\alpha\gamma}+IL\sigma^2_{\beta\gamma}+L\sigma^2_{\alpha\beta\gamma}\) |

| Interacción AB | \((I-1)(J-1)\) | \(\sigma^2+KL\sigma^2_{\alpha\beta}+L\sigma^2_{\alpha\beta\gamma}\) |

| Interacción AC | \((I-1)(K-1)\) | \(\sigma^2+JL\sigma^2_{\alpha\gamma}+L\sigma^2_{\alpha\beta\gamma}\) |

| Interacción BC | \((J-1)(K-1)\) | \(\sigma^2+IL\sigma^2_{\beta\gamma}+L\sigma^2_{\alpha\beta\gamma}\) |

| Interacción ABC | \((I-1)(J-1)(K-1)\) | \(\sigma^2+L\sigma^2_{\alpha\beta\gamma}\) |

| Error (VNE) | \(IJK(L-1)\) | \(\sigma^2\) |

Como puede observarse, en el cálculo de la esperanza de la media cuadrática o varianza de cada fuente de variación o efecto, interviene la varianza del error, la de la propio efecto y la de todas aquellas interacciones donde aparezca dicho efecto.

Teniendo en cuenta estas esperanzas, es inmediato el cálculo de los estadísticos F para contrastar los efectos de las interacciones:

\[F_{\alpha\beta\gamma} = \frac {\hat S^2_{\alpha\beta\gamma}} {\hat S^2_R}\] \[F_{\alpha\beta} = \frac {\hat S^2_{\alpha\beta}} {\hat S^2_{\alpha\beta\gamma}}\] \[F_{\alpha\gamma} = \frac {\hat S^2_{\alpha\gamma}} {\hat S^2_{\alpha\beta\gamma}}\] \[F_{\beta\gamma} = \frac {\hat S^2_{\beta\gamma}} {\hat S^2_{\alpha\beta\gamma}}\]

Para los efectos principales (A, B, C) necesitamos estimar una media cuadrática para el denominador de la prueba. Suponiendo que estamos evaluando el efecto A, se pueden considerar.

\[F_{\alpha} = \frac {\hat S^2_{\alpha}} {\hat S^2_{\alpha\beta}+\hat S^2_{\alpha\gamma}-\hat S^2_{\alpha\beta\gamma}}\] \[F'_{\alpha} = \frac {\hat S^2_{\alpha}+\hat S^2_{\alpha\beta\gamma}} {\hat S^2_{\alpha\beta}+\hat S^2_{\alpha\gamma}}\]

Los grados de libertad de las sumas de las medias cradráticas (denominador de \(F_{\alpha}\) y numerador y denominador de \(F'_{\alpha}\)) se calculan en base al procedimiento de Satterthwaite.

Este procedimiento establece que dada una función lineal M definida como:

\[M = \alpha_1 · (MC)_1 + \alpha_2 · (MC)_2 + \cdots + \alpha_k · (MC)_k\]

siendo \((MC)_1, (MC)_2, \cdots , (MC)_k\) cuadrados medios con grados de libertad \(v_1, v_2, \cdots , v_k\).

Los grados de libertad para M son aproximadamente:

\[v = \frac {M^2} {\sum_{i=1}^k \frac {(\alpha_i · (MC)_i)^2} {v_i}}\]

Cuando se utilizan dos o más factores, cada uno con varios niveles, unos de efectos fijos y otros de efectos aleatorios, el análisis de varianza es mixto.

La función de R que permite estimar modelos ANOVA con efectos aleatorios se encuentra en la libreria “nlme”.

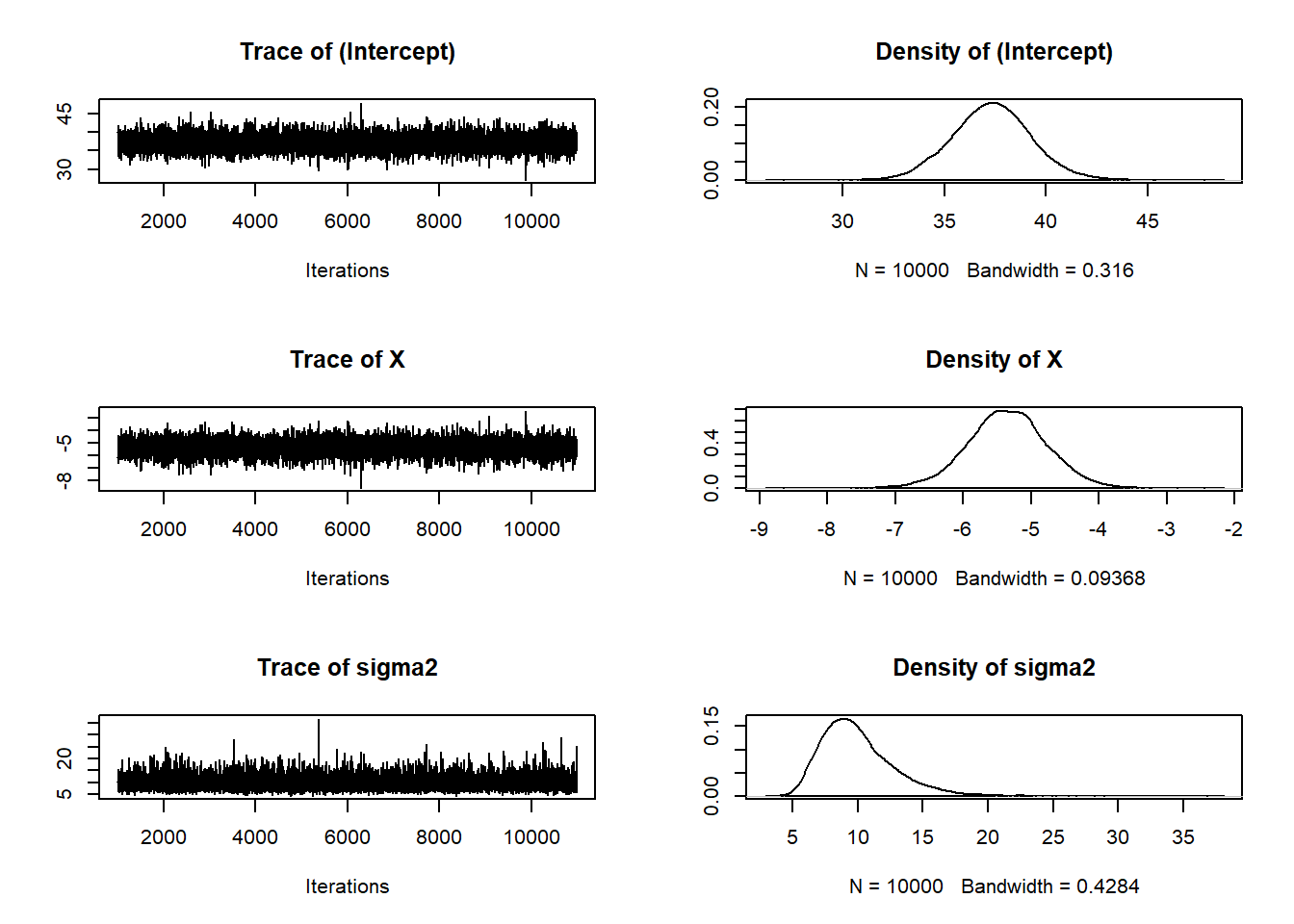

Con la base de datos Orthodontic de R, que contiene datos de medidas ortodónticas se plantea un modelo ANOVA de efectos aleatorios sobre un solo factor, y un modelo mixto, en donde la constante es el factor aleatorio y utiliza dos factores fijos: la edad y el sexo.

library(nlme)

data("Orthodont")

# Modelo efectos aleatorios

fm1 <- lme(distance ~ age, data = Orthodont) # random is ~ age

summary(fm1)## Linear mixed-effects model fit by REML

## Data: Orthodont

## AIC BIC logLik

## 454.6367 470.6173 -221.3183

##

## Random effects:

## Formula: ~age | Subject

## Structure: General positive-definite

## StdDev Corr

## (Intercept) 2.3270339 (Intr)

## age 0.2264276 -0.609

## Residual 1.3100399

##

## Fixed effects: distance ~ age

## Value Std.Error DF t-value p-value

## (Intercept) 16.761111 0.7752461 80 21.620375 0

## age 0.660185 0.0712533 80 9.265334 0

## Correlation:

## (Intr)

## age -0.848

##

## Standardized Within-Group Residuals:

## Min Q1 Med Q3 Max

## -3.223106016 -0.493760867 0.007316632 0.472151090 3.916032742

##

## Number of Observations: 108

## Number of Groups: 27# Modelo Mixto

fm2 <- lme(distance ~ age + Sex, data = Orthodont, random = ~ 1)

summary(fm2)## Linear mixed-effects model fit by REML

## Data: Orthodont

## AIC BIC logLik

## 447.5125 460.7823 -218.7563

##

## Random effects:

## Formula: ~1 | Subject

## (Intercept) Residual

## StdDev: 1.807425 1.431592

##

## Fixed effects: distance ~ age + Sex

## Value Std.Error DF t-value p-value

## (Intercept) 17.706713 0.8339225 80 21.233044 0.0000

## age 0.660185 0.0616059 80 10.716263 0.0000

## SexFemale -2.321023 0.7614168 25 -3.048294 0.0054

## Correlation:

## (Intr) age

## age -0.813

## SexFemale -0.372 0.000

##

## Standardized Within-Group Residuals:

## Min Q1 Med Q3 Max

## -3.74889609 -0.55034466 -0.02516628 0.45341781 3.65746539

##

## Number of Observations: 108

## Number of Groups: 275.4 Modelos ANCOVA

Los modelos ANCOVA son modelos ANOVA que incluyen ademas de las variables cualitativas o categóricas, variables cuantitativas entre las variables dependientes.

En determinadas ocasiones, en lugar de disponer de un factor bloque se tiene en su lugar una variable cuantitativa. Esta variable, si no está controlada por el investigador, se ha de incluir en el modelo con el fin de eliminar el efecto que pudiera tener sobre la estimación de los niveles del factor principal. Las variables explicativas cuantitativas se denominan covariables.

Partiendo de la especificación de un modelo ANOVA de un factor con dos niveles, al introducir la variable explicativa cuantitativa, \(X_i\), tendríamos:

\[ Y_i=\mu_1 D_{1i} + \mu_2 D_{2i} +\beta_1 X_i+ u_i\]

o sus equivalentes:

\[ Y_i=\beta_0 + \mu_1 D_{1i} +\beta_1 X_i+ u_i\]

\[ Y_i=\beta_0 + \mu_2 D_{2i} +\beta_1 X_i+ u_i\]

Para el análisis del comportamiento de cada grupo respecto a la pendiente, habría que especificar los siguientes modelos ANCOVA:

\[ Y_i=\delta_1 D_{1i}X_i + \delta_2 D_{2i}X_i + u_i\]

\[ Y_i=\beta_0 +\beta_1 X_i+ \delta_1 D_{1i} X_i+ u_i\]

\[ Y_i=\beta_0 +\beta_1 X_i+ \delta_2 D_{2i} X_i+ u_i\]

En los modelos ANOVA y ANCOVA se pueden incluir distintas variables categóricas. Consideremos una categórica \(E\) con tres categorías (1,2,3):

\(E_{1i}\) que toma valor uno en los individuos pertenecientes a la categoría 1, y cero en los restantes

\(E_{2i}\) que toma valor uno en los individuos pertenecientes a la categoría 2, y cero en los restantes

\(E_{3i}\) que toma valor uno en los individuos pertenecientes a la categoría 3, y cero en los restantes.

Si bien a la hora de especificar el modelo hay que evitar los problemas de multicolinealidad entre todas las variables dummy incluidas y el término constante.

Una forma de evitar los problemas es no incluir alguna de las categorías en forma de variable dummy, y dejar que la constante recoja el efecto de la categoría no incluida.

Una especificación posible de este modelo ANCOVA sería entonces:

\[ Y_i=\beta_0 +\beta_1 X_i+ \mu_2 D_{2i} + \alpha_1 E_{1i} + \alpha_2 E_{2i} + \alpha_3 E_{3i} + u_i\]

Modelo

Desarrolamos a continuación el modelo más simple de ANCOVA, es decir, un factor y una covariable, que se supone relacionada linealmente con la variable dependiente:

\[y_{ij} = \mu + \alpha_i + \beta(x_{ij} - \bar x_{..})+u_{ij}\ \ \ i=1,.. L; j=1,...,n_i\] siendo \(\beta\) el coeficiente de la regresión lineal entre \(X\) e \(Y\). Las medias estimadas para los tratamientos bajo este modelo serían entonces:

\[\mu_i = \mu + \alpha_i + \beta( \bar x_{i.} - \bar x_{..})\]

Construyendo dos rectas de regresión con la misma pendiente, \(\beta\), pero con distinta ordenada en el origen \(\mu + \alpha_i\).

La diferencia con la media glogal \(\mu\) se descompone en dos elementos, el efecto del factor \(\alpha_i\) y el de la covariable \(\beta( \bar x_{i.} - \bar x_{..})\)

La hipóteis nula de este modelo será por tanto:

\[H_0: \beta = 0; \ \ \ \ \alpha _i = 0 \ \ \ \forall i \]

Los parámetros se estiman:

\[\hat \alpha_i = \bar y_{i.} - \bar y_{..} \ \ \ \ \ \hat \beta = \frac {S_{xy}} {S_x^2}\]

Y la descomsisición de la varibilidad \(VT\) será:

\[VT = \sum_{i=1}^L \sum_{j=1}^{n_i} (y_{ij} - \bar y_{..})^2 = \sum_{i=1}^L n_i(\bar y_{i.} - \bar y_{..})^2 + \sum_{i=1}^L \sum_{j=1}^{n_i} [\hat\beta(x_{ij} - \bar x_{..})]^2+VNE\]

Luego la variabilidad explicada por el factor será:

\[VE_A = \sum_{i=1}^L n_i(\bar y_{i.} - \bar y_{..})^2 = \sum_{i=1}^L n_i\hat \alpha_i^2\]

La variabilidad explicada por la covariable será entonces:

\[VE_{XxY} = \hat\beta^2 \sum_{i=1}^L \sum_{j=1}^{n_i} (x_{ij} - \bar x_{..})^2 = \frac {[\sum_{i=1}^L\sum_{j=1}^{n_i} (x_{ij} - \bar x_{..}) (y_{ij} - \bar y_{..})]^2} {\sum_{i=1}^L \sum_{j=1}^{n_i} (x_{ij} - \bar x_{..})^2}\]

y la variabilidad no expicada:

\[VNE = \sum_{i=1}^L \sum_{j=1}^{n_i} (y_{ij}-\bar y_{i.} + \hat\beta(x_{ij} - \bar x_{..}))^2 \]

donde como vemos, puede descomponerse en aquella proveniente del factor y la asociada a la covariable.

Tabla ANOVA

La tabla ANOVA quedaría como sigue:

Tabla nº 4. Tabla ANOVA. Modelo con un factor y una covabiable

| Fuente de variación | Suma de cuadrados | Grados de libertad | Cuadrado medio | Estadistico \(F\) |

|---|---|---|---|---|

| Factor A | \(VE_A\) | \(L-1\) | \(MCF_A=\frac{VE_A}{L-1}\) | \(F=\frac{MCF_A}{MCR}\) |

| Covariable | \(VE_{XxY}\) | \(1\) | \(MCF_{XxY}=\frac{VE_{XxY}^2}{VE_X}\) | \(F=\frac{MCF_{XxY}}{MCR}\) |

| Error o residual | \(VNE\) | \(n-L-1\) | \(MCR=\frac{VNE}{n-L-1}\) | |

| Total | \(VT\) | \(n-1\) | \(MCT=\frac {VT}{n-1}\) |

Podemos tener más de un factor y/o covariable,e incluso plantear efecto interacción entre un factor y una covariable, obteniendo en este caso dos rectas con distinta ordenada en el origen y distinta pendiente. Hay que tener en cuenta también las hipótesis del modelo sobre los residuos, la selección de variables, etc.

Tomando como covariable la variable peso (wt), en miles de libras, obtenemos de nuevo como resultado un contraste no significativo para el efecto del factor tipo de transmisión. Esta corrección es efectiva gracias a la relación existente entre el peso de los vehículos y el consumo de combustible, pues lógicamente a mayor peso, menos millas recorridas por galón de combustible.

lnmpg <- log(mtcars$mpg)

amf <- as.factor(mtcars$am)

modelo.lm <- lm(lnmpg~amf+mtcars$wt)

summary(modelo.lm)##

## Call:

## lm(formula = lnmpg ~ amf + mtcars$wt)

##

## Residuals:

## Min 1Q Median 3Q Max

## -0.21351 -0.08281 0.00304 0.04962 0.32349

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) 3.89834 0.13567 28.734 < 2e-16 ***

## amf1 -0.04307 0.06865 -0.627 0.535

## mtcars$wt -0.28699 0.03501 -8.198 4.87e-09 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 0.1376 on 29 degrees of freedom

## Multiple R-squared: 0.8003, Adjusted R-squared: 0.7865

## F-statistic: 58.1 on 2 and 29 DF, p-value: 7.186e-11Otros modelos ANCOVA podrían ser:

##

## Call:

## lm(formula = mpg ~ 0 + as.factor(am) + wt, data = mtcars)

##

## Residuals:

## Min 1Q Median 3Q Max

## -4.5295 -2.3619 -0.1317 1.4025 6.8782

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## as.factor(am)0 37.3216 3.0546 12.218 5.84e-13 ***

## as.factor(am)1 37.2979 2.0857 17.883 < 2e-16 ***

## wt -5.3528 0.7882 -6.791 1.87e-07 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 3.098 on 29 degrees of freedom

## Multiple R-squared: 0.9802, Adjusted R-squared: 0.9781

## F-statistic: 478.1 on 3 and 29 DF, p-value: < 2.2e-16##

## Call:

## lm(formula = mpg ~ am + wt, data = mtcars)

##

## Residuals:

## Min 1Q Median 3Q Max

## -4.5295 -2.3619 -0.1317 1.4025 6.8782

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) 37.32155 3.05464 12.218 5.84e-13 ***

## am -0.02362 1.54565 -0.015 0.988

## wt -5.35281 0.78824 -6.791 1.87e-07 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 3.098 on 29 degrees of freedom

## Multiple R-squared: 0.7528, Adjusted R-squared: 0.7358

## F-statistic: 44.17 on 2 and 29 DF, p-value: 1.579e-09##

## Call:

## lm(formula = mpg ~ am + wt + wt * am, data = mtcars)

##

## Residuals:

## Min 1Q Median 3Q Max

## -3.6004 -1.5446 -0.5325 0.9012 6.0909

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) 31.4161 3.0201 10.402 4.00e-11 ***

## am 14.8784 4.2640 3.489 0.00162 **

## wt -3.7859 0.7856 -4.819 4.55e-05 ***

## am:wt -5.2984 1.4447 -3.667 0.00102 **

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 2.591 on 28 degrees of freedom

## Multiple R-squared: 0.833, Adjusted R-squared: 0.8151

## F-statistic: 46.57 on 3 and 28 DF, p-value: 5.209e-11##

## Call:

## lm(formula = mpg ~ 0 + as.factor(am) + as.factor(gear) + wt,

## data = mtcars)

##

## Residuals:

## Min 1Q Median 3Q Max

## -3.5798 -2.4056 -0.3692 1.8198 5.7713

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## as.factor(am)0 35.0955 3.1862 11.015 1.72e-11 ***

## as.factor(am)1 35.2838 3.0091 11.726 4.20e-12 ***

## as.factor(gear)4 2.0769 1.7343 1.198 0.242

## as.factor(gear)5 -1.0615 2.3845 -0.445 0.660

## wt -4.8782 0.7945 -6.140 1.46e-06 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 2.968 on 27 degrees of freedom

## Multiple R-squared: 0.9831, Adjusted R-squared: 0.9799

## F-statistic: 313.4 on 5 and 27 DF, p-value: < 2.2e-16La función R “lm”, presenta siempre una especificación que evita la multicolinealidad perfecta.

Realizar ejercicio libre con base de datos “npk”.

## 'data.frame': 24 obs. of 5 variables:

## $ block: Factor w/ 6 levels "1","2","3","4",..: 1 1 1 1 2 2 2 2 3 3 ...

## $ N : Factor w/ 2 levels "0","1": 1 2 1 2 2 2 1 1 1 2 ...

## $ P : Factor w/ 2 levels "0","1": 2 2 1 1 1 2 1 2 2 2 ...

## $ K : Factor w/ 2 levels "0","1": 2 1 1 2 1 2 2 1 1 2 ...

## $ yield: num 49.5 62.8 46.8 57 59.8 58.5 55.5 56 62.8 55.8 ...5.5 Modelo Lineal Generalizado

5.5.1 Formulación general

Los modelos lineales (regresión, ANOVA, ANCOVA), se basan en los siguientes supuestos:

Los errores se distribuyen normalmente.

La varianza es constante.

La variable dependiente se relaciona linealmente con las variables independientes.

De manera analítica tendríamos: \[Y_i=\beta_0 + \beta_1X_{1i}+\beta_2X_{2i}+...+\beta_kX_{ki}+u_i,\ \ \ \ i=1,2,…, n\]

donde \(e_i\) esta distribuida de cómo una normal de media cero, varianza constante (homocedástica),y donde la covarianza entre \(e_i\) y \(e_j\) es nula para \(e_i\neq e_j\) (ausencia de autocorrelación). Es decir, estos supuestos llevan implícito que la distribución de la variable dependiente \(Y_i\) sea también una normal \(Y_i\sim(\mu,\sigma^2)\), donde \(\mu=\beta_0+\beta_1 \bar X_1+\beta_2 \bar X_2+...+\beta_k \bar X_k\).

En muchas ocasiones, sin embargo, nos encontramos con que uno o varios de estos supuestos no se cumplen por la naturaleza de la información. En algunos casos, estos problemas se pueden llegar a solucionar mediante la transformación de la variable respuesta (por ejemplo tomando logaritmos). Sin embargo estas transformaciones no siempre consiguen corregir la falta de normalidad, la heterocedasticidad (varianza no constante) o la no linealidad de nuestros datos.

Una alternativa a la transformación de la variable dependiente/respuesta y a la falta de normalidad es el uso de los modelos lineales generalizados (MLG).

Los MLG fueron formulados por John Nelder y Robert Wedderburn (1989) como una manera de unificar varios modelos estadísticos, incluyendo la regresión lineal, regresión logística y regresión de Poisson, bajo un solo marco teórico.

Los MLG son, por tanto, una extensión de los modelos lineales que permiten utilizar distribuciones no normales de los errores (binomiales, Poisson, gamma, etc) y varianzas no constantes.

Los MLG permiten especificar distintos tipos de distribución de errores. Cayuela (2010) expone los siguientes ejemplos:

Poisson, muy útiles para conteos de acontecimientos, por ejemplo: número de heridos por accidentes de tráfico; número de hogares asegurados que dan parte de siniestro al día.

Binomiales, de gran utilidad para proporciones y datos de presencia/ausencia, por ejemplo: tasas de mortalidad; tasas de infección; porcentaje de siniestros mortales.

Gamma, muy útiles con datos que muestran un coeficiente de variación constante, esto es, en donde la varianza aumenta según aumenta la media de la muestra de manera constante, por ejemplo: número de heridos en función del número de siniestros.

Exponencial, muy útiles para los análisis de supervivencia.

Otra razón por la que un modelo lineal puede no ser adecuado para describir un fenómeno determinado es que la relación entre la variable respuesta y las variables independientes no es siempre lineal.

La función de vínculo se encarga de linealizar la relación entre la variable dependiente y las variables independientes mediante la transformación de la variable respuesta:

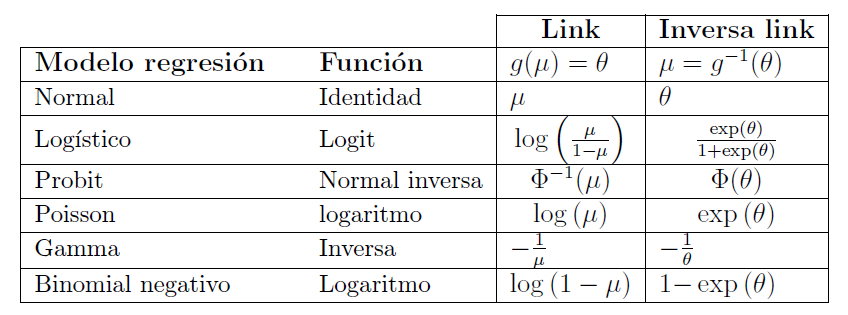

Tabla nº 5. Funciones de ligadura-vínculo más usadas

| Función Vínculo | Formula | Uso |

|---|---|---|

| Identidad | \(\mu\) | Datos continuos con errores normales (regresión y ANOVA) |

| Logaritmica | \(log(\mu)\) | Conteos con errores de tipo de Poisson |

| Logit | \(log(\frac{\mu}{n-\mu})\) | Proporciones (datos entre O y 1) con errores binomiales |

| Recíproca | \(\frac{1}{\mu}\) | Datos continuos con errores Gamma |

| Cuadrada | \(\sqrt{\mu}\) | Conteos |

| Exponencial | \(\mu^n\) | Funciones de potencia |

Fuente: (Cayuela, 2016)

Tabla nº 6. Modelos MLG más comunes

| Tipo de análisis | Variable respuesta | Variable explicativa | Función vínculo | Distribución de errores |

|---|---|---|---|---|

| Regresión | Continua | Continua | Identidad | Normal |

| ANOVA | Continua | Factor | Identidad | Normal |

| Regresión | Continua | Continua | Identidad | Gamma |

| Regresión | Conteo | Continua | Recíproca | Poisson |

| Tabla de contingencia | Conteo | Factor | Logarítmica | Poisson |

| Proporciones | Proporción | Continua | Logarítmica | Binomial |

| Regresión logística | Binaria | Continua | Logit | Binomial |

| Análisis de superviviencia | Tiempo | Recíproca | Identidad | Exponencial |

Fuente: (Cayuela, 2016)

La estimación de los parámetros \(\beta\) se realiza por máximo verosimilitud, y los ajustes de \(\hat \mu_i\) se calculan como \(g^{-1}(x'_i\beta)\), una vez estimados los parámetros del vector \(\beta\).

La especificación de un MLG se realiza en tres partes:

La componente aleatoria correspondiente a la variable \(Y_i\) que sigue una distribución de la familia exponencial (normal, log-normal, poisson, gamma,…)

La componente sistemática, o predictor, que se denota \(\eta\) y corresponde al vector de \(n\) componentes \(\eta_i=\beta_0 + \beta_1X_{1i} + \beta_2X_{2i}+...+\beta_kX_{ki}\)

La función de ligadura (o función link \(g(•)\)) que relaciona la esperanza matemática de la variable con el predictor lineal \(\eta_i=g(\mu_i)\), que debe de ser monótona y diferenciable.

5.5.2 Modelos con variables cualitativas endógenas

5.5.2.1 Modelo probabilístico lineal

El modelo de probabilidad lineal se caracteriza por tener la variable endógena Y dicotómica o binaria, es decir toma el valor \(Y_i=1\) si un determinado suceso ocurre y el valor \(Y_i=0\) en caso contrario. Estos modelos están muy extendidos en el análisis estadístico pero encuentran una difícil aplicación en Economía debido a las dificultades de interpretación económica de los resultados que ofrecen este tipo de investigaciones. A este respecto, hay que considerar que estos modelos lo que realmente investigan es la probabilidad de que se dé una opción (valores \(Y_i=1\)) o no se dé (\(Y_i=0\)).

A pesar del carácter dicotómico de la variable endógena, el modelo de probabilidad lineal se especifica de la forma habitual, teniendo presente que las variables exógenas no son dicotómicas sino continuas:

\[ Y_i=\beta_0 + \beta_1 X_i + e_i\]

De acuerdo con esta expresión, y dado el hecho de que la variable endógena tome valores discretos (1 ó 0), el término de perturbación \(e_i\), puede tomar también dos valores únicamente:

Si \(Y_i=0 \Rightarrow e_i=-\beta_0 - \beta_1X_i\) con probabilidad \(p\).

Si \(Y_i=1 \Rightarrow e_i=1- \beta_0 - \beta_1X_i\) con probabilidad \((1-p)\).

Dado que la esperanza del término de error ha de ser nula \(E(e_i)=0\), entonces se demuestra que \(p=1-\beta_0 - \beta_1X_i\) y \((1-p) = \beta_0 + \beta_1X_i\), lo que permite evaluar la probabilidad de que la variable endógena tome el valor correspondiente:

\(Prob (Y_i=0) = Prob (e_i=-\beta_0 - \beta_1X_i=p=1-\beta_0 - \beta_1X_i\).

\(Prob (Y_i=1) = Prob (e_i=1-\beta_0 - \beta_1X_i=(1-p)=\beta_0 + \beta_1X_i\).

A su vez, la varianza del término de perturbación se calcularía a partir de:

\[Var(e_i)=p(1-p)=(1-\beta_0 - \beta_1X_i)(\beta_0 + \beta_1X_i)\]

Una problemática inherente a los estimadores MCO de estos modelos es la siguiente:

La perturbación aleatoria \(e_i\) no sigue una distribución Normal. Es sencillo observar este hecho ya que el carácter binario (1 ó 0) de la variable endógena afecta a la distribución de la perturbación, teniendo ésta una distribución Binomial. Este problema se atenúa cuando se utilizan tamaños de muestra (\(N\)) grandes en donde la distribución Binomial es susceptible de aproximarse a una Normal.

La perturbación aleatoria no tiene una varianza constante (es heteroscedástica), lo cual supone una falta de eficiencia. Para solucionarlo habría que realizar transformaciones que nos diesen una perturbación homocedástica; esta transformación consiste en multiplicar todas las variables por una cierta cantidad que elimine el problema de la heteroscedasticidad. Dicha cantidad es:

\[\frac{1}{\sqrt{(1-\hat\beta_0 - \hat\beta_1X_i)(\hat\beta_0 + \hat\beta_1X_i)}}\]

siendo \(\hat\beta_0\) y \(\hat\beta_1\) los estimaciones MCO del modelo.

- No obstante, el mayor problema que plantean estos modelos es que las predicciones realizadas sobre la variable endógena no siempre se encuentran en el intervalo [0,1], ya que pueden ser menores que cero y mayores que uno. Este problema tiene dos soluciones, una es tomar como valor cero todas las estimaciones de la variable endógena con valores negativos, y uno cuando estas resulten mayores que uno; la segunda solución es utilizar funciones de distribución que estén acotadas entre cero y uno como son la Logística y la Normal; de éstas se derivan los modelos Logit y Probit que pasamos a ver a continuación.

5.5.2.2 Modelo Logit

Planteamiento del modelo

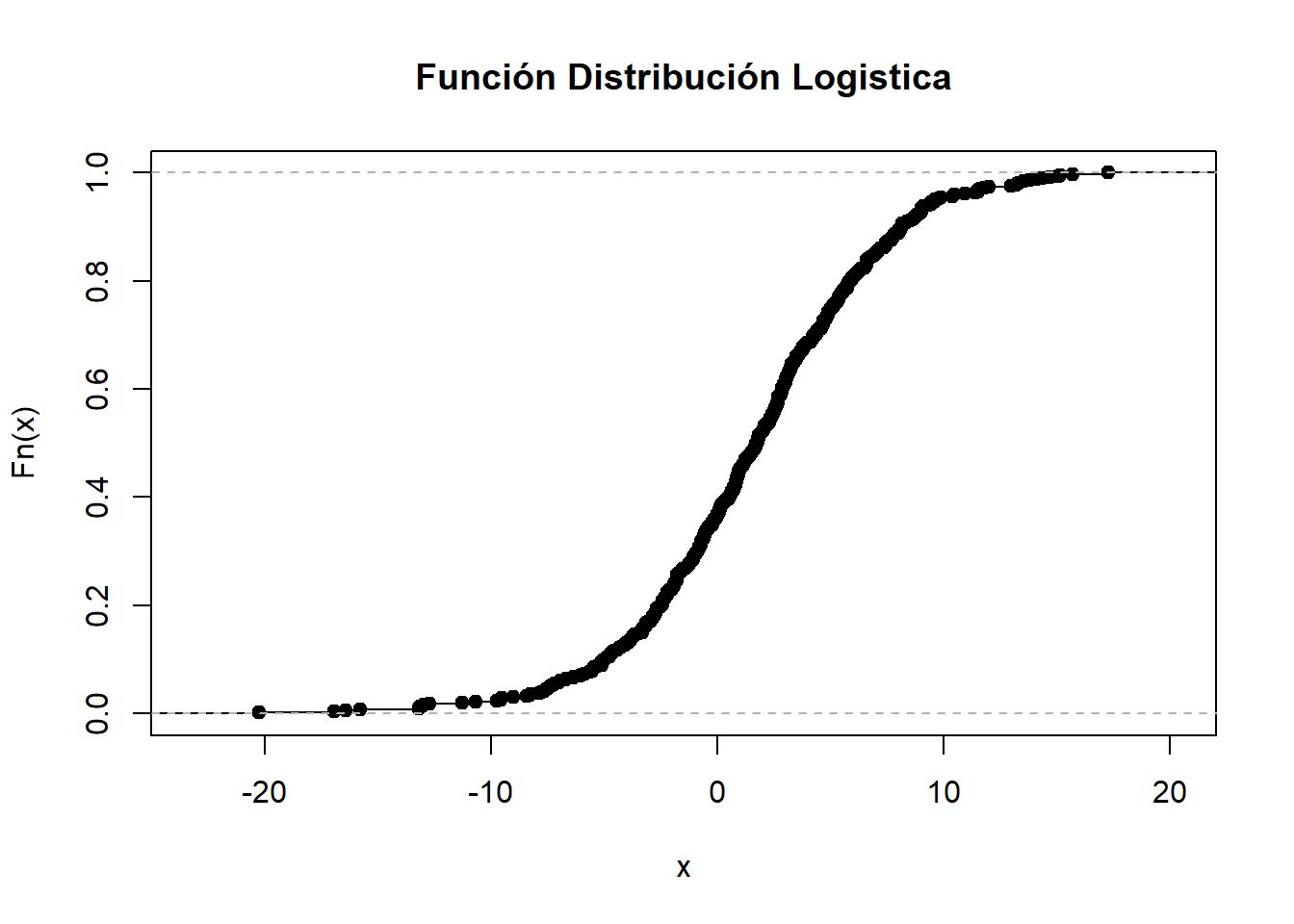

El problema que presentan los modelos probabilísticos lineales en cuanto a la existencia de predicciones establecidas fuera de rango (negativas o mayores que uno), es debido a que utilizan una función de probabilidad que depende linealmente de las variables explicativas (\(X_i\)), que se resolverían acotando dicha distribución de probabilidad. El modelo Logit en concreto utiliza, para ello, la función de distribución logística:

Debido a que la función de distribución logística no tiene forma lineal, el modelo Logit se estima de forma diferente, así en vez de minimizar las sumas de las diferencias al cuadrado entre los valores observados y los estimados por el modelo, el carácter no lineal de los modelos Logit requiere la utilización del método de Máxima Verosimilitud para ser estimado, maximizando la verosimilitud de que un suceso tenga lugar, aunque se podría estimar por MCO mediante una transformación logarítmica de los datos (Gujarati, 1997).

La probabilidad de que \(Y_i=0\) (\(p_i\)) se define ahora mediante la siguiente expresión:

\[p_i=\frac{1}{1+e^{-z_i}}\]

donde \(z_i=\beta_0 + \sum_j\beta_jX_{ji}\).

La probabilidad de que \(Y_i=1\) (\(1-p_i\)) sería:

\[1-p_i=\frac{1}{1+e^{z_i}}\]

En consecuencia, la razón entre ambas será igual a:

\[\frac{p_i}{1-p_i}=\frac{1+e^{z_i}}{1+e^{-z_i}}=e^{z_i}\]

Tomando el logaritmo de la expresión anterior se obtiene:

\[L_i=log(\frac{p_i}{1-p_i})=log(e^{z_i})=\beta_0 + \sum_{j=1}^k\beta_jX_{ji}+u_i\]

donde \(L_i\) es denominado Logit.

Los coeficientes \(\beta\) indican el cambio en el Logit causado por el cambio en una unidad en el valor de \(X_i\), mientras que los \(e^{\beta}\) definen el cambio en la razón de probabilidades \(\frac{p}{1-p}\) causado por el cambio en una unidad en el valor de \(X_i\). Si \(\beta\) es positivo,\(e^{\beta}\) será mayor que 1, es decir, \(\frac{p}{1-p}\) se incrementará; si \(\beta\) es negativo, \(e^{\beta}\) será menor que 1, y \(\frac{p}{1-p}\) disminuirá. Adicionalmente, puede demostrarse que el cambio en la probabilidad (\(p\)) causado por el cambio en una unidad en el valor de \(X_i\) es \(\beta(\frac{p}{1-p})\), es decir, depende no sólo del coeficiente, sino también del nivel de probabilidad a partir del cual se mide el cambio.

A la hora de estimar un modelo Logit, hay que tener presente que además de los valores \(X_i\), se necesitan los valores del Logit (\(L_i\)). Por otro lado, la estimación de los coeficientes del modelo ha de realizarse utilizando el método de Máxima Verosimilitud, a través del algoritmo de Newton-Raphson, es decir, eligiendo como estimadores de los coeficientes a aquellos que maximizan la función de verosimilitud, construida sobre la base de \(p=\frac{1}{1+e^{-z}}\). Pero si tenemos la posibilidad de agrupar los datos individuales, entonces podría estimarse el modelo por MCO.

Contrastes sobre los parámetros

Para evaluar si cada variable individualmente contribuye significativamente al modelo se utiliza el estadístico de Wald, definido como el cociente entre el valor del parámetro estimado al cuadrado dividido entre su varianza:

\[W(\beta_j) = \frac{\hat\beta_j^2}{Var(\hat\beta_j)}\]

Este estadístico, bajo la hipótesis nula \(H_0:\beta_j=0\), se distribuye como una Chi-Cuadrado con un grado de libertad. Una estimación adecuada de \(Var(\hat\beta_j)\) se puede obtener a través del inverso de la información de Fisher del parámetro.

Leemos base de datos de prestamos fallidos al consumo:

library(ISLR)

str(Default) ## 'data.frame': 10000 obs. of 4 variables:

## $ default: Factor w/ 2 levels "No","Yes": 1 1 1 1 1 1 1 1 1 1 ...

## $ student: Factor w/ 2 levels "No","Yes": 1 2 1 1 1 2 1 2 1 1 ...

## $ balance: num 730 817 1074 529 786 ...

## $ income : num 44362 12106 31767 35704 38463 ...La variable dependiente será default, \(Y=YES\) e \(Y=No\).

# Frecuencias variable respuesta

table(Default$default)##

## No Yes

## 9667 333# Frecuencias relativas variable respuesta

prop.table(table(Default$default))##

## No Yes

## 0.9667 0.0333Tenemos entonces tres variables predictivas: student, que caracteriza al consumidor como estudiante; balance, que es el saldo promedio de la tarjeta de crédito, e income que la renta del cliente.

Estimamos un modelo logit para explicar la admisión de alumnos, y evaluamos la tasa de acierto:

# Regresion logistica

mylogit=glm(default~student+balance+income,family="binomial",data=Default)

summary(mylogit) ##

## Call:

## glm(formula = default ~ student + balance + income, family = "binomial",

## data = Default)

##

## Deviance Residuals:

## Min 1Q Median 3Q Max

## -2.4691 -0.1418 -0.0557 -0.0203 3.7383

##

## Coefficients:

## Estimate Std. Error z value Pr(>|z|)

## (Intercept) -1.087e+01 4.923e-01 -22.080 < 2e-16 ***

## studentYes -6.468e-01 2.363e-01 -2.738 0.00619 **

## balance 5.737e-03 2.319e-04 24.738 < 2e-16 ***

## income 3.033e-06 8.203e-06 0.370 0.71152

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## (Dispersion parameter for binomial family taken to be 1)

##

## Null deviance: 2920.6 on 9999 degrees of freedom

## Residual deviance: 1571.5 on 9996 degrees of freedom

## AIC: 1579.5

##

## Number of Fisher Scoring iterations: 8summary(mylogit$fitted.values)## Min. 1st Qu. Median Mean 3rd Qu. Max.

## 0.0000103 0.0002798 0.0019662 0.0333000 0.0132244 0.9776263# Tabla de clasificación Predichos * Observados

fit.pred=ifelse(mylogit$fitted.values>0.5,1,0)

table(fit.pred,Default$default)##

## fit.pred No Yes

## 0 9627 228

## 1 40 1055.5.2.3 Modelo Probit

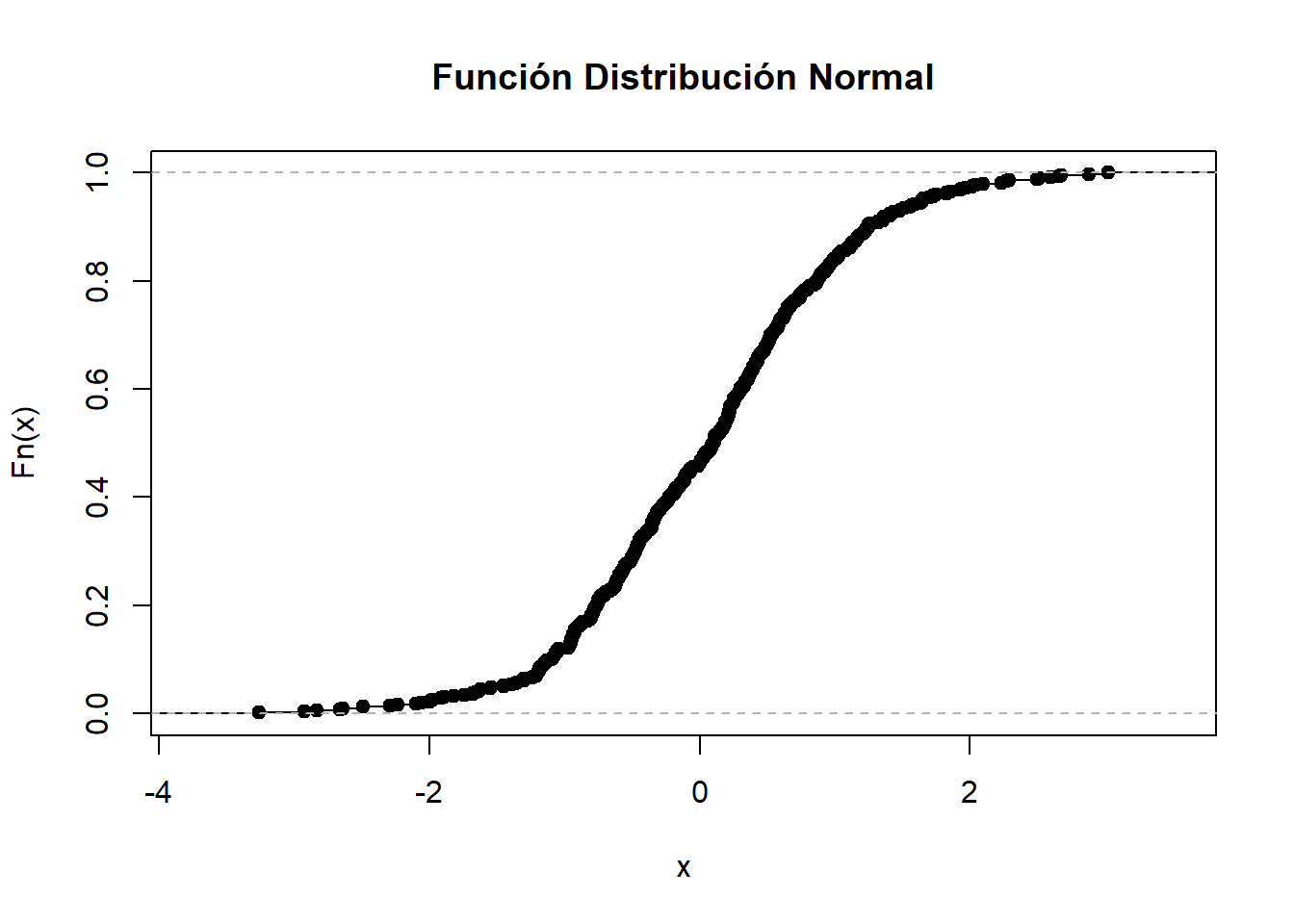

Mientras que el modelo Logit utiliza la función de distribución logística para acotar la distribución de probabilidad en el modelo de probabilidad lineal, el modelo Probit utiliza la función de distribución Normal.

Las funciones de distribución normal y logística son muy semejantes; la diferencia principal es que la función de distribución normal se acerca más rápidamente a los ejes que la logística.

Para entender la filosofía del modelo Probit, vamos a suponer que existe una variable desconocida \(s\) que cumple lo siguiente:

Si \(I_i=\beta_0+\sum_j\beta_jX_{ji} \geq s\) entonces \(Y_i=1\)

Si \(I_i=\beta_0+\sum_j\beta_jX_{ji}<s\) entonces \(Y_i=0\)

Dado el supuesto de normalidad en un suceso, la probabilidad de que este sea menor o igual al valor (\(s\)), se calcula a partir de la función de distribución acumulada de una distribución Normal estandarizada, esto es, con esperanza cero y desviación típica uno.

\[pr(Y_i=1)=pr(I^*_i\geq I_i)=pr(\beta_0+\sum_{j=1}^k\beta_jX_{ji} \geq s)=F(\beta_0+\sum_{j=1}^k\beta_jX_{ji})\]

\(F\) es la FDA normal estandar:

\[F(I_i)=\frac{1}{\sqrt{2\pi}}\int_{- \infty}^{\beta_0+\sum_j\beta_jX_{ji}}{e^{-\frac{z^2}{2}d(z)}}\]

donde \(Z\) es la variable normal estandarizada \(Z \sim N(0,\sigma^2)\)

Lo anterior equivale a que la relación entre la endógena y las explicativas venga dada por la siguiente expresión:

\[y_i=F(I_i=\beta_0+\sum_{j=1}^k\beta_jX_{ji})+u_i => y_i=\frac{1}{\sqrt{2\pi}}\int_{- \infty}^{\beta_0+\sum_j\beta_jX_{ji}}{e^{-\frac{z^2}{2}d(z)}}+u_i\]

Ahora para obtener información sobre \(I_i\), se toma la inversa de \(F(I_i)\):

\[I_i=F^{-1}(I_i)=F^{-1}(P)=\beta_0+\sum_{j=1}^k\beta_jX_{ji}\]

Donde \(I_i\) es negativa siempre que \(p_i<0.5\); en la práctica se agrega el número 5 a \(I_i\) y a su resultado se le denomina Probit. Es decir, \(Probit=5+I_i\).

El término de la perturbación es no obstante heteroscedástico. Gujarati (1999) sugiere que se realice la transformación comentada en el apartado 1.3.2.1 (análisis de la varianza de un factor), para que el modelo transformado sea homocedástico.

Al igual que ocurre en el logit, si tenemos la posibilidad de agrupar los datos individuales, entonces podría estimarse el modelo por MCO.

La estimación en R del modelo probit estimado en el ejemplo anterior se programa:

# Regresion logistica

mylogit=glm(default~student+balance+income,family="binomial"(link=probit),data=Default)

summary(mylogit) ##

## Call:

## glm(formula = default ~ student + balance + income, family = binomial(link = probit),

## data = Default)

##

## Deviance Residuals:

## Min 1Q Median 3Q Max

## -2.2226 -0.1354 -0.0321 -0.0044 4.1254

##

## Coefficients:

## Estimate Std. Error z value Pr(>|z|)

## (Intercept) -5.475e+00 2.385e-01 -22.960 <2e-16 ***

## studentYes -2.960e-01 1.188e-01 -2.491 0.0127 *

## balance 2.821e-03 1.139e-04 24.774 <2e-16 ***

## income 2.101e-06 4.121e-06 0.510 0.6101

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## (Dispersion parameter for binomial family taken to be 1)

##

## Null deviance: 2920.6 on 9999 degrees of freedom

## Residual deviance: 1583.2 on 9996 degrees of freedom

## AIC: 1591.2

##

## Number of Fisher Scoring iterations: 8summary(mylogit$fitted.values)## Min. 1st Qu. Median Mean 3rd Qu. Max.

## 0.0000000 0.0000183 0.0007723 0.0334850 0.0130713 0.9609657# Tabla de clasificación Predichos * Observados

fit.pred=ifelse(mylogit$fitted.values>0.5,1,0)

table(fit.pred,Default$default)##

## fit.pred No Yes

## 0 9639 238

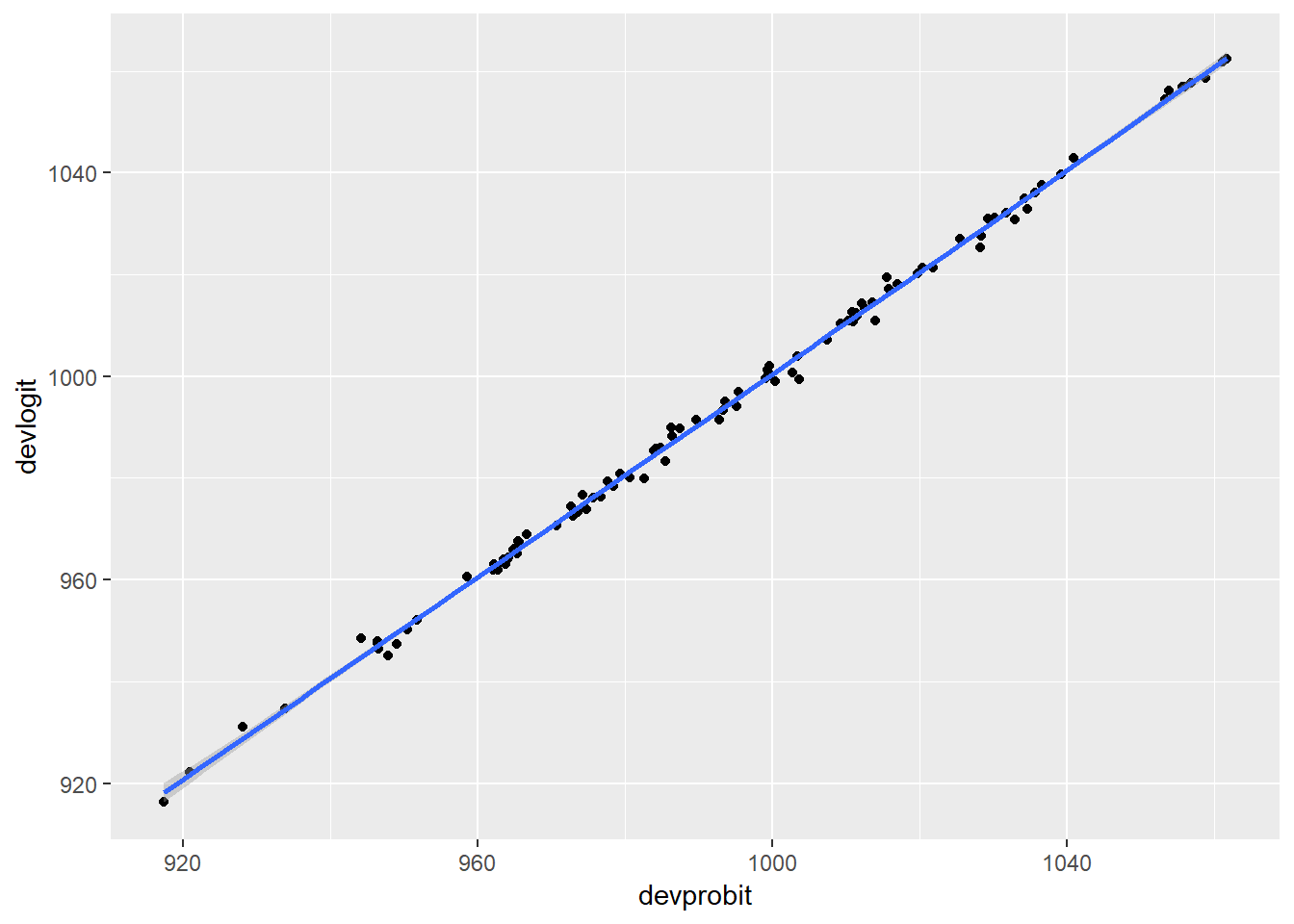

## 1 28 955.5.2.4 Modelo Logit vs Modelo Probit

Desde un punto de vista teórico, si se plantean las covariables como directamente relacionadas con la probabilidad de éxito, entonces normalmente se elegiría la Regresión Logística, porque es el enlace canónico.

Si el resultado binario depende de una variable Gaussiana oculta parece razonable optar a priori, por razones teóricas. por el modelo Probit. Consideremos el siguiente ejemplo: se plantea la realización de un modelo de presión arterial alta como una función de algunas covariables. Parece razonable la asunción de que la presión arterial en sí misma se distribuya normalmente en la población, pero sin embargo, los médicos la dicotomizaron durante el estudio (es decir, sólo se registró como “alta” o “normal”).

Otra consideración es que tanto logit como probit son simétricos. Si se piensa que la probabilidad de éxito sube lentamente de cero, pero luego disminuye más rápidamente cuando se acerca a uno, sería preferible optar por una función vínculo tipo CLogLog, la cual se define como:

\[y=CLogLog(x)=ln(-ln(1-x)) => x=CLogLog^{-1}(y)=1-e^{-e^y}\]