Capitulo 4 Analisis de Datos

4.1 Reglas de Asociacion

4.1.1 Anotaciones

Notación en market basket analysis

- Datos: Típicamente una matriz binaria D dispersa de tamaño muy grande.

- Item: Cada columna del dataset. Un dato del dataset que puede ser un atributo, una palabra, un documento, un biomarcador, etc.

- Transacción: Cada fila del dataset, representando típicamente un producto.

- Itemset: Una colección de cero o más items.

Minería de Reglas de Asociación

- Confianza: Una medida de la incertidumbre del patrón descubierto.

- Soporte: Una medida de en qué porcentaje el patrón encontrado aparece respecto al tamaño del dataset.

- Frequent itemset: Establecer un umbral respecto al soporte que debe satisfacer el itemset encontrado.

- Strong Association rules: Reglas que satisfacen umbrales de soporte y de confianza.

Extracción de Reglas

El numero de posibles reglas con d atributos es: \(numreglas = 3^d-2^{d+1}+1\)

Soporte: \(Sop(X) = \frac{\mid X\mid}{\mid D\mid}\) con \({\mid X\mid}\) número de filas con X y \({\mid D\mid}\) el número de filas de la tabla.

- El soporte denota la frecuencia de la regla en el dataset, \(P(X\cup Y)\).

- Un alto valor indica que la regla es cierta en gran parte de la base de datos.

- Un bajo valor indica una regla poco frecuente. Podríamos descartar las reglas con bajo soporte.

Confianza: \(Conf(X \rightarrow Y) = \frac{Sop(X \cup Y)}{Sop(X)} = \frac{\mid X \cup Y \mid}{\mid X\mid}\)

- La confianza es un estimador de la \(P(X/Y)\), es decir, el porcentaje del dataset que conteniendo X también contiene a Y.

- Es un indicador de la fiabilidad de la regla.

Lift: \(Lift(X \rightarrow Y) = \frac{Sop(X \cup Y)}{Sop(X)Sop(Y)}\) * X e Y están negativamente correlacionados si el valor es menor que 1. * Es simétrica: \(X \rightarrow Y, Y \rightarrow X\) tienen igual Lift.

Conviction \(Conv(X \rightarrow Y) = \frac{Sop(X)Sop(\overline Y)}{Sop(X \cup \overline Y)}\) * Conv valdrá 1 si los items X e Y no están relacionados.

Leverage - Piatetsky-Shapiro \(Lev(X \rightarrow Y) = Sop(X \cup Y)-Sop(X)Sop(Y)\)

4.1.2 Ejercicio diapositiva

# Este es el ejercicio que habia que realizar a mano. Esta aqui para comprobar el resultado.

library(arules)## Loading required package: Matrix##

## Attaching package: 'arules'## The following object is masked from 'package:dplyr':

##

## recode## The following objects are masked from 'package:base':

##

## abbreviate, writeds <- matrix(data = c(1,1,1,1,0,0,0,0,

1,0,0,0,1,1,1,0,

0,1,0,0,1,1,0,1,

1,1,1,0,1,1,0,0,

1,1,0,0,0,1,0,1,

1,1,0,1,1,1,0,0,

1,1,0,0,0,1,0,1),

nrow = 7,ncol = 8, byrow = TRUE)

colnames(ds) <- c("Pan", "Leche", "Patatas", "Mostaza", "Cerveza", "Pañales", "Huevos", "Cola")

rownames(ds) <- 1:7

reglas <- apriori(ds, parameter = list(supp = 0.6, conf = 0.80))## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.8 0.1 1 none FALSE TRUE 5 0.6 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 4

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[8 item(s), 7 transaction(s)] done [0.00s].

## sorting and recoding items ... [3 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 done [0.00s].

## writing ... [9 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].4.1.3 Ejemplo titanic diapositivas

## [1] "data.frame"## Class Sex Age Survived

## 1st :325 Female: 470 Adult:2092 No :1490

## 2nd :285 Male :1731 Child: 109 Yes: 711

## 3rd :706

## Crew:885## Class Sex Age Survived

## 1657 3rd Male Adult Yes

## 1784 Crew Male Adult Yes

## 518 3rd Male Adult No

## 2004 1st Female Adult Yes

## 180 2nd Male Adult Nolibrary(arules)

# el dataset es de tipo Transactions (binary o data.frame)

# las reglas generadas tienen siempre a la derecha 1 item

mis.reglas <- apriori(titanic.raw) ## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.8 0.1 1 none FALSE TRUE 5 0.1 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 220

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[10 item(s), 2201 transaction(s)] done [0.00s].

## sorting and recoding items ... [9 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 done [0.00s].

## writing ... [27 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].## lhs rhs support confidence

## [1] {} => {Age=Adult} 0.9504771 0.9504771

## [2] {Class=2nd} => {Age=Adult} 0.1185825 0.9157895

## [3] {Class=1st} => {Age=Adult} 0.1449341 0.9815385

## [4] {Sex=Female} => {Age=Adult} 0.1930940 0.9042553

## [5] {Class=3rd} => {Age=Adult} 0.2848705 0.8881020

## [6] {Survived=Yes} => {Age=Adult} 0.2971377 0.9198312

## [7] {Class=Crew} => {Sex=Male} 0.3916402 0.9740113

## [8] {Class=Crew} => {Age=Adult} 0.4020900 1.0000000

## [9] {Survived=No} => {Sex=Male} 0.6197183 0.9154362

## [10] {Survived=No} => {Age=Adult} 0.6533394 0.9651007

## [11] {Sex=Male} => {Age=Adult} 0.7573830 0.9630272

## [12] {Sex=Female,Survived=Yes} => {Age=Adult} 0.1435711 0.9186047

## [13] {Class=3rd,Sex=Male} => {Survived=No} 0.1917310 0.8274510

## [14] {Class=3rd,Survived=No} => {Age=Adult} 0.2162653 0.9015152

## [15] {Class=3rd,Sex=Male} => {Age=Adult} 0.2099046 0.9058824

## [16] {Sex=Male,Survived=Yes} => {Age=Adult} 0.1535666 0.9209809

## [17] {Class=Crew,Survived=No} => {Sex=Male} 0.3044071 0.9955423

## [18] {Class=Crew,Survived=No} => {Age=Adult} 0.3057701 1.0000000

## [19] {Class=Crew,Sex=Male} => {Age=Adult} 0.3916402 1.0000000

## [20] {Class=Crew,Age=Adult} => {Sex=Male} 0.3916402 0.9740113

## [21] {Sex=Male,Survived=No} => {Age=Adult} 0.6038164 0.9743402

## [22] {Age=Adult,Survived=No} => {Sex=Male} 0.6038164 0.9242003

## [23] {Class=3rd,Sex=Male,Survived=No} => {Age=Adult} 0.1758292 0.9170616

## [24] {Class=3rd,Age=Adult,Survived=No} => {Sex=Male} 0.1758292 0.8130252

## [25] {Class=3rd,Sex=Male,Age=Adult} => {Survived=No} 0.1758292 0.8376623

## [26] {Class=Crew,Sex=Male,Survived=No} => {Age=Adult} 0.3044071 1.0000000

## [27] {Class=Crew,Age=Adult,Survived=No} => {Sex=Male} 0.3044071 0.9955423

## lift count

## [1] 1.0000000 2092

## [2] 0.9635051 261

## [3] 1.0326798 319

## [4] 0.9513700 425

## [5] 0.9343750 627

## [6] 0.9677574 654

## [7] 1.2384742 862

## [8] 1.0521033 885

## [9] 1.1639949 1364

## [10] 1.0153856 1438

## [11] 1.0132040 1667

## [12] 0.9664669 316

## [13] 1.2222950 422

## [14] 0.9484870 476

## [15] 0.9530818 462

## [16] 0.9689670 338

## [17] 1.2658514 670

## [18] 1.0521033 673

## [19] 1.0521033 862

## [20] 1.2384742 862

## [21] 1.0251065 1329

## [22] 1.1751385 1329

## [23] 0.9648435 387

## [24] 1.0337773 387

## [25] 1.2373791 387

## [26] 1.0521033 670

## [27] 1.2658514 670## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 1 0.1 1 none FALSE TRUE 5 0.005 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 11

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[10 item(s), 2201 transaction(s)] done [0.00s].

## sorting and recoding items ... [10 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 done [0.00s].

## writing ... [18 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].## lhs rhs support confidence lift

## [1] {Class=Crew} => {Age=Adult} 0.40208996 1 1.052103

## [2] {Class=2nd,Age=Child} => {Survived=Yes} 0.01090413 1 3.095640

## [3] {Age=Child,Survived=No} => {Class=3rd} 0.02362562 1 3.117564

## [4] {Class=2nd,Survived=No} => {Age=Adult} 0.07587460 1 1.052103

## [5] {Class=1st,Survived=No} => {Age=Adult} 0.05542935 1 1.052103

## [6] {Class=Crew,Sex=Female} => {Age=Adult} 0.01044980 1 1.052103

## count

## [1] 885

## [2] 24

## [3] 52

## [4] 167

## [5] 122

## [6] 23# Solo extrae reglas con un atributo a la derecha

# con un valor concreto

mis.reglas3 <- apriori(titanic.raw,parameter = list(supp=0.005, conf=1), appearance = list(rhs=c("Survived=Yes"))) ## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 1 0.1 1 none FALSE TRUE 5 0.005 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 11

##

## set item appearances ...[1 item(s)] done [0.00s].

## set transactions ...[10 item(s), 2201 transaction(s)] done [0.00s].

## sorting and recoding items ... [10 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 done [0.00s].

## writing ... [2 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].## lhs rhs support confidence

## [1] {Class=2nd,Age=Child} => {Survived=Yes} 0.010904134 1

## [2] {Class=2nd,Sex=Female,Age=Child} => {Survived=Yes} 0.005906406 1

## lift count

## [1] 3.09564 24

## [2] 3.09564 13# MAS POSIBILIDADES

rules <- apriori(titanic.raw, control = list(verbose=F), parameter = list(minlen=3, supp=0.002, conf=0.2), appearance = list( rhs=c("Survived=Yes"), lhs=c("Class=1st", "Class=2nd", "Class=3rd", "Age=Child", "Age=Adult")))

rules.sorted <- sort(rules, by="confidence")

inspect(rules.sorted)## lhs rhs support confidence lift

## [1] {Class=2nd,Age=Child} => {Survived=Yes} 0.010904134 1.0000000 3.0956399

## [2] {Class=1st,Age=Child} => {Survived=Yes} 0.002726034 1.0000000 3.0956399

## [3] {Class=1st,Age=Adult} => {Survived=Yes} 0.089504771 0.6175549 1.9117275

## [4] {Class=2nd,Age=Adult} => {Survived=Yes} 0.042707860 0.3601533 1.1149048

## [5] {Class=3rd,Age=Child} => {Survived=Yes} 0.012267151 0.3417722 1.0580035

## [6] {Class=3rd,Age=Adult} => {Survived=Yes} 0.068605179 0.2408293 0.7455209

## count

## [1] 24

## [2] 6

## [3] 197

## [4] 94

## [5] 27

## [6] 1514.1.4 Ejercicio Soporte y Confianza

Trabajando con el paquete arules

- Objetivo y ejemplo de ejecución

## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 1 0.1 1 none FALSE TRUE 5 0.1 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 4884

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[115 item(s), 48842 transaction(s)] done [0.03s].

## sorting and recoding items ... [31 item(s)] done [0.01s].

## creating transaction tree ... done [0.02s].

## checking subsets of size 1 2 3 4 5 6 7 8 9 done [0.07s].

## writing ... [72 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].## lhs rhs support confidence lift count

## [1] {relationship=Husband,

## hours-per-week=Over-time,

## native-country=United-States} => {sex=Male} 0.1366447 1 1.495926 6674dado el dataset Adult del que se han generado reglas de asociación,

a reg1 por error le hemos borrado el soporte y la confianza

## support confidence lift count

## 10 0 0 1.495926 6674Escribir una función computer_suppport_confidence que dado un dataset y una regla de asociación obtenida a partir del dataset con el comando apriori, obtenga:

soporte(\(X \cup Y\)) (soporte de la unión de X e Y)

confianza(X -> Y)

Y estos valores calculados visto en en clase se almacenen en la regla.

La función tendría el siguiente formato:

computer_suppport_confidence <- function(Dataset, Rule1){

....

return(list( my.soporte=....., my.confidence=..... ))

}computer_suppport_confidence <- function(Dataset, Rule1){

vector_items <- unlist(as(items(Rule1), "list"))

vector_izq <- unlist(as(lhs(Rule1), "list"))

filtrado_transacciones_soporte <- subset(x = Dataset,

subset = items %ain% vector_items)

soporteXUY <- length(filtrado_transacciones_soporte)/length(Dataset)

filtrado_transacciones_confidence <- subset(x = Dataset,

subset = items %ain% vector_izq)

soporteX <- length(filtrado_transacciones_confidence)/length(Dataset)

confidence <- soporteXUY/soporteX

return(list( my.soporte=soporteXUY,

my.confidence=confidence))

}4.1.5 Ejercicio aleatorio de reglas de asociacion

library(arules)

data <- read.transactions("Groceries65")

reglas <- apriori(data, parameter = list(supp = 0.001, conf = 0.6))## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.6 0.1 1 none FALSE TRUE 5 0.001 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 6

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[169 item(s), 6393 transaction(s)] done [0.00s].

## sorting and recoding items ... [155 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 5 6 done [0.01s].

## writing ... [3756 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].## lhs rhs support confidence

## [1] {beef,pickled vegetables} => {other vegetables} 0.001720632 0.6470588

## lift count

## [1] 3.430056 11# Ordenamos las reglas por confianza

reglas <- sort(reglas, by = "confidence")

inspect(reglas[1:20])## lhs rhs support confidence lift count

## [1] {cereals,

## tropical fruit} => {whole milk} 0.001251369 1 3.917279 8

## [2] {house keeping products,

## napkins} => {whole milk} 0.001094948 1 3.917279 7

## [3] {rice,

## sugar} => {whole milk} 0.001407790 1 3.917279 9

## [4] {bottled water,

## rice} => {whole milk} 0.001094948 1 3.917279 7

## [5] {canned fish,

## hygiene articles} => {whole milk} 0.001407790 1 3.917279 9

## [6] {cat food,

## frozen vegetables} => {other vegetables} 0.001251369 1 5.300995 8

## [7] {liquor,

## red/blush wine,

## soda} => {bottled beer} 0.001251369 1 11.949533 8

## [8] {cereals,

## curd,

## yogurt} => {whole milk} 0.001094948 1 3.917279 7

## [9] {cereals,

## curd,

## whole milk} => {yogurt} 0.001094948 1 7.231900 7

## [10] {rice,

## root vegetables,

## yogurt} => {whole milk} 0.001407790 1 3.917279 9

## [11] {beef,

## mayonnaise,

## other vegetables} => {root vegetables} 0.001094948 1 9.265217 7

## [12] {dishes,

## root vegetables,

## whole milk} => {other vegetables} 0.001407790 1 5.300995 9

## [13] {brown bread,

## herbs,

## whole milk} => {other vegetables} 0.001094948 1 5.300995 7

## [14] {citrus fruit,

## herbs,

## tropical fruit} => {other vegetables} 0.001094948 1 5.300995 7

## [15] {beverages,

## tropical fruit,

## whipped/sour cream} => {other vegetables} 0.001094948 1 5.300995 7

## [16] {fruit/vegetable juice,

## root vegetables,

## semi-finished bread} => {whole milk} 0.001094948 1 3.917279 7

## [17] {curd,

## flour,

## sugar} => {whole milk} 0.001251369 1 3.917279 8

## [18] {flour,

## margarine,

## root vegetables} => {whole milk} 0.001094948 1 3.917279 7

## [19] {flour,

## root vegetables,

## whipped/sour cream} => {whole milk} 0.001877053 1 3.917279 12

## [20] {ice cream,

## newspapers,

## root vegetables} => {other vegetables} 0.001094948 1 5.300995 7# Subset con los elementos cuya confianza sea superior

rules2 <- subset(reglas, subset = (confidence > 0.7))

# Ordenamos las reglas por lift e inspeccionamos las primeras reglas, aunque solo hay que elegir la primera regla,

# consulto el resto para poder ver que el lift es superior en el resto

rules2 <- sort(rules2, by = "lift")

inspect(rules2[1:5])## lhs rhs support confidence lift count

## [1] {bottled beer,

## liquor,

## soda} => {red/blush wine} 0.001251369 0.8000000 41.92131 8

## [2] {curd,

## other vegetables,

## whipped/sour cream,

## whole milk,

## yogurt} => {cream cheese} 0.001407790 0.8181818 22.16371 9

## [3] {curd,

## root vegetables,

## whipped/sour cream,

## yogurt} => {cream cheese} 0.001094948 0.7777778 21.06921 7

## [4] {sugar,

## whipped/sour cream,

## whole milk,

## yogurt} => {curd} 0.001251369 0.8888889 17.70301 8

## [5] {ham,

## specialty bar} => {white bread} 0.001094948 0.7777778 17.02854 74.1.6 Analisis del rmd de Daniel Redondo

En el siguiente enlance encontramos un rmd relativo a reglas de asociacion elaborado por Daniel Redondo:

https://danielredondo.com/posts/20200405_reglas_asociacion/

A lo largo del rmd podemos ver las mismas tecnicas estudiadas en clase, y podría destacar unicamente la siguiente funcion no vista:

interesMeasure

Esta funcion proporciona:

Si solo se usa una medida, la función devuelve un vector numérico que contiene los valores de la medida de interés para cada asociación en el conjunto de asociaciones x.

Si se especifican más de una medida, el resultado es un data.frame que contiene las diferentes medidas para cada asociación como columnas.

NA se devuelve para reglas / conjuntos de elementos para los que no se define una determinada medida.

Esta funcion tiene un parametro llamado measure, el cual indica las medidas de interes que queremos aplicar. Existen un gran numero de posbiles medidads implementadas, sin embargo, en el rmd estudiado hace uso de measure = c(“gini”, “chiSquared”).

gini mide la entropía cuadrática de una regla, y chiSquared sirve para probar la independencia entre las lhs y rhs de la regla. Los valores de chi-cuadrado más altos indican que lhs y rhs no son independientes

4.1.7 Ejercicio Iris

Analizando el dataset Iris

- Cargar en R el dataset Iris.

- Utilizar las funciones que se han visto para analizar el dataset, ver número de transacciones, items del dataset, información estadística del dataset. NOTA: dataset debe ser preprocesado. Discretizar de tres formas: transformando el tipo de las variables (convirtiendo a factor), discretizando los datos (convirtiendo en categóricos), y usando el comando discretize. Guardar los resultados en tres datasets. Consulta la ayuda de arules para discretize.

# Cargamos iris en los tres datasets, para luego modificar cada uno.

ds1 <- ds2 <- ds3 <- iris

## Usando factores

factor_sepal_length = cut(iris$Sepal.Length, breaks = 3,

labels = c("S_short", "S_medium", "S_long"),

include.lowest = TRUE)

factor_sepal_width = cut(iris$Sepal.Width, breaks = 3,

labels = c("S_thin", "S_medium", "S_wide"),

include.lowest = TRUE)

factor_petal_length = cut(iris$Petal.Length, breaks = 3,

labels = c("P_short", "P_medium", "P_long"),

include.lowest = TRUE)

factor_petal_width = cut(iris$Petal.Width, breaks = 3,

labels = c("P_thin", "P_medium", "P_wide"),

include.lowest = TRUE)

# Cargamos los nuevos datos en el dataset, siendo todos de tipo factor.

ds1$Sepal.Length <- factor_sepal_length

ds1$Sepal.Width <- factor_sepal_width

ds1$Petal.Length <- factor_petal_length

ds1$Petal.Width <- factor_petal_width

paged_table(ds1)# Conversion a transactions

ds1 <- as(ds1, "transactions")

## Conversion a variables categoricas

i <- (max(iris$Sepal.Length)-min(iris$Sepal.Length))/3

base <- min(iris$Sepal.Length)

c1 <- c(base, base+i, base+i*2)

ds2$Sepal.Length[iris$Sepal.Length < c1[2]] <- "S_short"

ds2$Sepal.Length[iris$Sepal.Length >= c1[2] & iris$Sepal.Length < c1[3]] <- "S_medium"

ds2$Sepal.Length[iris$Sepal.Length >= c1[3]] <- "S_long"

ds2$Sepal.Length <- factor(ds2$Sepal.Length)

i <- (max(iris$Sepal.Width)-min(iris$Sepal.Width))/3

base <- min(iris$Sepal.Width)

c2 <- c(base, base+i, base+i*2)

ds2$Sepal.Width[iris$Sepal.Width < c2[2]] <- "S_thin"

ds2$Sepal.Width[iris$Sepal.Width >= c2[2] & iris$Sepal.Width < c2[3]] <- "S_medium"

ds2$Sepal.Width[iris$Sepal.Width >= c2[3]] <- "S_wide"

ds2$Sepal.Width <- factor(ds2$Sepal.Width)

i <- (max(iris$Petal.Length)-min(iris$Petal.Length))/3

base <- min(iris$Petal.Length)

c3 <- c(base, base+i, base+i*2)

ds2$Petal.Length[iris$Petal.Length < c3[2]] <- "P_short"

ds2$Petal.Length[iris$Petal.Length >= c3[2] & iris$Petal.Length < c3[3]] <- "P_medium"

ds2$Petal.Length[iris$Petal.Length >= c3[3]] <- "P_long"

ds2$Petal.Length <- factor(ds2$Petal.Length)

i <- (max(iris$Petal.Width)-min(iris$Petal.Width))/3

base <- min(iris$Petal.Width)

c4 <- c(base, base+i, base+i*2)

ds2$Petal.Width[iris$Petal.Width < c4[2]] <- "P_thin"

ds2$Petal.Width[iris$Petal.Width >= c4[2] & iris$Petal.Width < c4[3]] <- "P_medium"

ds2$Petal.Width[iris$Petal.Width >= c4[3]] <- "P_wide"

ds2$Petal.Width <- factor(ds2$Petal.Width)

paged_table(ds2)# Conversion a transactions

ds2 <- as(ds2, "transactions")

## Usando el metodo discretize

# Este será el dataset que usaremos a lo largo del ejercicio

ds3$Sepal.Length <- discretize(iris$Sepal.Length,

labels = c("S_short", "S_medium", "S_long"),

method = "frequency", breaks = 3, include.lowest = TRUE)

ds3$Sepal.Width <- discretize(iris$Sepal.Width,

labels = c("S_thin", "S_medium", "S_wide"),

method = "frequency", breaks = 3, include.lowest = TRUE)

ds3$Petal.Length <- discretize(iris$Petal.Length,

labels = c("P_short", "P_medium", "P_long"),

method = "frequency", breaks = 3, include.lowest = TRUE)

ds3$Petal.Width <- discretize(iris$Petal.Width,

labels = c("P_thin", "P_medium", "P_wide"),

method = "frequency", breaks = 3, include.lowest = TRUE)

paged_table(ds3)# Conversion a transactions

ds3 <- as(ds3, "transactions")

# Numero de transacciones (Filas) e items (Columnas)

transacciones <- nrow(ds3)

transacciones## [1] 150## [1] 15## transactions as itemMatrix in sparse format with

## 150 rows (elements/itemsets/transactions) and

## 15 columns (items) and a density of 0.3333333

##

## most frequent items:

## Sepal.Width=S_wide Sepal.Length=S_medium Petal.Width=P_wide

## 56 53 52

## Sepal.Length=S_long Petal.Length=P_long (Other)

## 51 51 487

##

## element (itemset/transaction) length distribution:

## sizes

## 5

## 150

##

## Min. 1st Qu. Median Mean 3rd Qu. Max.

## 5 5 5 5 5 5

##

## includes extended item information - examples:

## labels variables levels

## 1 Sepal.Length=S_short Sepal.Length S_short

## 2 Sepal.Length=S_medium Sepal.Length S_medium

## 3 Sepal.Length=S_long Sepal.Length S_long

##

## includes extended transaction information - examples:

## transactionID

## 1 1

## 2 2

## 3 3- Utilizar algoritmo apriori para obtener las reglas de asociación con confianza 0.5 y soporte 0.01. LLamar estas reglas r1.

## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.5 0.1 1 none FALSE TRUE 5 0.01 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 1

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[15 item(s), 150 transaction(s)] done [0.00s].

## sorting and recoding items ... [15 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 5 done [0.00s].

## writing ... [532 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].- Encontrar reglas redundantes en r1 de dos formas distintas. Eliminarlas. Guardar en una variable las redundantes. Buscar en el paquete arules una función que te calcula las reglas redundantes.

Apunte: Una regla será redundante si existen reglas mas generales con la misma o mayor confianza, es decir, una regla más especifica es redundante si es igual o incluso menos predictiva que una regla más general. Una regla es mas general si tiene la misma RHS pero uno o mas itemas de la LHS son eliminados. Una regla \(X \Rightarrow Y\) es redundante si:

# Guardando las reglas redundantes

# Hacemos uso de la funcion del paquete arules is.redundant

idxRed <- which(is.redundant(r1))

vRed <- r1[idxRed]

vRed## set of 336 rules# Guardando en r1 las reglas sin redundancia

idxNoRed <- which(!is.redundant(r1))

r1 <- r1[idxNoRed]

r1## set of 196 rules- Generar 3 conjuntos de reglas que cumplan que ciertos valores estén a la izquierda y/o derecha. Llamarlas r2,r3,r4.

# Valores en la izquierda

r2 <- apriori(ds3,

parameter = list(supp = 0.01, conf = 0.50),

appearance = list(default="rhs",lhs="Sepal.Length=S_short"))## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.5 0.1 1 none FALSE TRUE 5 0.01 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 1

##

## set item appearances ...[1 item(s)] done [0.00s].

## set transactions ...[15 item(s), 150 transaction(s)] done [0.00s].

## sorting and recoding items ... [15 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 done [0.00s].

## writing ... [4 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].# Valores en la derecha

r3 <- apriori(ds3,

parameter = list(supp = 0.01, conf = 0.50),

appearance = list(rhs="Species=setosa",default = "lhs"))## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.5 0.1 1 none FALSE TRUE 5 0.01 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 1

##

## set item appearances ...[1 item(s)] done [0.00s].

## set transactions ...[15 item(s), 150 transaction(s)] done [0.00s].

## sorting and recoding items ... [15 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 4 5 done [0.00s].

## writing ... [29 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].# Valores en ambos lados

r4 <- apriori(ds3,

parameter = list(supp = 0.01, conf = 0.50),

appearance = list(rhs="Species=setosa", lhs="Petal.Width=P_thin"))## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.5 0.1 1 none FALSE TRUE 5 0.01 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 1

##

## set item appearances ...[2 item(s)] done [0.00s].

## set transactions ...[2 item(s), 150 transaction(s)] done [0.00s].

## sorting and recoding items ... [2 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 done [0.00s].

## writing ... [1 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].- Unir r2 y r3 y buscar reglas duplicadas y reglas redundantes.

# Haremos uso del operador c()

unionR2R3 <- c(r2,r3)

# Eliminar duplicados

unionR2R3 <- arules::unique(unionR2R3)

unionR2R3## set of 32 rules# Eliminar reglas redundantes

idx <- which(is.redundant(unionR2R3))

unionR2R3 <- unionR2R3[-idx]

inspect(unionR2R3)## lhs rhs support confidence lift count

## [1] {Sepal.Length=S_short} => {Petal.Length=P_short} 0.26666667 0.8695652 2.608696 40

## [2] {Sepal.Length=S_short} => {Petal.Width=P_thin} 0.26666667 0.8695652 2.608696 40

## [3] {Sepal.Length=S_short} => {Species=setosa} 0.26666667 0.8695652 2.608696 40

## [4] {Sepal.Length=S_short} => {Sepal.Width=S_wide} 0.18666667 0.6086957 1.630435 28

## [5] {Petal.Length=P_short} => {Species=setosa} 0.33333333 1.0000000 3.000000 50

## [6] {Petal.Width=P_thin} => {Species=setosa} 0.33333333 1.0000000 3.000000 50

## [7] {Sepal.Width=S_wide} => {Species=setosa} 0.25333333 0.6785714 2.035714 38

## [8] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Species=setosa} 0.07333333 1.0000000 3.000000 11

## [9] {Sepal.Length=S_short,

## Sepal.Width=S_wide} => {Species=setosa} 0.18666667 1.0000000 3.000000 28

## [10] {Sepal.Length=S_medium,

## Sepal.Width=S_wide} => {Species=setosa} 0.06666667 0.7692308 2.307692 10- Hacer la intersección de r2 y r3.

## lhs rhs support confidence lift

## [1] {Sepal.Length=S_short} => {Species=setosa} 0.2666667 0.8695652 2.608696

## count

## [1] 40- Usa subset para inspeccionar las reglas con distintas condiciones.

# Ejemplos del uso de subset

sub <- subset(r1, subset = lift > 3)

# inspect(sub)

# Uso de %in% para seleccionar todas las reglas que contengan species=setosa en el consecuente.

sub1 <- subset(r1, subset = rhs %in% "Species=setosa")

inspect(sub1)## lhs rhs support confidence lift count

## [1] {Sepal.Length=S_short} => {Species=setosa} 0.26666667 0.8695652 2.608696 40

## [2] {Petal.Length=P_short} => {Species=setosa} 0.33333333 1.0000000 3.000000 50

## [3] {Petal.Width=P_thin} => {Species=setosa} 0.33333333 1.0000000 3.000000 50

## [4] {Sepal.Width=S_wide} => {Species=setosa} 0.25333333 0.6785714 2.035714 38

## [5] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Species=setosa} 0.07333333 1.0000000 3.000000 11

## [6] {Sepal.Length=S_short,

## Sepal.Width=S_wide} => {Species=setosa} 0.18666667 1.0000000 3.000000 28

## [7] {Sepal.Length=S_medium,

## Sepal.Width=S_wide} => {Species=setosa} 0.06666667 0.7692308 2.307692 10# Uso de %pin%, selccion parcial, para todos los items que contengan petal.length en rhs

sub2 <- subset(r1, subset = rhs %pin% "Petal.Length=") # 41 resultados

# inspect(sub2)

# Uso de %ain% para seleccionar solo las reglas que tengan items con "Sepal.Length=S_short","Sepal.Width=S_medium" en lhs

sub3 <- subset(r1, subset=lhs%ain%c("Sepal.Length=S_short","Sepal.Width=S_medium"))

inspect(sub3)## lhs rhs support confidence lift count

## [1] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Petal.Length=P_short} 0.07333333 1 3 11

## [2] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Petal.Width=P_thin} 0.07333333 1 3 11

## [3] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Species=setosa} 0.07333333 1 3 11# Uso de %oin% para seleccionar las reglas que tengan alguno o todos los items en lhs.

sub4 <- subset(r1, subset=lhs%oin%c("Sepal.Length=S_short","Sepal.Width=S_medium"))

inspect(sub4)## lhs rhs support confidence lift count

## [1] {Sepal.Length=S_short} => {Petal.Length=P_short} 0.26666667 0.8695652 2.608696 40

## [2] {Sepal.Length=S_short} => {Petal.Width=P_thin} 0.26666667 0.8695652 2.608696 40

## [3] {Sepal.Length=S_short} => {Species=setosa} 0.26666667 0.8695652 2.608696 40

## [4] {Sepal.Length=S_short} => {Sepal.Width=S_wide} 0.18666667 0.6086957 1.630435 28

## [5] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Petal.Length=P_short} 0.07333333 1.0000000 3.000000 11

## [6] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Petal.Width=P_thin} 0.07333333 1.0000000 3.000000 11

## [7] {Sepal.Length=S_short,

## Sepal.Width=S_medium} => {Species=setosa} 0.07333333 1.0000000 3.000000 11- Usa summary, sort.

## set of 196 rules

##

## rule length distribution (lhs + rhs):sizes

## 2 3 4

## 51 109 36

##

## Min. 1st Qu. Median Mean 3rd Qu. Max.

## 2.000 2.000 3.000 2.923 3.000 4.000

##

## summary of quality measures:

## support confidence lift count

## Min. :0.01333 Min. :0.5000 Min. :1.339 Min. : 2.00

## 1st Qu.:0.04000 1st Qu.:0.7025 1st Qu.:2.109 1st Qu.: 6.00

## Median :0.11333 Median :0.9208 Median :2.713 Median :17.00

## Mean :0.13480 Mean :0.8470 Mean :2.542 Mean :20.22

## 3rd Qu.:0.24000 3rd Qu.:1.0000 3rd Qu.:2.951 3rd Qu.:36.00

## Max. :0.33333 Max. :1.0000 Max. :3.261 Max. :50.00

##

## mining info:

## data ntransactions support confidence

## ds3 150 0.01 0.5# Ordenado por nivel confianza

sortedR1byConfidence <- sort(r1, by="confidence")

inspect(head(sortedR1byConfidence))## lhs rhs support confidence lift

## [1] {Petal.Length=P_short} => {Petal.Width=P_thin} 0.3333333 1 3

## [2] {Petal.Width=P_thin} => {Petal.Length=P_short} 0.3333333 1 3

## [3] {Petal.Length=P_short} => {Species=setosa} 0.3333333 1 3

## [4] {Species=setosa} => {Petal.Length=P_short} 0.3333333 1 3

## [5] {Petal.Width=P_thin} => {Species=setosa} 0.3333333 1 3

## [6] {Species=setosa} => {Petal.Width=P_thin} 0.3333333 1 3

## count

## [1] 50

## [2] 50

## [3] 50

## [4] 50

## [5] 50

## [6] 50# Ordenado por nivel soporte

# Reglas con soporte alto indican frecuencia de apariencia en el dataset.

sortedR1bySupport <- sort(r1, by="support")

inspect(head(sortedR1bySupport))## lhs rhs support confidence lift

## [1] {Petal.Length=P_short} => {Petal.Width=P_thin} 0.3333333 1 3

## [2] {Petal.Width=P_thin} => {Petal.Length=P_short} 0.3333333 1 3

## [3] {Petal.Length=P_short} => {Species=setosa} 0.3333333 1 3

## [4] {Species=setosa} => {Petal.Length=P_short} 0.3333333 1 3

## [5] {Petal.Width=P_thin} => {Species=setosa} 0.3333333 1 3

## [6] {Species=setosa} => {Petal.Width=P_thin} 0.3333333 1 3

## count

## [1] 50

## [2] 50

## [3] 50

## [4] 50

## [5] 50

## [6] 50Explicar y usar los comandos de paquete arules siguientes: dissimilarity, image, is.redundant, is.significant, itemFrequency.

dissimilarity: Debemos entender en que consiste el cálculo de disimilitud. Esto se corresponde con el cálculo de falta de semejanza entre dos objetos principalmente. Este cálculo es facilitado por la funcion dissimilarity y el método S4* para computar y devolver las distancias en matrices de datos binarios, transacciones o asociaciones que pueden ser utilizadas para agrupamiento o clustering.

S4*: El sistema S4 de R es un sistema para la programación orientada a objetos. Este sistema es de utilidad para reconocer objetos S4 y para aprender características o factores para saber como explorar, manipular y usar la ayuda del sistema cuando encontramos clases y métodos S4.

## 1 2 3

## 2 0.6666667

## 3 0.6666667 0.6666667

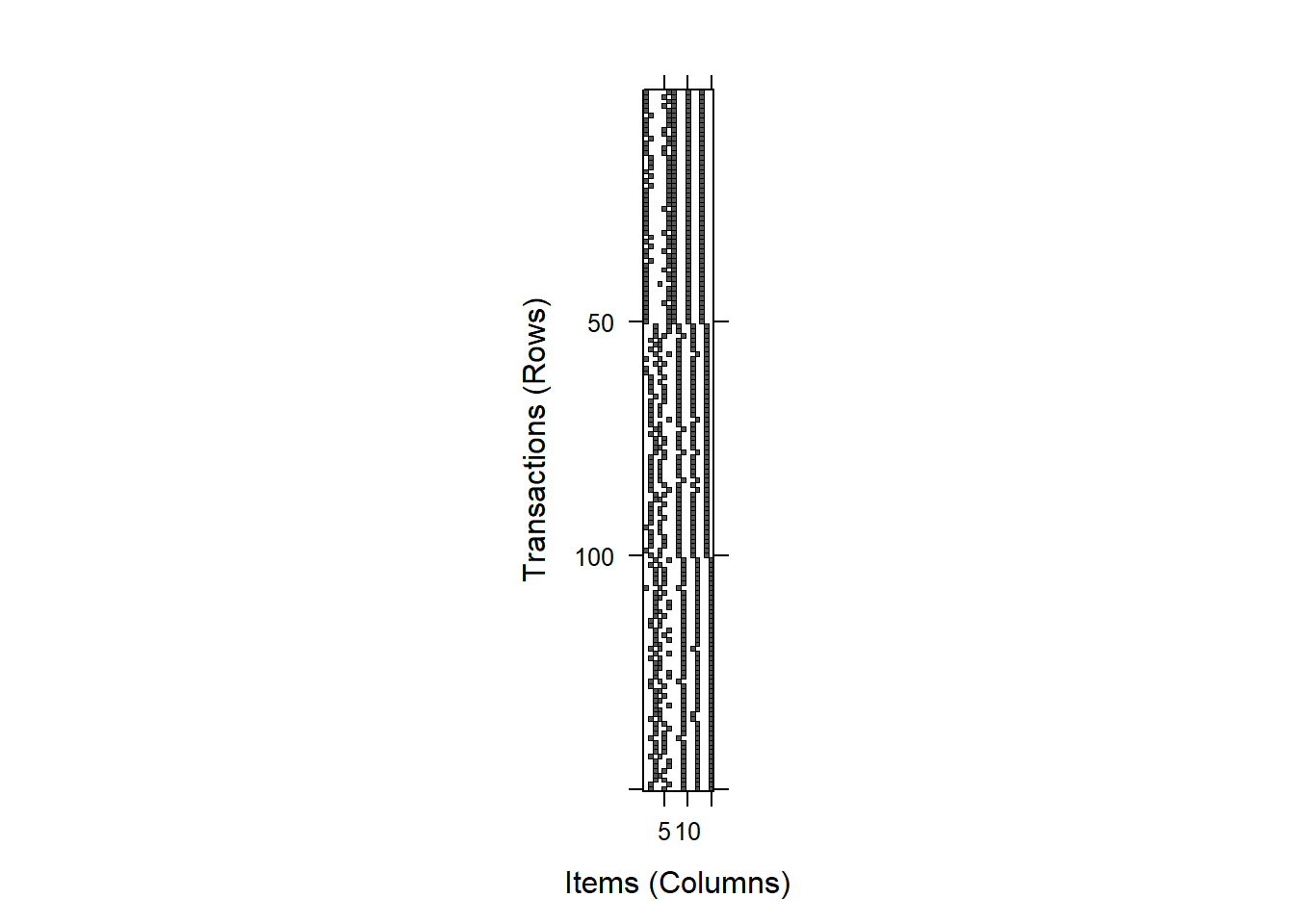

## 4 0.6666667 0.6666667 0.6666667- image: Se trata de una funcion capaz de generar gráficos de nivel para inspeccionar visualmente matrices de incidencia binarias, es decir, objetos basados en itemMatrix (por ejemplo, transacciones, tidLists, items en itemsets o rhs/lhs en reglas). Estos gráficos se pueden usar para identificar problemas en un conjunto de datos (por ejemplo, registrar problemas con algunas transacciones que contienen todos los artículos).

is.redundant: En el ejercicio 4 se realiza una explicacion de lo que significa ser una regla redundante. Este metodo del paquete arules nos permite extraer las reglas que son redundantes dentro de un conjunto de reglas.

is.significant: Sirve para encontrar reglas donde LHS y RHS dependen el uno del otro. Este método utiliza la prueba exacta de Fisher y corrige las comparaciones múltiples.

## [1] TRUE TRUE TRUE TRUE TRUE TRUE FALSE FALSE TRUE TRUE TRUE TRUE

## [13] TRUE TRUE FALSE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE

## [25] TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE

## [37] TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE

## [49] TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE FALSE FALSE FALSE

## [61] FALSE FALSE FALSE FALSE FALSE FALSE FALSE TRUE TRUE TRUE TRUE TRUE

## [73] TRUE TRUE FALSE FALSE TRUE FALSE TRUE FALSE FALSE FALSE TRUE TRUE

## [85] TRUE TRUE TRUE TRUE TRUE TRUE TRUE TRUE FALSE FALSE FALSE TRUE

## [97] FALSE TRUE FALSE FALSE TRUE FALSE FALSE TRUE FALSE TRUE FALSE FALSE

## [109] FALSE FALSE TRUE TRUE TRUE TRUE TRUE FALSE TRUE FALSE FALSE FALSE

## [121] FALSE TRUE TRUE FALSE FALSE FALSE FALSE FALSE FALSE FALSE FALSE TRUE

## [133] FALSE TRUE FALSE TRUE FALSE FALSE FALSE FALSE TRUE TRUE TRUE TRUE

## [145] TRUE TRUE TRUE FALSE TRUE TRUE TRUE TRUE TRUE TRUE TRUE FALSE

## [157] TRUE TRUE FALSE TRUE TRUE FALSE FALSE TRUE TRUE TRUE FALSE FALSE

## [169] FALSE FALSE TRUE FALSE TRUE TRUE FALSE FALSE TRUE FALSE FALSE FALSE

## [181] TRUE FALSE TRUE TRUE TRUE FALSE FALSE FALSE FALSE FALSE FALSE FALSE

## [193] FALSE FALSE TRUE TRUE## set of 120 rules- itemFrequency: Sirve para obtener la frecuencia o soporte para todos los elementos individuales en un objeto basado en itemMatrix. Por ejemplo, se utiliza para obtener el soporte de un solo elemento de un objeto de transacciones de clase sin mineria.

## Sepal.Length=S_short Sepal.Length=S_medium Sepal.Length=S_long

## 0.3066667 0.3533333 0.3400000

## Sepal.Width=S_thin Sepal.Width=S_medium Sepal.Width=S_wide

## 0.3133333 0.3133333 0.3733333

## Petal.Length=P_short Petal.Length=P_medium Petal.Length=P_long

## 0.3333333 0.3266667 0.3400000

## Petal.Width=P_thin Petal.Width=P_medium Petal.Width=P_wide

## 0.3333333 0.3200000 0.3466667

## Species=setosa Species=versicolor Species=virginica

## 0.3333333 0.3333333 0.33333334.1.8 Reglas de Asociación - dataset online

Crear un Notebook (.Rmd) con la resolución de la presente práctica. Explicando los comandos que uséis. Se valorará en gran medida la presentación del trabajo (presentaciones con RmarkDown con hojas de estilo, fondos, diferentes formatos de salida, etc.)

Se entregará en el CV los diferentes .Rmd si se generan distintas salidas: ioslide, html, pdf, etc. junto con las salidas de cada fichero .Rmd. Comprimir todos los ficheros antes de subir.

Nota curso 2020:

- Se entregará en la tarea lo que cada alumno haga durante la duración de la clase.

- Sino da tiempo a terminarlo queda como ejercicio para incorporar a Book final del curso.

- Si algún grupo consigue hacer análisis similar a este con algún dataset de COVID queda exento de tener que hacerlo.

Explorando el dataset online.csv

- Descargar a local el dataset online.csv (en GitHub ClassRoom - directorio Ficheros).

library(dplyr)

library(arules)

library(arulesViz)

dataset <- read.csv("online.csv", header = FALSE) # El dataset no tiene nombre de columnas- Analizar la estructura, tipo,… del dataset.

## [1] "data.frame"## 'data.frame': 22343 obs. of 3 variables:

## $ V1: Factor w/ 603 levels "2000-01-01","2000-01-02",..: 1 1 1 1 1 1 1 1 1 1 ...

## $ V2: int 1 1 1 1 1 1 1 1 1 1 ...

## $ V3: Factor w/ 38 levels "all- purpose",..: 38 25 27 20 1 12 31 5 36 4 ...## [1] 3## [1] 22343- Analizar significado, estructura, tipo,… de cada columna.

## [1] "factor"## [1] "integer"## [1] "factor"## Factor w/ 603 levels "2000-01-01","2000-01-02",..: 1 1 1 1 1 1 1 1 1 1 ...## int [1:22343] 1 1 1 1 1 1 1 1 1 1 ...## Factor w/ 38 levels "all- purpose",..: 38 25 27 20 1 12 31 5 36 4 ...## [1] "all- purpose" "aluminum foil"

## [3] "bagels" "beef"

## [5] "butter" "cereals"

## [7] "cheeses" "coffee/tea"

## [9] "dinner rolls" "dishwashing liquid/detergent"

## [11] "eggs" "flour"

## [13] "fruits" "hand soap"

## [15] "ice cream" "individual meals"

## [17] "juice" "ketchup"

## [19] "laundry detergent" "lunch meat"

## [21] "milk" "mixes"

## [23] "paper towels" "pasta"

## [25] "pork" "poultry"

## [27] "sandwich bags" "sandwich loaves"

## [29] "shampoo" "soap"

## [31] "soda" "spaghetti sauce"

## [33] "sugar" "toilet paper"

## [35] "tortillas" "vegetables"

## [37] "waffles" "yogurt"- Comandos para ver las primeras filas y las últimas.

## V1 V2 V3

## 1 2000-01-01 1 yogurt

## 2 2000-01-01 1 pork

## 3 2000-01-01 1 sandwich bags

## 4 2000-01-01 1 lunch meat

## 5 2000-01-01 1 all- purpose

## 6 2000-01-01 1 flour## V1 V2 V3

## 22338 2002-02-25 1138 vegetables

## 22339 2002-02-26 1139 soda

## 22340 2002-02-26 1139 laundry detergent

## 22341 2002-02-26 1139 vegetables

## 22342 2002-02-26 1139 shampoo

## 22343 2002-02-26 1139 vegetables- Cambiar los nombres de las columnas: Fecha, IDcomprador,ProductoComprado.

## 'data.frame': 22343 obs. of 3 variables:

## $ Fecha : Factor w/ 603 levels "2000-01-01","2000-01-02",..: 1 1 1 1 1 1 1 1 1 1 ...

## $ IDcomprador : int 1 1 1 1 1 1 1 1 1 1 ...

## $ ProductoComprado: Factor w/ 38 levels "all- purpose",..: 38 25 27 20 1 12 31 5 36 4 ...- Hacer un resumen (summary) del dataset y analizar toda la información detalladamente que devuelve el comando.

## Fecha IDcomprador ProductoComprado

## 2001-02-08: 196 Min. : 1.0 vegetables: 1702

## 2001-02-20: 155 1st Qu.: 292.0 poultry : 640

## 2000-03-06: 148 Median : 582.0 soda : 597

## 2000-03-01: 136 Mean : 576.4 cereals : 591

## 2000-05-17: 134 3rd Qu.: 863.0 ice cream : 579

## 2001-01-09: 133 Max. :1139.0 cheeses : 578

## (Other) :21441 (Other) :17656# Devuelve las apariciones de cada Fecha y ProductoComprado, pero solo mostrará las mas frecuentes, no todos los elementos.

# Devuelve valor minimo, maximo, media y cuartiles del IDcomprador- Implementar una función que usando funciones vectoriales de R (apply, tapply, sapply,…) te devuelva si hay valores NA en las columnas del dataset, si así lo fuera devolver sus índices y además sustituirlos por el valor 0.

AYUDA: Una función similar a la siguiente:

na.in.dataframe <- function(dataframe){

# hay.nas <- sum(is.na(dataset))

dataframe <- as.matrix(dataframe)

numNAs <- sum(sapply(dataframe, is.na))

hay.nas <- numNAs

if (hay.nas == 0) {

dataframe.sin.nas <- dataframe

posiciones = 0;

}else{

posiciones <- which(is.na(dataframe))

dataframe.sin.nas <- dataframe

dataframe.sin.nas[posiciones] <- 0

}

dataframe.sin.nas <- as.data.frame(dataframe.sin.nas)

return(list(hay.nas,dataframe.sin.nas,posiciones))

}

# No tiene datos NA el dataset

# na.in.dataframe(dataset)- Calcular número de filas del dataset

## [1] 22343- Calcula en cuántas fechas distintas se han realizado ventas.

## [1] 603- Calcula cuántos compradores distintos hay en el dataset.

## [1] 1139- Calcula cuántos producto distintos se han vendido.

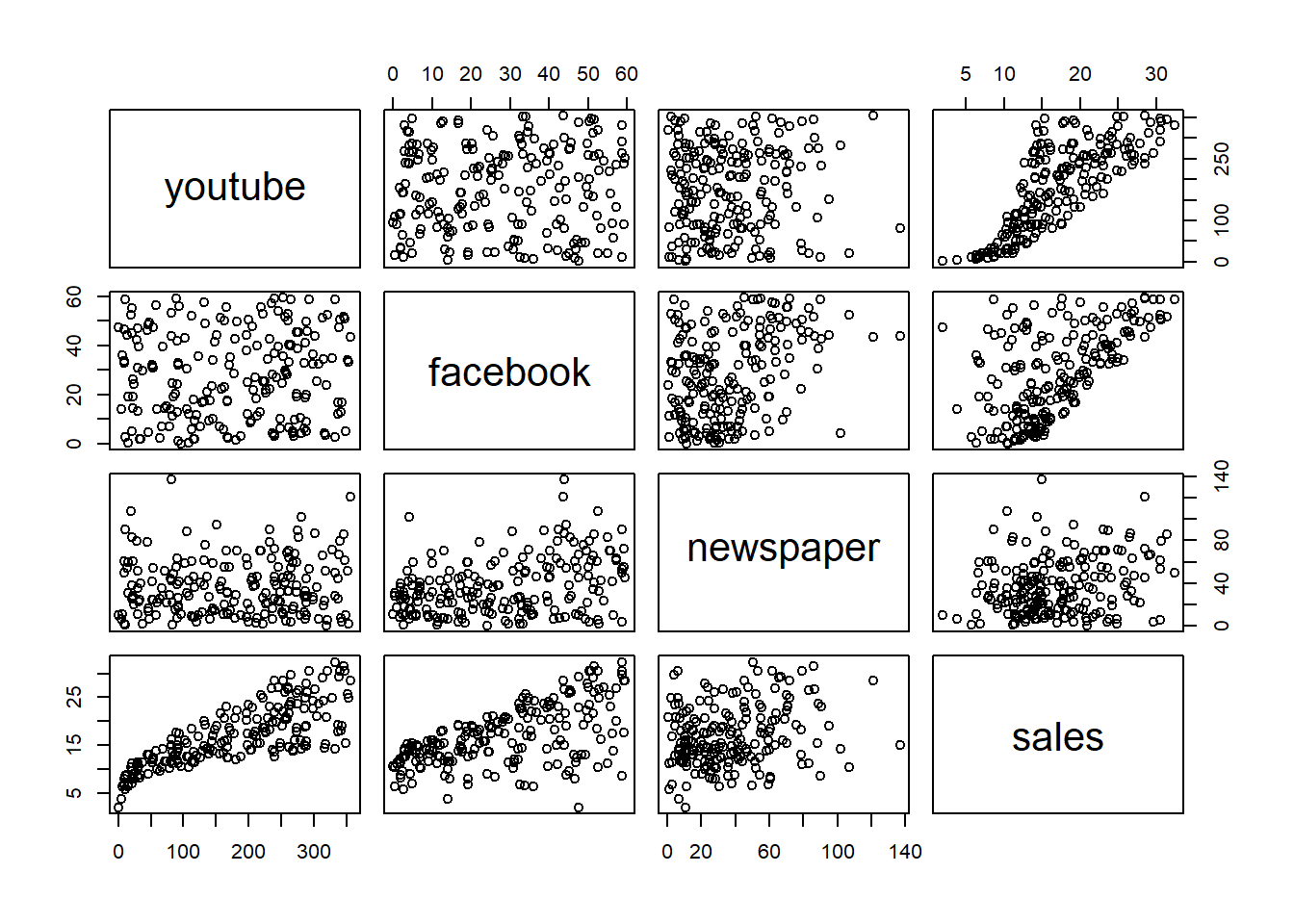

## [1] 38- Visualiza con distintos gráficos el dataset

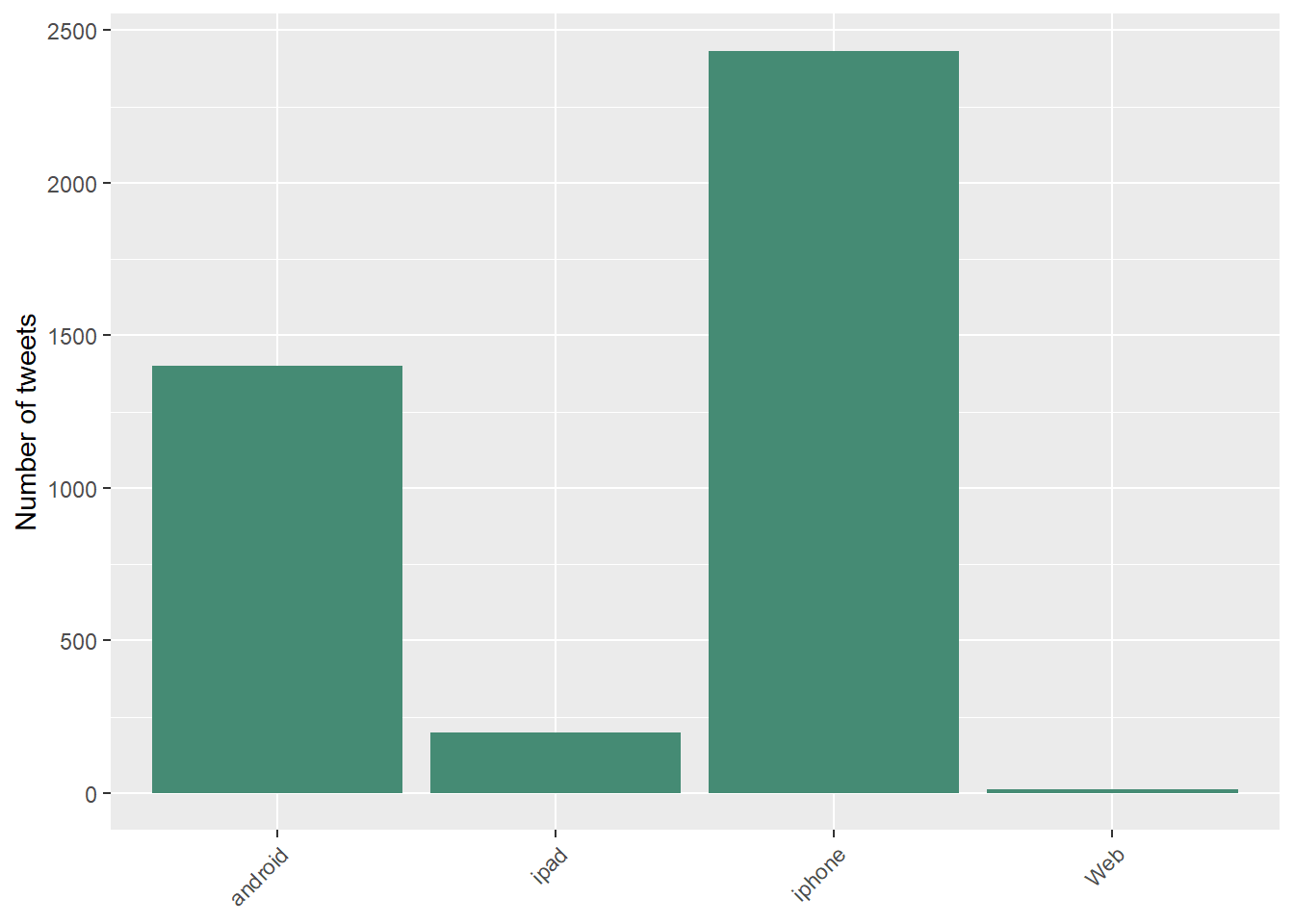

- Los valores distintos de cada columna con varios tipos de gráficos.

- Enfrenta unas variables contra otras para buscar patrones y comenta los patrones que puedas detectar.

- Usa split para construir a partir de dataset una lista con nombre lista.compra.usuarios en la que cada elemento de la lista es cada comprador junto con todos los productos que ha comprado

Este paso es crucial para poder extraer posteriormente las reglas de asociación.

El resultado debe ser el siguiente:

lista.compra.usuarios <- split(x = dataset[, "ProductoComprado"], f = dataset$IDcomprador)

lista.compra.usuarios[1:2]## $`1`

## [1] yogurt pork sandwich bags lunch meat

## [5] all- purpose flour soda butter

## [9] vegetables beef aluminum foil all- purpose

## [13] dinner rolls shampoo all- purpose mixes

## [17] soap laundry detergent ice cream dinner rolls

## 38 Levels: all- purpose aluminum foil bagels beef butter cereals ... yogurt

##

## $`2`

## [1] toilet paper shampoo

## [3] hand soap waffles

## [5] vegetables cheeses

## [7] mixes milk

## [9] sandwich bags laundry detergent

## [11] dishwashing liquid/detergent waffles

## [13] individual meals hand soap

## [15] vegetables individual meals

## [17] yogurt cereals

## [19] shampoo vegetables

## [21] aluminum foil tortillas

## [23] mixes

## 38 Levels: all- purpose aluminum foil bagels beef butter cereals ... yogurt- Hacer summary de lista.compra.usuarios

# La evaluacion esta a false pues se aplica summary a cada usuario

# Pero los valores devueltos son la cantidad de productos comprados, el tipo y el modo

summary(lista.compra.usuarios)- Contar cuántos usuarios hay en la lista lista.compra.usuarios

## [1] 1139- Detectar y eliminar duplicados en la lista.compra.usuarios

AYUDA: Usar lapply llamando a función unique.

- Contar cuántos usuarios hay en la lista después de eliminar duplicados.

## [1] 1139- Convertir a tipo de datos transacciones. Guardar en Tlista.compra.usuarios.

- Hacer inspect de los dos primeros valores de Tlista.compra.usuarios.

## items transactionID

## [1] {all- purpose,

## aluminum foil,

## beef,

## butter,

## dinner rolls,

## flour,

## ice cream,

## laundry detergent,

## lunch meat,

## mixes,

## pork,

## sandwich bags,

## shampoo,

## soap,

## soda,

## vegetables,

## yogurt} 1

## [2] {aluminum foil,

## cereals,

## cheeses,

## dishwashing liquid/detergent,

## hand soap,

## individual meals,

## laundry detergent,

## milk,

## mixes,

## sandwich bags,

## shampoo,

## toilet paper,

## tortillas,

## vegetables,

## waffles,

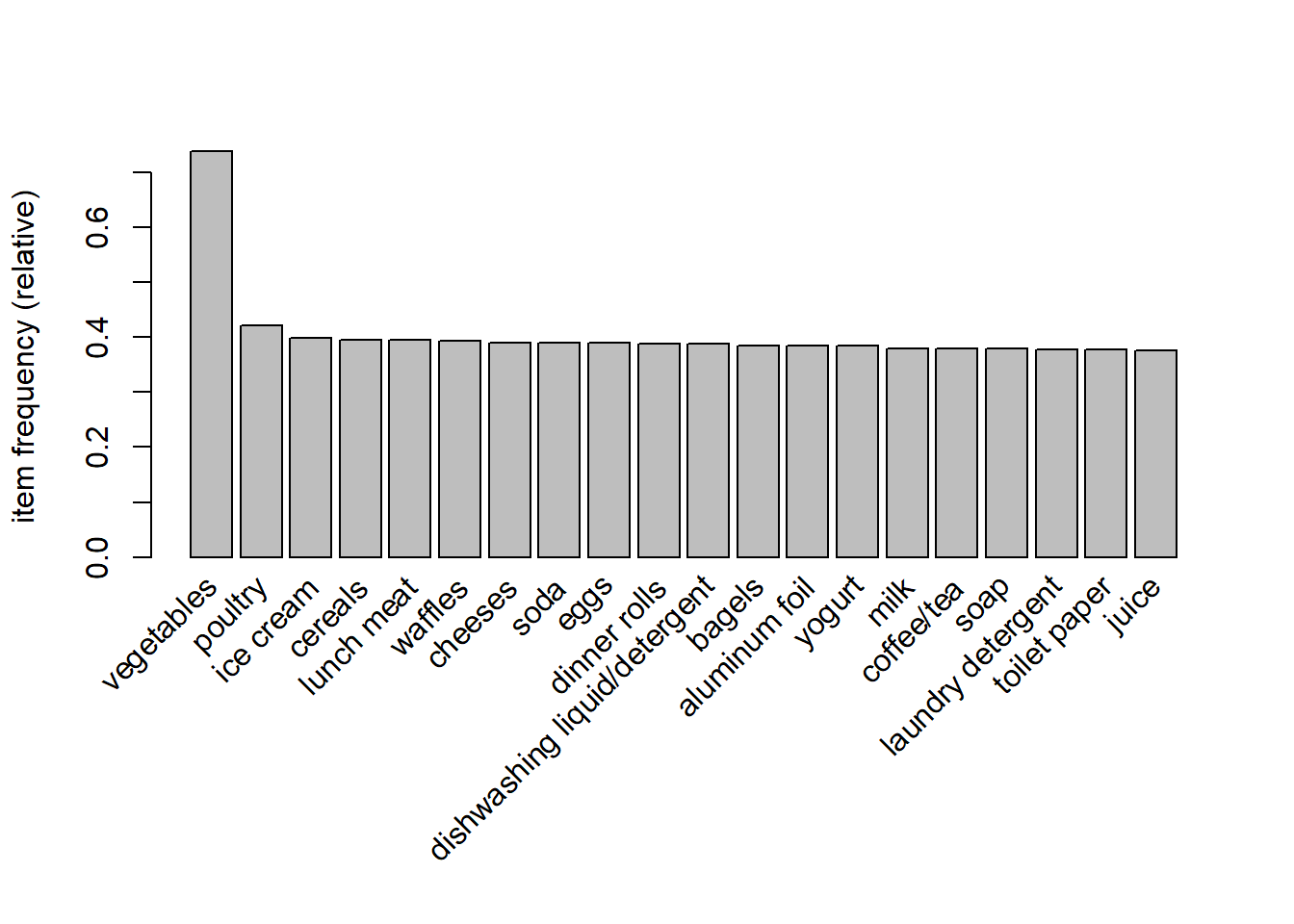

## yogurt} 2- Buscar ayuda de itemFrequencyPlot para visualizar las 20 transacciones más frecuentes.

- Generar las reglas de asociación con 80% de confianza y 15% de soporte.

## Apriori

##

## Parameter specification:

## confidence minval smax arem aval originalSupport maxtime support minlen

## 0.5 0.1 1 none FALSE TRUE 5 0.1 1

## maxlen target ext

## 10 rules FALSE

##

## Algorithmic control:

## filter tree heap memopt load sort verbose

## 0.1 TRUE TRUE FALSE TRUE 2 TRUE

##

## Absolute minimum support count: 113

##

## set item appearances ...[0 item(s)] done [0.00s].

## set transactions ...[38 item(s), 1139 transaction(s)] done [0.00s].

## sorting and recoding items ... [38 item(s)] done [0.00s].

## creating transaction tree ... done [0.00s].

## checking subsets of size 1 2 3 done [0.00s].

## writing ... [716 rule(s)] done [0.00s].

## creating S4 object ... done [0.00s].- Ver las reglas generadas y ordenalas por lift. Guarda el resultado en una variable nueva.

## lhs rhs support

## [1] {soda,vegetables} => {eggs} 0.1580334

## [2] {dinner rolls,vegetables} => {eggs} 0.1562774

## [3] {pasta,vegetables} => {eggs} 0.1439860

## [4] {dishwashing liquid/detergent,vegetables} => {eggs} 0.1536435

## [5] {lunch meat,vegetables} => {waffles} 0.1571554

## [6] {individual meals,vegetables} => {lunch meat} 0.1431080

## confidence lift count

## [1] 0.5172414 1.326887 180

## [2] 0.5071225 1.300929 178

## [3] 0.5030675 1.290527 164

## [4] 0.5014327 1.286333 175

## [5] 0.5042254 1.279093 179

## [6] 0.5015385 1.269450 163- Elimina todas las reglas redundantes. Calcula el % de reglas redundantes que había.

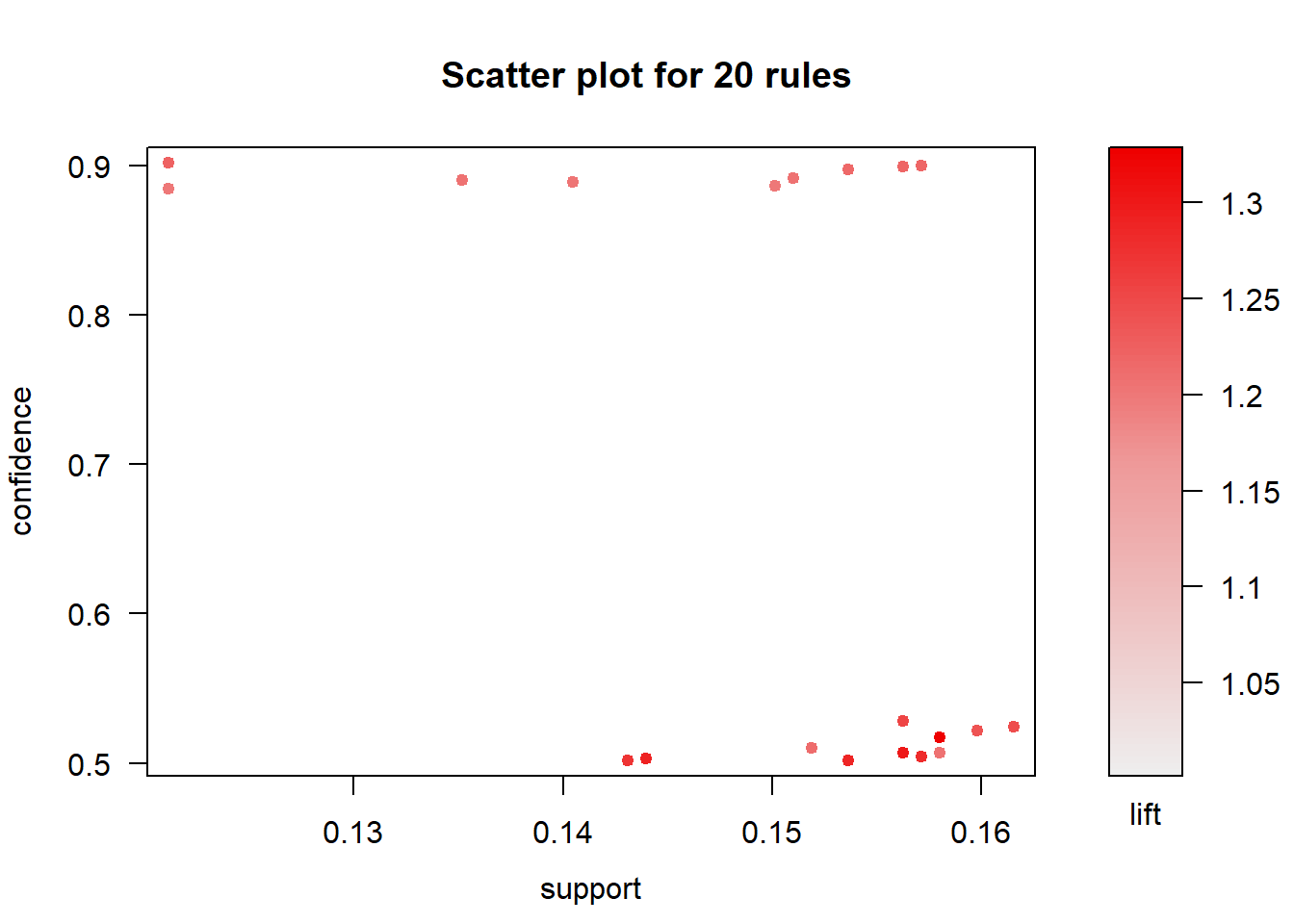

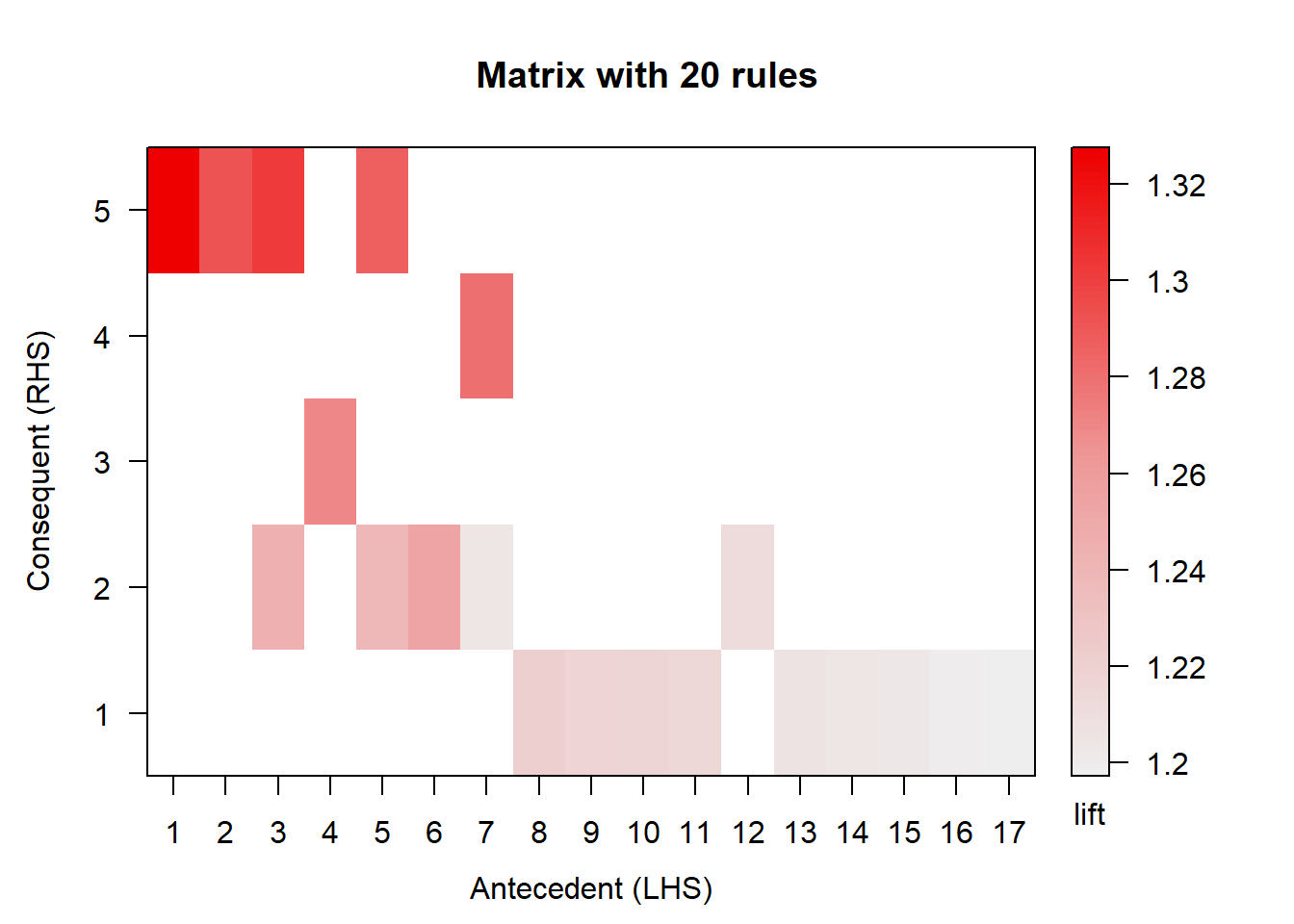

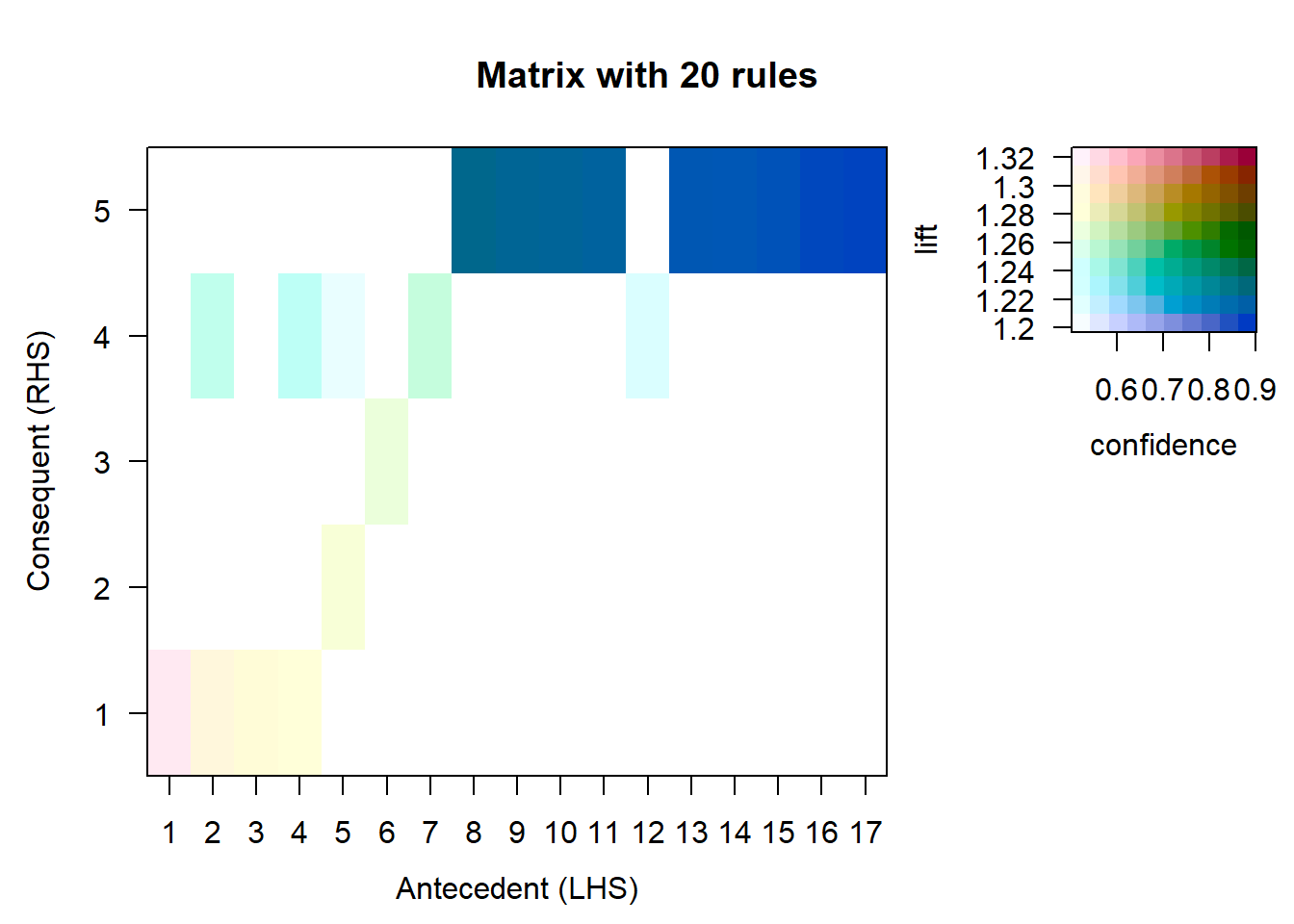

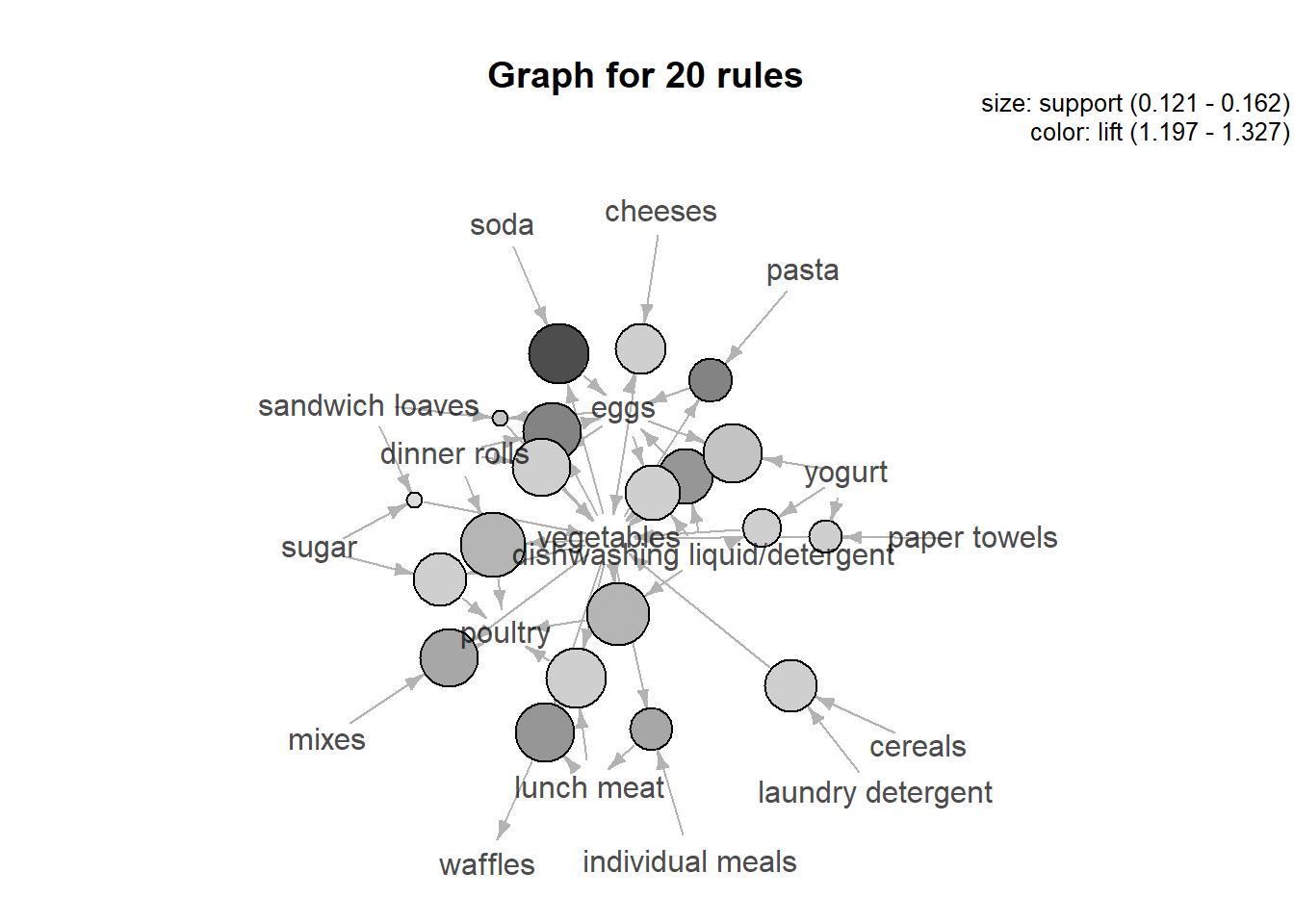

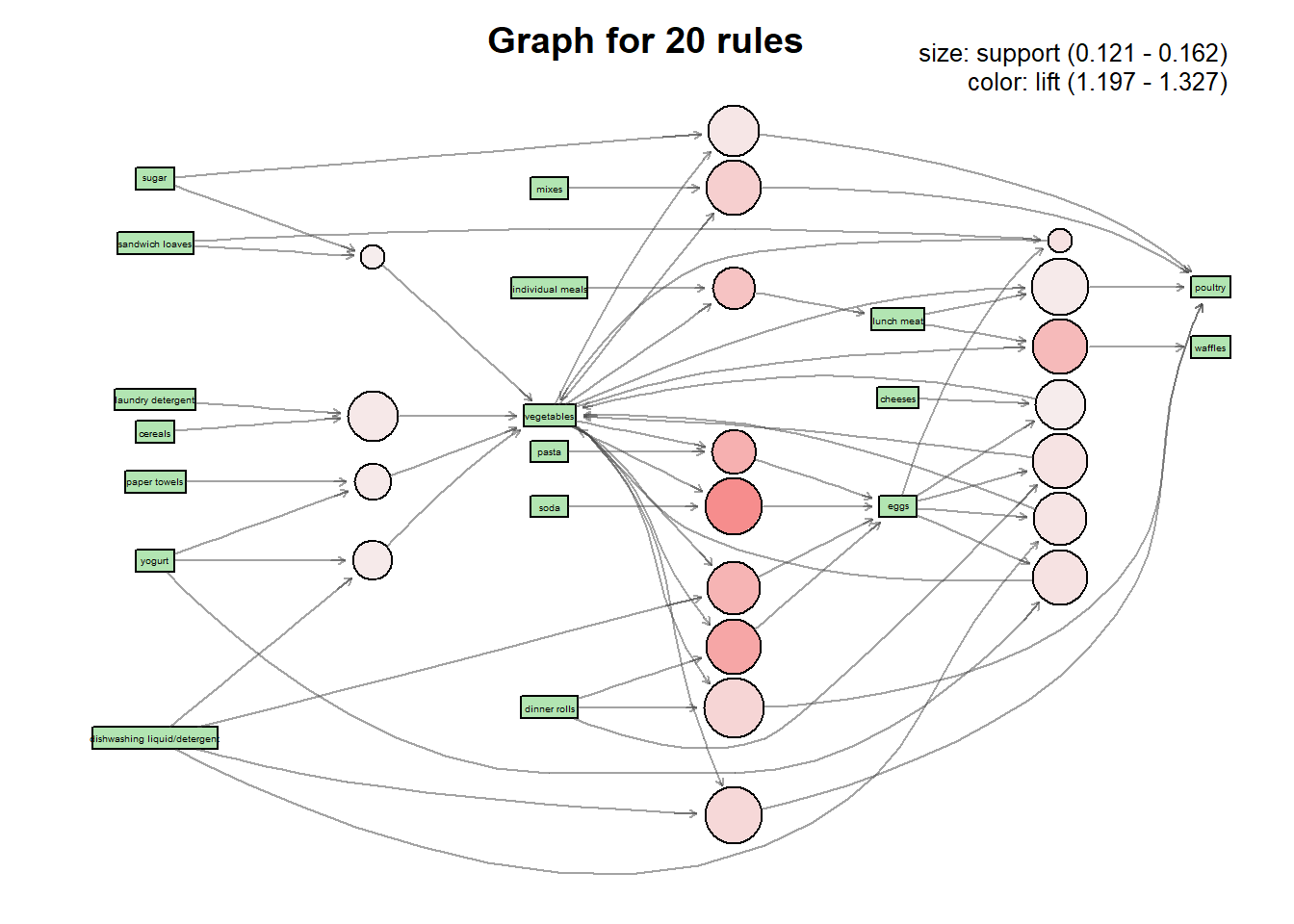

## [1] 11.45251## set of 634 rules- Dibuja las reglas ordenadas y no redundantes usando paquete arulesViz. Si son muchas visualiza las 20 primeras.

## lhs rhs support

## [1] {soda,vegetables} => {eggs} 0.1580334

## [2] {dinner rolls,vegetables} => {eggs} 0.1562774

## [3] {pasta,vegetables} => {eggs} 0.1439860

## [4] {dishwashing liquid/detergent,vegetables} => {eggs} 0.1536435

## [5] {lunch meat,vegetables} => {waffles} 0.1571554

## [6] {individual meals,vegetables} => {lunch meat} 0.1431080

## [7] {mixes,vegetables} => {poultry} 0.1562774

## [8] {dinner rolls,vegetables} => {poultry} 0.1615452

## [9] {dishwashing liquid/detergent,vegetables} => {poultry} 0.1597893

## [10] {eggs,sandwich loaves} => {vegetables} 0.1211589

## [11] {eggs,yogurt} => {vegetables} 0.1571554

## [12] {dinner rolls,eggs} => {vegetables} 0.1562774

## [13] {dishwashing liquid/detergent,eggs} => {vegetables} 0.1536435

## [14] {sugar,vegetables} => {poultry} 0.1518876

## [15] {cereals,laundry detergent} => {vegetables} 0.1510097

## [16] {paper towels,yogurt} => {vegetables} 0.1352063

## [17] {lunch meat,vegetables} => {poultry} 0.1580334

## [18] {dishwashing liquid/detergent,yogurt} => {vegetables} 0.1404741

## [19] {cheeses,eggs} => {vegetables} 0.1501317

## [20] {sandwich loaves,sugar} => {vegetables} 0.1211589

## confidence lift count

## [1] 0.5172414 1.326887 180

## [2] 0.5071225 1.300929 178

## [3] 0.5030675 1.290527 164

## [4] 0.5014327 1.286333 175

## [5] 0.5042254 1.279093 179

## [6] 0.5015385 1.269450 163

## [7] 0.5281899 1.253351 178

## [8] 0.5242165 1.243922 184

## [9] 0.5214900 1.237452 182

## [10] 0.9019608 1.220111 138

## [11] 0.8994975 1.216779 179

## [12] 0.8989899 1.216092 178

## [13] 0.8974359 1.213990 175

## [14] 0.5103245 1.210957 173

## [15] 0.8911917 1.205543 172

## [16] 0.8901734 1.204166 154

## [17] 0.5070423 1.203169 180

## [18] 0.8888889 1.202428 160

## [19] 0.8860104 1.198534 171

## [20] 0.8846154 1.196647 138

## Itemsets in Antecedent (LHS)

## [1] "{soda,vegetables}"

## [2] "{pasta,vegetables}"

## [3] "{dinner rolls,vegetables}"

## [4] "{individual meals,vegetables}"

## [5] "{dishwashing liquid/detergent,vegetables}"

## [6] "{mixes,vegetables}"

## [7] "{lunch meat,vegetables}"

## [8] "{eggs,sandwich loaves}"

## [9] "{eggs,yogurt}"

## [10] "{dinner rolls,eggs}"

## [11] "{dishwashing liquid/detergent,eggs}"

## [12] "{sugar,vegetables}"

## [13] "{cereals,laundry detergent}"

## [14] "{paper towels,yogurt}"

## [15] "{dishwashing liquid/detergent,yogurt}"

## [16] "{cheeses,eggs}"

## [17] "{sandwich loaves,sugar}"

## Itemsets in Consequent (RHS)

## [1] "{vegetables}" "{poultry}" "{lunch meat}" "{waffles}" "{eggs}"

## Itemsets in Antecedent (LHS)

## [1] "{soda,vegetables}"

## [2] "{dinner rolls,vegetables}"

## [3] "{pasta,vegetables}"

## [4] "{dishwashing liquid/detergent,vegetables}"

## [5] "{lunch meat,vegetables}"

## [6] "{individual meals,vegetables}"

## [7] "{mixes,vegetables}"

## [8] "{eggs,sandwich loaves}"

## [9] "{eggs,yogurt}"

## [10] "{dinner rolls,eggs}"

## [11] "{dishwashing liquid/detergent,eggs}"

## [12] "{sugar,vegetables}"

## [13] "{cereals,laundry detergent}"

## [14] "{paper towels,yogurt}"

## [15] "{dishwashing liquid/detergent,yogurt}"

## [16] "{cheeses,eggs}"

## [17] "{sandwich loaves,sugar}"

## Itemsets in Consequent (RHS)

## [1] "{eggs}" "{waffles}" "{lunch meat}" "{poultry}" "{vegetables}"

## Loading required namespace: Rgraphviz

# Visualizacion interactiva

# plot(subrules, method="graph", engine="htmlwidget")

# plot(subrules, method="graph", engine="htmlwidget", igraphLayout = "layout_in_circle")4.2 FCA

4.2.1 Introduccion a FCA (formal Concept Analysis)

Formal Concept Analysis es un método de análisis de datos, el cuál describe la relación entre un conjunto particular de objetos y un conjunto particular de atributos. FCA genera dos tipos de salidas o ejecuciones a partir de los datos de entrada.

El primer tipo de salida es un retículo de conceptos, el cuál es una colección de conceptos formales que son ordenados jerarquicamente por la relación subconcepto y superconcepto (Al igual que en álgebra hablamos de infimos y supremos).

El segundo tipo de salida consiste en formulas, llamadas implicaciones de atributo, las cuales describen dependencias de atributos concretos que son TRUE en la tabla de datos.

Estas definiciones pertencen a los apuntes de Gerd Stumme suministrados en el campus.

FCA models concepts as units of thought, consisting of two parts:

- The extension consists of all objects belonging to the concept.

- The intension consists of all attributes common to all those objects.

FCA is used for data analysis, information retrieval, and knowledge discovery.

FCA can be understood as conceptual clustering method, which clusters simultanously objects and their descriptions.

FCA can also be used for efficiently computing association rules.

4.2.2 Ejercicio fcaR - tutorialGanter - 1ra parte

- Importar el dataset contextformal_tutorialGanter.csv que se encuentra en CV en variable dataset_ganter

- Los nombres de las filas te aparece como primera columna. Si esto es así, traslada el nombre de las filas a la variable rownames(dataset_ganter)

rownames(dataset_ganter) <- dataset_ganter[,1]

# Eliminamos la primera columna

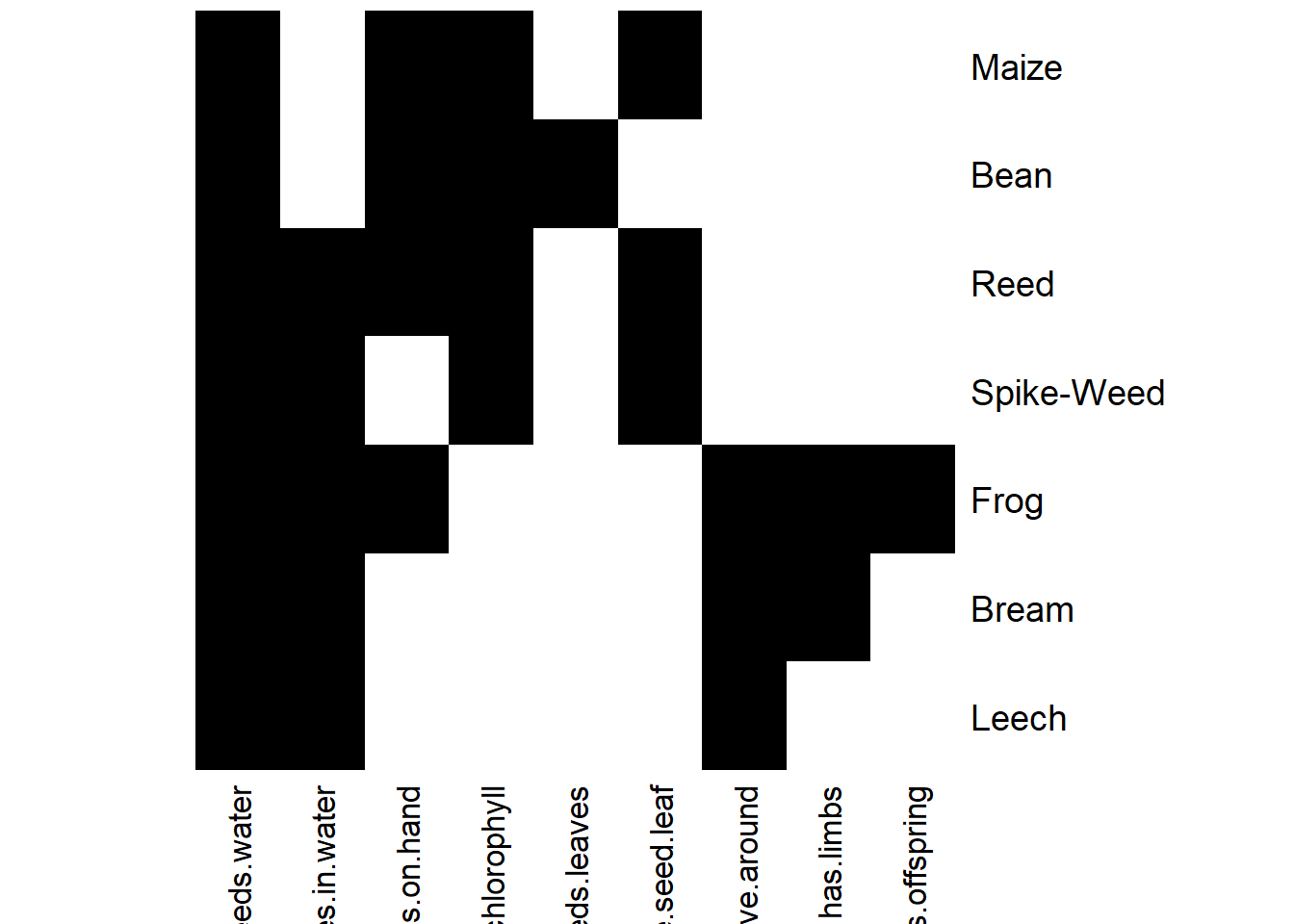

dataset_ganter <- dataset_ganter[,-1]- Introduce el dataset anterior en un contexto formal de nombre fc_ganter usando el paquete fcaR Imprime el contexto formal (print). Haz plot también del contexto formal.

## Warning: Too many attributes, output will be truncated.## FormalContext with 7 objects and 9 attributes.

## Attributes' names are: needs.water, lives.in.water, lives.on.hand,

## needs.chlorophyll, two.seeds.leaves, one.seed.leaf, ...

## Matrix:

## needs.water lives.in.water lives.on.hand needs.chlorophyll

## Leech 1 1 0 0

## Bream 1 1 0 0

## Frog 1 1 1 0

## Spike-Weed 1 1 0 1

## Reed 1 1 1 1

## Bean 1 0 1 1

## two.seeds.leaves one.seed.leaf can.move.around

## Leech 0 0 1

## Bream 0 0 1

## Frog 0 0 1

## Spike-Weed 0 1 0

## Reed 0 1 0

## Bean 1 0 0

- Convierte a latex el contexto formal. En el Rmd introduce el código latex del contexto formal para visualizarlo.

## \begin{table} \centering

## \begin{tabular}{lrrrrrrrrr}

## \toprule

## & needs.water & lives.in.water & lives.on.hand & needs.chlorophyll & two.seeds.leaves & one.seed.leaf & can.move.around & has.limbs & suckles.its.offspring\\

## \midrule

## Leech & 1 & 1 & 0 & 0 & 0 & 0 & 1 & 0 & 0\\

## Bream & 1 & 1 & 0 & 0 & 0 & 0 & 1 & 1 & 0\\

## Frog & 1 & 1 & 1 & 0 & 0 & 0 & 1 & 1 & 1\\

## Spike-Weed & 1 & 1 & 0 & 1 & 0 & 1 & 0 & 0 & 0\\

## Reed & 1 & 1 & 1 & 1 & 0 & 1 & 0 & 0 & 0\\

## Bean & 1 & 0 & 1 & 1 & 1 & 0 & 0 & 0 & 0\\

## Maize & 1 & 0 & 1 & 1 & 0 & 1 & 0 & 0 & 0\\

## \bottomrule

## \end{tabular} \caption{\label{}} \end{table}- Guarda todos los atributos en una variable attr_ganter usando los comandos del paquete fcaR. Guarda todos los objetos en una variable obj_ganter usando los comandos del paquete fcaR.

- ¿De que tipo es la variable attr_ganter?

## [1] "character"## chr [1:9] "needs.water" "lives.in.water" "lives.on.hand" ...- ¿De que tipo es la variable attr_objetos?

## [1] "character"## chr [1:7] "Leech" "Bream" "Frog" "Spike-Weed" "Reed" "Bean" "Maize"- Visualizando el contexto formal y utilizando los operadores de derivación, calcula dos conceptos sin usar el método que calcula todos los conceptos.

# Definimos un set de objetos

S <- SparseSet$new(attributes = fc_ganter$objects)

S$assign(Frog = 1) # Asignamos 1 al objeto frog

S## {Frog}# Computamos el intent del conjunto, obteniendo los atributos que cumple el objeto frog

fc_ganter$intent(S)## {needs.water, lives.in.water, lives.on.hand, can.move.around, has.limbs,

## suckles.its.offspring}# Definimos un set de atributos

D <- SparseSet$new(attributes = fc_ganter$attributes)

D$assign(needs.water = 1, lives.in.water = 1) # Asignamos 1 a los atributos especificados

D## {needs.water, lives.in.water}# Calculamos el extent del conjunto, obteniendo los objetos que poseen dichas propiedades

fc_ganter$extent(D)## {Leech, Bream, Frog, Spike-Weed, Reed}- Usar método de fcaR para calcular todos los conceptos.

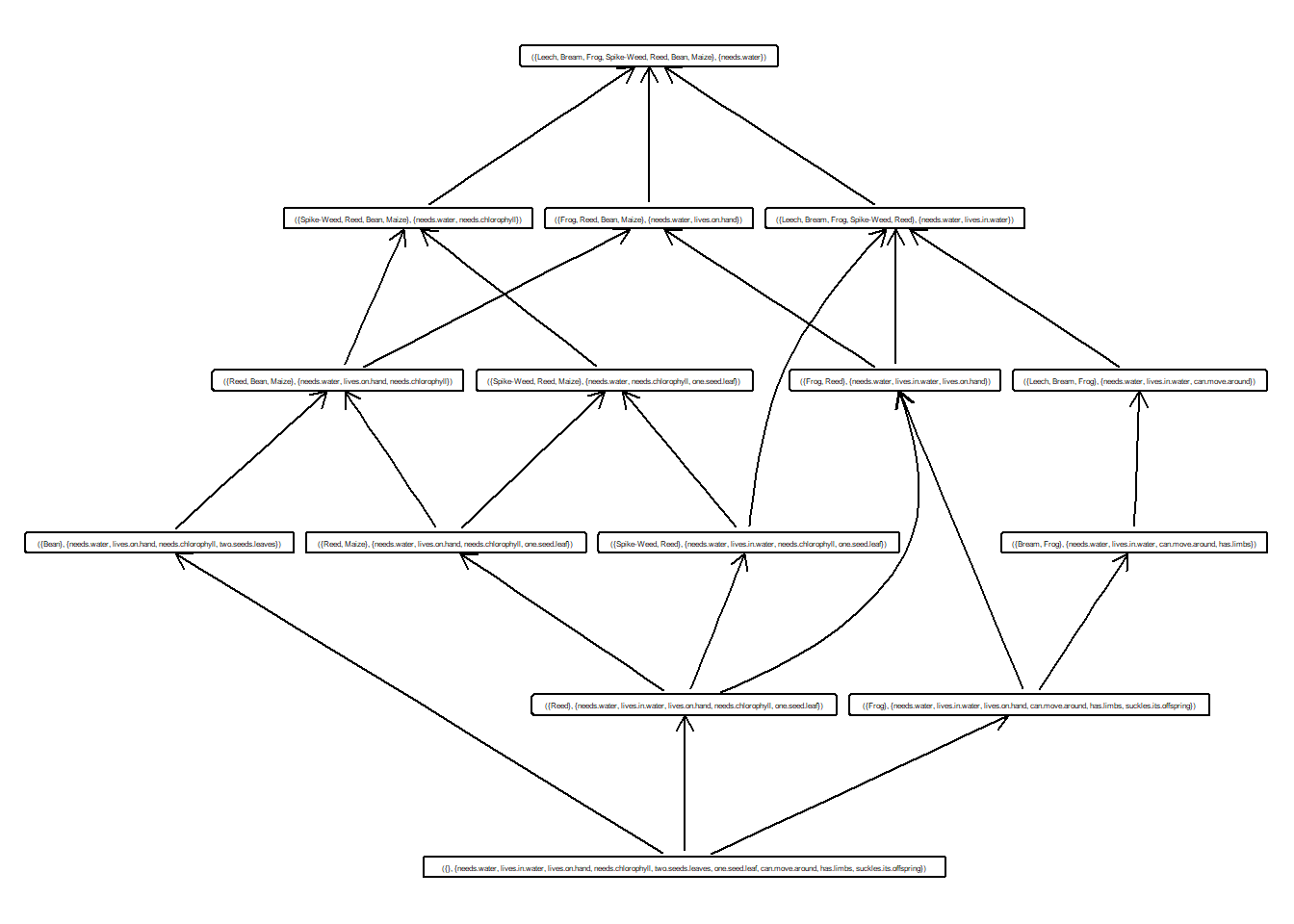

# Hacemos uso de la funcion find_implications, la cual extrae las bases canónicas de las implicaciones y el reticulo de conceptos

fc_ganter$find_implications()- ¿Cuantos conceptos hemos calculado a partir del contexto formal?

## [1] 15- Muestra los 10 primeros conceptos.

## ({Leech, Bream, Frog, Spike-Weed, Reed, Bean, Maize}, {needs.water})

## ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})

## ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## ({Frog, Reed, Bean, Maize}, {needs.water, lives.on.hand})

## ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})

## ({Reed, Maize}, {needs.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## ({Bean}, {needs.water, lives.on.hand, needs.chlorophyll, two.seeds.leaves})

## ({Leech, Bream, Frog, Spike-Weed, Reed}, {needs.water, lives.in.water})

## ({Leech, Bream, Frog}, {needs.water, lives.in.water, can.move.around})

## ({Bream, Frog}, {needs.water, lives.in.water, can.move.around, has.limbs})- Dibuja el retículo de conceptos

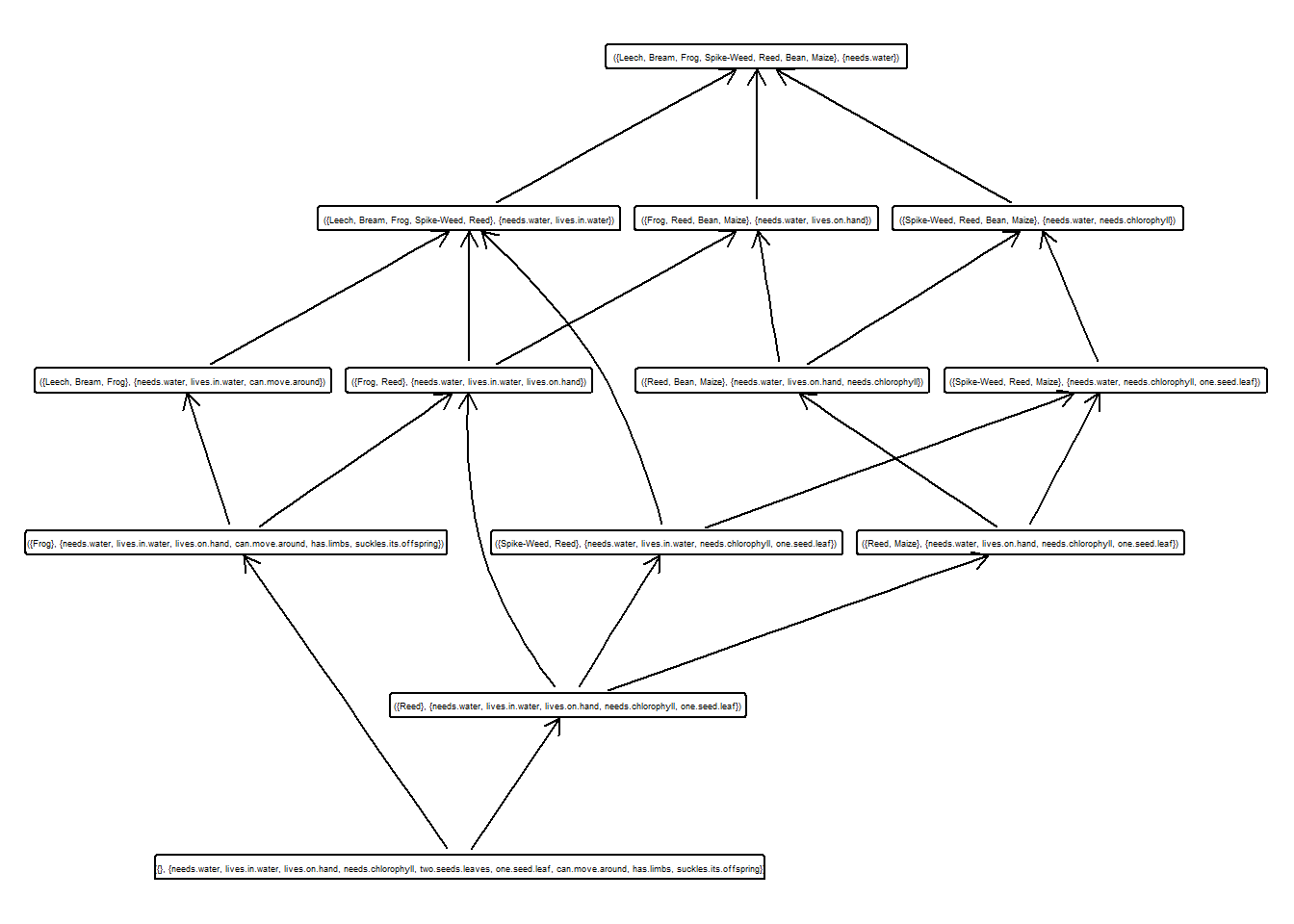

- Calcular y guardar en una variable el subretículo con soporte mayor que 0.3.

idx <- which(fc_ganter$concepts$support() > 0.3)

sublattice <- fc_ganter$concepts$sublattice(idx)

sublattice## A set of 13 concepts:

## 1: ({Leech, Bream, Frog, Spike-Weed, Reed, Bean, Maize}, {needs.water})

## 2: ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})

## 3: ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## 4: ({Frog, Reed, Bean, Maize}, {needs.water, lives.on.hand})

## 5: ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})

## 6: ({Reed, Maize}, {needs.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## 7: ({Leech, Bream, Frog, Spike-Weed, Reed}, {needs.water, lives.in.water})

## 8: ({Leech, Bream, Frog}, {needs.water, lives.in.water, can.move.around})

## 9: ({Spike-Weed, Reed}, {needs.water, lives.in.water, needs.chlorophyll, one.seed.leaf})

## 10: ({Frog, Reed}, {needs.water, lives.in.water, lives.on.hand})

## 11: ({Frog}, {needs.water, lives.in.water, lives.on.hand, can.move.around, has.limbs, suckles.its.offspring})

## 12: ({Reed}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## 13: ({}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll, two.seeds.leaves, one.seed.leaf, can.move.around, has.limbs, suckles.its.offspring})- Dibujar dicho subretículo

- ¿De que tipo es el subretículo obtenido?

## [1] "ConceptLattice" "R6"- ¿Qué metodos puedes usar con el subretículo calculado? Pon ejemplos y explica.

# clone --> Los objetos del tipo reticulo son clonables haciendo uso de este metodo

# extents --> Devuelve los extent de todos los conceptos en forma de dgCMatrix

sublattice$extents()## 7 x 13 sparse Matrix of class "dgCMatrix"

##

## [1,] 1 . . . . . 1 1 . . . . .

## [2,] 1 . . . . . 1 1 . . . . .

## [3,] 1 . . 1 . . 1 1 . 1 1 . .

## [4,] 1 1 1 . . . 1 . 1 . . . .

## [5,] 1 1 1 1 1 1 1 . 1 1 . 1 .

## [6,] 1 1 . 1 1 . . . . . . . .

## [7,] 1 1 1 1 1 1 . . . . . . .# infimum --> Devuelve el infimo de la lista de conceptos que se pase como argumento

# intents --> Devuelve los intents de todos los conceptos en forma de dgCMAtrix

sublattice$intents()## 9 x 13 sparse Matrix of class "dgCMatrix"

##

## [1,] 1 1 1 1 1 1 1 1 1 1 1 1 1

## [2,] . . . . . . 1 1 1 1 1 1 1

## [3,] . . . 1 1 1 . . . 1 1 1 1

## [4,] . 1 1 . 1 1 . . 1 . . 1 1

## [5,] . . . . . . . . . . . . 1

## [6,] . . 1 . . 1 . . 1 . . 1 1

## [7,] . . . . . . . 1 . . 1 . 1

## [8,] . . . . . . . . . . 1 . 1

## [9,] . . . . . . . . . . 1 . 1# is_empty --> Devuelve un booleano al comprobar si el reticulo tiene o no conceptos

sublattice$is_empty()## [1] FALSE# join_irreducibles --> Devuelve los elementos join-irreducibles del reticulo

sublattice$join_irreducibles()## ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})

## ({Reed, Maize}, {needs.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## ({Leech, Bream, Frog}, {needs.water, lives.in.water, can.move.around})

## ({Spike-Weed, Reed}, {needs.water, lives.in.water, needs.chlorophyll, one.seed.leaf})

## ({Frog}, {needs.water, lives.in.water, lives.on.hand, can.move.around, has.limbs,

## suckles.its.offspring})

## ({Reed}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll,

## one.seed.leaf})# lower_neighbours --> Devuelve una lista con los vecinos inferiores del concepto que se pase como argumento

sublattice$lower_neighbours(sublattice[2])## ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})# meet_irreducibles --> Devuelve los elementos meet-irreducibles del reticulo

sublattice$meet_irreducibles()## ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})

## ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## ({Frog, Reed, Bean, Maize}, {needs.water, lives.on.hand})

## ({Leech, Bream, Frog, Spike-Weed, Reed}, {needs.water, lives.in.water})

## ({Leech, Bream, Frog}, {needs.water, lives.in.water, can.move.around})# plot --> Para representar el reticulo

# print --> Para imprimir el contexto formal

sublattice$print()## A set of 13 concepts:

## 1: ({Leech, Bream, Frog, Spike-Weed, Reed, Bean, Maize}, {needs.water})

## 2: ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})

## 3: ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## 4: ({Frog, Reed, Bean, Maize}, {needs.water, lives.on.hand})

## 5: ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})

## 6: ({Reed, Maize}, {needs.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## 7: ({Leech, Bream, Frog, Spike-Weed, Reed}, {needs.water, lives.in.water})

## 8: ({Leech, Bream, Frog}, {needs.water, lives.in.water, can.move.around})

## 9: ({Spike-Weed, Reed}, {needs.water, lives.in.water, needs.chlorophyll, one.seed.leaf})

## 10: ({Frog, Reed}, {needs.water, lives.in.water, lives.on.hand})

## 11: ({Frog}, {needs.water, lives.in.water, lives.on.hand, can.move.around, has.limbs, suckles.its.offspring})

## 12: ({Reed}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## 13: ({}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll, two.seeds.leaves, one.seed.leaf, can.move.around, has.limbs, suckles.its.offspring})## [1] 13# subconcepts --> Podemos calcular subconceptos de un concepto que se le pase como argumento

sublattice$subconcepts(sublattice[2])## ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})

## ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})

## ({Reed, Bean, Maize}, {needs.water, lives.on.hand, needs.chlorophyll})

## ({Reed, Maize}, {needs.water, lives.on.hand, needs.chlorophyll, one.seed.leaf})

## ({Spike-Weed, Reed}, {needs.water, lives.in.water, needs.chlorophyll, one.seed.leaf})

## ({Reed}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll,

## one.seed.leaf})

## ({}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll,

## two.seeds.leaves, one.seed.leaf, can.move.around, has.limbs,

## suckles.its.offspring})# sublattice --> Podemos obtener un nuevo subreticulo a partir del actual

# superconcepts --> Devuelve una lista con los superconceptos

sublattice$superconcepts(sublattice[2])## ({Leech, Bream, Frog, Spike-Weed, Reed, Bean, Maize}, {needs.water})

## ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})## [1] 1.0000000 0.5714286 0.4285714 0.5714286 0.4285714 0.2857143 0.7142857

## [8] 0.4285714 0.2857143 0.2857143 0.1428571 0.1428571 0.0000000# supremum --> Devuelve el supremo de la lista de conceptos que se pase como argumento

# to_latex --> Convertir el contexto formal en codigo latex

sublattice$to_latex()## \begin{longtable}{lll}

## 1: &$\left(\,\ensuremath{\{Leech,\, Bream,\, Frog,\, Spike-Weed,\, Reed,\, Bean,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water\}}\,\right)$\\

## 2: &$\left(\,\ensuremath{\{Spike-Weed,\, Reed,\, Bean,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water,\, needs.chlorophyll\}}\,\right)$\\

## 3: &$\left(\,\ensuremath{\{Spike-Weed,\, Reed,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water,\, needs.chlorophyll,\, one.seed.leaf\}}\,\right)$\\

## 4: &$\left(\,\ensuremath{\{Frog,\, Reed,\, Bean,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.on.hand\}}\,\right)$\\

## 5: &$\left(\,\ensuremath{\{Reed,\, Bean,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.on.hand,\, needs.chlorophyll\}}\,\right)$\\

## 6: &$\left(\,\ensuremath{\{Reed,\, Maize\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.on.hand,\, needs.chlorophyll,\, one.seed.leaf\}}\,\right)$\\

## 7: &$\left(\,\ensuremath{\{Leech,\, Bream,\, Frog,\, Spike-Weed,\, Reed\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water\}}\,\right)$\\

## 8: &$\left(\,\ensuremath{\{Leech,\, Bream,\, Frog\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, can.move.around\}}\,\right)$\\

## 9: &$\left(\,\ensuremath{\{Spike-Weed,\, Reed\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, needs.chlorophyll,\, one.seed.leaf\}}\,\right)$\\

## 10: &$\left(\,\ensuremath{\{Frog,\, Reed\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, lives.on.hand\}}\,\right)$\\

## 11: &$\left(\,\ensuremath{\{Frog\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, lives.on.hand,\, can.move.around,\, has.limbs,\, suckles.its.offspring\}}\,\right)$\\

## 12: &$\left(\,\ensuremath{\{Reed\}},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, lives.on.hand,\, needs.chlorophyll,\, one.seed.leaf\}}\,\right)$\\

## 13: &$\left(\,\ensuremath{\varnothing},\right.$&$\left.\ensuremath{\{needs.water,\, lives.in.water,\, lives.on.hand,\, needs.chlorophyll,\, two.seeds.leaves,\, one.seed.leaf,\, can.move.around,\, has.limbs,\, suckles.its.offspring\}}\,\right)$\\

## \end{longtable}# upper_neighbours --> Devuelve una lista con los vecinos superiores del concepto que se pase como argumento

sublattice$upper_neighbours(sublattice[2])## ({Leech, Bream, Frog, Spike-Weed, Reed, Bean, Maize}, {needs.water})Para hacer luego con más tiempo: busca información en los tutoriales, o en internet acerca de la definición de soporte de un concepto.

Calcula el superior y el infimo de los conceptos calculados para fc_ganter y lo mismo para el subretículo anterior. Visualizalos.

## ({Bream, Frog}, {needs.water, lives.in.water, can.move.around, has.limbs})

## ({Spike-Weed, Reed}, {needs.water, lives.in.water, needs.chlorophyll, one.seed.leaf})

## ({Frog, Reed}, {needs.water, lives.in.water, lives.on.hand})## ({Leech, Bream, Frog, Spike-Weed, Reed}, {needs.water, lives.in.water})## ({}, {needs.water, lives.in.water, lives.on.hand, needs.chlorophyll,

## two.seeds.leaves, one.seed.leaf, can.move.around, has.limbs,

## suckles.its.offspring})## ({Spike-Weed, Reed, Bean, Maize}, {needs.water, needs.chlorophyll})## ({Spike-Weed, Reed, Maize}, {needs.water, needs.chlorophyll, one.seed.leaf})- Grabar el objeto fc_ganter en un fichero fc_ganter.rds.

- Elimina la variable fc_ganter. Carga otra vez en la variable del fichero anterior y comprueba que tenemos toda la información: atributos, conceptos, etc.

Calcula lo siguientes conjuntos usando los métodos del paquete fcaR:

{Bean}′

{livesonland}′

{twoseedleaves}′

{Frog,Maize}′

{needschlorophylltoproducefood,canmovearound}′

{livesinwater,livesonland}′

{needschlorophylltoproducefood,canmovearound}′

## {needs.water, lives.on.hand, needs.chlorophyll, two.seeds.leaves}# {livesonland}′

# En la tabla tenemos lives on hand, en lugar de lives on land

c2 <- SparseSet$new(fc_ganter2$attributes)

c2$assign(lives.on.hand = 1)

fc_ganter2$extent(c2)## {Frog, Reed, Bean, Maize}# {twoseedleaves}′

c3 <- SparseSet$new(fc_ganter2$attributes)

c3$assign(two.seeds.leaves = 1)

fc_ganter2$extent(c3)## {Bean}# {Frog,Maize}′

c4 <- SparseSet$new(fc_ganter2$objects)

c4$assign(Frog = 1, Maize = 1)

fc_ganter2$intent(c4)## {needs.water, lives.on.hand}# {needschlorophylltoproducefood,canmovearound}′

c5 <- SparseSet$new(fc_ganter2$attributes)

c5$assign(needs.chlorophyll = 1, can.move.around = 1)

fc_ganter2$extent(c5)## {}# {livesinwater,livesonland}′

c6 <- SparseSet$new(fc_ganter2$attributes)

c6$assign(lives.in.water = 1, lives.on.hand = 1)

fc_ganter2$extent(c6)## {Frog, Reed}4.2.3 Ejercicio Tutorial Ganter - 2da parte

Segunda parte, clase 06/05/20

- Calcula las implicaciones del contexto

library('fcaR')

library(arules)

# Recueramos los datos de fc_ganter que previamente se habian eliminado

fc_ganter <- FormalContext$new()

fc_ganter$load("fc_ganter.rds")

# Compute implications

fc_ganter$find_implications(verbose = FALSE)- Muestra las implicaciones en pantalla

## Implication set with 10 implications.

## Rule 1: {} -> {needs.water}

## Rule 2: {needs.water, suckles.its.offspring} -> {lives.in.water,

## lives.on.hand, can.move.around, has.limbs}

## Rule 3: {needs.water, has.limbs} -> {lives.in.water, can.move.around}

## Rule 4: {needs.water, can.move.around} -> {lives.in.water}

## Rule 5: {needs.water, one.seed.leaf} -> {needs.chlorophyll}

## Rule 6: {needs.water, two.seeds.leaves} -> {lives.on.hand,

## needs.chlorophyll}

## Rule 7: {needs.water, lives.on.hand, needs.chlorophyll,

## two.seeds.leaves, one.seed.leaf} -> {lives.in.water, can.move.around,

## has.limbs, suckles.its.offspring}

## Rule 8: {needs.water, lives.in.water, needs.chlorophyll} ->

## {one.seed.leaf}

## Rule 9: {needs.water, lives.in.water, needs.chlorophyll,

## one.seed.leaf, can.move.around} -> {lives.on.hand, two.seeds.leaves,

## has.limbs, suckles.its.offspring}

## Rule 10: {needs.water, lives.in.water, lives.on.hand, can.move.around}

## -> {has.limbs, suckles.its.offspring}- ¿Cuantas implicaciones se han extraido?

## [1] 10- Calcula el tamaño de las implicaciones y la media de la parte y derecha de dichas implicaciones.

## LHS RHS

## 2.7 2.2- Aplica las reglas de la lógica de simplificación. ¿Cuantas implicaciones han aparecido tras aplicar la lógica?

## Processing batch## --> simplification: from 10 to 10 in 0.05 secs.## Batch took 0.05 secs.## [1] 10## Implication set with 10 implications.

## Rule 1: {} -> {needs.water}

## Rule 2: {suckles.its.offspring} -> {lives.in.water, lives.on.hand,

## can.move.around, has.limbs}

## Rule 3: {has.limbs} -> {lives.in.water, can.move.around}

## Rule 4: {can.move.around} -> {lives.in.water}

## Rule 5: {one.seed.leaf} -> {needs.chlorophyll}

## Rule 6: {two.seeds.leaves} -> {lives.on.hand, needs.chlorophyll}

## Rule 7: {two.seeds.leaves, one.seed.leaf} -> {lives.in.water,

## can.move.around, has.limbs, suckles.its.offspring}

## Rule 8: {lives.in.water, needs.chlorophyll} -> {one.seed.leaf}

## Rule 9: {one.seed.leaf, can.move.around} -> {lives.on.hand,

## two.seeds.leaves, has.limbs, suckles.its.offspring}

## Rule 10: {lives.on.hand, can.move.around} -> {has.limbs,

## suckles.its.offspring}- Eliminar la redundancia en el conjunto de implicaciones. ¿Cuantas implicaciones han aparecido tras aplicar la lógica?

fc_ganter$implications$apply_rules(rules = c("composition",

"generalization",

"simplification"), parallelize = FALSE)## Processing batch## --> composition: from 10 to 10 in 0 secs.## --> generalization: from 10 to 10 in 0.02 secs.## --> simplification: from 10 to 10 in 0.03 secs.## Batch took 0.05 secs.## Implication set with 10 implications.

## Rule 1: {} -> {needs.water}

## Rule 2: {suckles.its.offspring} -> {lives.in.water, lives.on.hand,

## can.move.around, has.limbs}

## Rule 3: {has.limbs} -> {lives.in.water, can.move.around}

## Rule 4: {can.move.around} -> {lives.in.water}

## Rule 5: {one.seed.leaf} -> {needs.chlorophyll}

## Rule 6: {two.seeds.leaves} -> {lives.on.hand, needs.chlorophyll}

## Rule 7: {two.seeds.leaves, one.seed.leaf} -> {lives.in.water,

## can.move.around, has.limbs, suckles.its.offspring}

## Rule 8: {lives.in.water, needs.chlorophyll} -> {one.seed.leaf}

## Rule 9: {one.seed.leaf, can.move.around} -> {lives.on.hand,

## two.seeds.leaves, has.limbs, suckles.its.offspring}

## Rule 10: {lives.on.hand, can.move.around} -> {has.limbs,

## suckles.its.offspring}## [1] 10- Calcular el cierre de los atributos needs.water, one.seed.leaf.

S <- SparseSet$new(attributes = fc_ganter$attributes)

S$assign("needs.water" = 1, "one.seed.leaf"=1)

S## {needs.water, one.seed.leaf}## $closure

## {needs.water, needs.chlorophyll, one.seed.leaf}- Copia (clona) el conjunto fc_ganter en una variable fc1.

## Warning: Too many attributes, output will be truncated.## FormalContext with 7 objects and 9 attributes.

## Attributes' names are: needs.water, lives.in.water, lives.on.hand,

## needs.chlorophyll, two.seeds.leaves, one.seed.leaf, ...

## Matrix:

## needs.water lives.in.water lives.on.hand needs.chlorophyll

## Leech 1 1 0 0

## Bream 1 1 0 0

## Frog 1 1 1 0

## Spike-Weed 1 1 0 1

## Reed 1 1 1 1

## Bean 1 0 1 1

## two.seeds.leaves one.seed.leaf can.move.around

## Leech 0 0 1

## Bream 0 0 1

## Frog 0 0 1

## Spike-Weed 0 1 0

## Reed 0 1 0

## Bean 1 0 0

- Elimina la implicación que está en la primera posición:

# Este comando elimina la primera, como en arules

fc1$implications <- fc1$implications[-1]

fc1$implications## Implication set with 9 implications.

## Rule 1: {suckles.its.offspring} -> {lives.in.water, lives.on.hand,

## can.move.around, has.limbs}

## Rule 2: {has.limbs} -> {lives.in.water, can.move.around}

## Rule 3: {can.move.around} -> {lives.in.water}

## Rule 4: {one.seed.leaf} -> {needs.chlorophyll}

## Rule 5: {two.seeds.leaves} -> {lives.on.hand, needs.chlorophyll}

## Rule 6: {two.seeds.leaves, one.seed.leaf} -> {lives.in.water,

## can.move.around, has.limbs, suckles.its.offspring}

## Rule 7: {lives.in.water, needs.chlorophyll} -> {one.seed.leaf}

## Rule 8: {one.seed.leaf, can.move.around} -> {lives.on.hand,

## two.seeds.leaves, has.limbs, suckles.its.offspring}

## Rule 9: {lives.on.hand, can.move.around} -> {has.limbs,

## suckles.its.offspring}- Extrae de todas las implicaciones la que tengan en el lado izquierdo de la implicación el atributo one.seed.leaf.

# Siguiendo las especificaciones del paquete fcaR, el uso de filter es el siguiente

imp <- fc1$implications$filter(lhs = "one.seed.leaf")

imp## Implication set with 3 implications.

## Rule 1: {one.seed.leaf} -> {needs.chlorophyll}

## Rule 2: {two.seeds.leaves, one.seed.leaf} -> {lives.in.water,

## can.move.around, has.limbs, suckles.its.offspring}