1 Preguntas y respuestas - Entrevistas para posiciones de Data Scientist

En este apartado voy a ir tratando de responder a las distintas preguntas que voy recopilando en esta Google sheet.

Las distintas preguntas las he ido dividiendo en temas y subtemas (‘Estadística’, ‘Creación de modelos’, ‘Programación’, etc.). Obviamente muchas veces los límites entre estos no están claros y una pregunta puede perfectamente pertenecer a dos o tres temáticas al mismo tiempo.

Mi objetivo es responder de forma sencilla y breve a las preguntas planteadas. Y siempre que sea posible asociar la respuesta teórica a un ejemplo práctico para que el entrevistador perciba que además de conocer los fundamentos teóricos somos capaces de relacionar estos con casos reales de uso.

Para más detalle dejaré referencias en cada una de las respuestas donde podremos profundizar en cada uno de los temas planteados.

1.1 Estadística

¿Qué es el Teorema Central del Límite?

La web de soporte de Minitab tiene una muy buena explicación del Teorema Central del Límite:

“El teorema del límite central es un teorema fundamental de probabilidad y estadística. El teorema describe la distribución de la media de una muestra aleatoria proveniente de una población con varianza finita. Cuando el tamaño de la muestra es lo suficientemente grande, la distribución de las medias sigue aproximadamente una distribución normal. El teorema se aplica independientemente de la forma de la distribución de la población. Muchos procedimientos estadísticos comunes requieren que los datos sean aproximadamente normales. El teorema de límite central le permite aplicar estos procedimientos útiles a poblaciones que son considerablemente no normales. El tamaño que debe tener la muestra depende de la forma de la distribución original. Si la distribución de la población es simétrica, un tamaño de muestra de 5 podría producir una aproximación adecuada. Si la distribución de la población es considerablemente asimétrica, es necesario un tamaño de muestra más grande. Por ejemplo, la distribución de la media puede ser aproximadamente normal si el tamaño de la muestra es mayor que 50.”

Un par de artículos muy interesantes que ayudan a entender el concepto y sus aplicaciones prácticas:

Understanding The Central Limit Theorem. Blog “Towards Data Science”.

[The central limit theorem and the law of large numbers: The gganimate package in action].(https://beta.rstudioconnect.com/kamermanpr/central-limit-n-large-numbers/central-limit-n-large-numbers.html)

¿Qué es el p-valor?

El P-valor es utilizado para el contraste de hipótesis. En un contraste de hipótesis rechazaremos la hipótesis nula si el p-valor es menor que el nivel de significancia, \(\alpha\), que suele fijarse en 0,05. Si el p-valor es igual o mayor no podremos rechazar la hipótesis nula \(H_0\).

El p-valor se podría definir como la probabilidad de que asumiendo la hipótesis nula como cierta (no existen diferencias entre los grupos) obtener un resultado igual o más extremo que el realmente observado. El p-valor sería la probabilidad de que las diferencias observadas entre los grupos sean debidas al azar.

Artículo de la wikipedia sobre el p-valor

¿Qué es la desviación típica?

La desviación típica es un indicador estadístico que nos informa sobre la variación o dispersión de una muestra de datos respecto a su media aritmética. Cuanto mayor es el valor de la desviación estándar mayor será la dispersión respecto a la media y viceversa.

Fórmula de la desviación típica (muestra de una población):

s = \(\sqrt{\frac{1}{N-1} \sum_{i=1}^N (x_i - \mu)^2}\)

Artículo de la wikipedia sobre la desviación típica

Definición de correlación.

La correlación describe la fuerza de la relación lineal existente entre dos variables y toma valores entre -1 y 1. Se denota como R.

Si la correlación es fuerte y positiva tomará valores cercanos a +1, si es fuerte pero negativa estará próxima a -1.

Solamente cuando la relación entre las variables es perfectamente lineal tendremos valores de correlación iguales a +1 o -1. Por ello es conveniente ser siempre prudente al interpretar el nivel de correlación entre dos variables (así como los resultados de otros estadísticos descriptivos).

Sobre las limitaciones del índice de correlación y otros estadísticos a la hora de interpretar conjuntos de datos es realmente interesante esta publicación: “Same Stats, Different Graphs: Generating Datasets with Varied Appearance and Identical Statistics through Simulated Annealing”.

Antes de confiar en los principales estadísticos de una distribución hay que echar un vistazo a la distribución en sí.

Y este sitio para jugar un poco a adivinar la correlación entre dos variables es genial Guess the correlation.

¿Qué es el coeficiente de correlación o R cuadrado?

1.2 Creación de modelos

¿Qué es el Machine Learning (o Aprendizaje Automático)

Diferencias entre el aprendizaje supervisado y no supervisado.

¿En qué se diferencian los algoritmos K-vecinos (k-NN) y K-medias (K-means)?

Al analizar un conjunto de datos ¿cómo tratarías los valores faltantes?

¿Para qué utilizarías un algoritmo de clustering? ¿Qué aplicaciones prácticas tiene?

Explica a qué se refieren los términos “precision” y “recall”. ¿De qué forma están relacionados con la curva ROC

Los términos “precision” y “recall” son métricas que nos sirven para evaluar la bondad de un modelo de clasificación. Otras métricas utilizadas para este objetivo serían, por ejemplo, la “accuracy” y el F-Score.

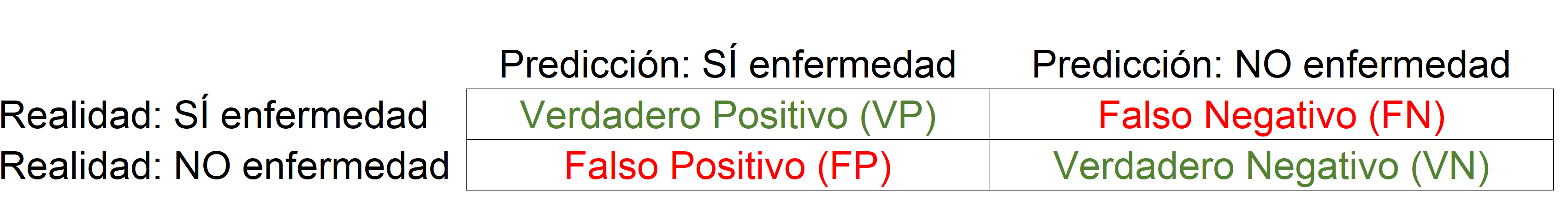

Para explicar el significado de cada una de estas métricas se suele partir de un problema de clasificación de tipo binario. Imaginemos los resultados de un análisis para intentar detectar una enfermedad. El término “Positivo” lo asociaremos a que el paciente SÍ tiene la enfermedad y el término “Negativo” a que NO la tiene. De un proceso de este tipo podemos esperar cuatro clases de resultados diferentes:

- VN / Verdadero Negativo: caso en el que el paciente no presente la enfermedad y el resultado del análisis también sea negativo.

- VP / Verdadero Positivo: caso en el que el paciente sí presente la enfermedad y el resultado del análisis también sea positivo.

- FN / Falso Negativo: caso en el que el paciente sí presente la enfermedad pero el resultado del análisis sea negativo.

- FP / Falso Positivo: caso en el que el paciente no presente la enfermedad pero el resultado del análisis sea positivo.

Todas estas posibilidades se suelen representar en la siguiente tabla, llamada “Matriz de confusión” o “Matriz de contingencia”:

“Tabla de contingencia - Resultados análisis enfermedad”.

La definición de las métricas serían las siguientes:

Accuracy: Ratio de predicciones correctas sobre el total de predicciones.

accuracy = (TP + TN)/(TP + TN + FP + FN)

Precision: Porcentaje de acierto cuando el modelo predice un resultado positivo.

precision = TP / (TP + FP)

Recall: Porcentaje de acierto para todos los casos positivos.

recall = TP / (TP + FN)

F-Score: Indicador único para resumir el rendimiento del clasificador.

F = 2 (precisionrecall/(precision + recall))

La Curva ROC está formada por los puntos resultantes del cruce de los distintos ratios de verdaderos positivos (eje y; “precision”) contra los distintos ratios de falsos positivos (eje x) para distintos umbrales, o donde el modelo establece que una observación es positiva o negativa (Ejemplo: si > 0,8 entonces clasificar como positivo). La mejor posible área bajo la curva ROC (AUC) es 1, mientras que un clasificador totalmente random haría coincidir la curva ROC con la diagonal, dejando un área por debajo de 0,5.

En la wikipedia hay una explicación excelente de la Curva ROC